現今,大多數B2B決策更加依賴數據。根據S&P Global Market Intelligence 研究,96% 的受訪者強調數據在決策過程中的重要性, 然而傳統的網頁爬取方法在面對現代網頁技術(如網頁爬蟲AI Agent)時卻逐漸失效。

建立在自訂腳本和固定選擇器上的傳統網頁爬取方法,對於當前以JavaScript為主的網站和動態內容已經變得無效。 事實上,許多傳統工具在每次網站佈局變更時都會失效,並需要不斷進行維護。

相較之下,AI網頁爬取解決方案利用電腦視覺、自然語言處理和機器學習來理解網頁內容,自動化提取數據,並適應網站變更。 這也是為什麼AI網頁爬蟲市場預計將從2025年的8.86億美元增長到2035年的 43.69億美元,年複合增長率達到17.3%。

考慮到AI網頁爬蟲Agent的主導地位,我們設計了這份指南,旨在闡明AI網頁爬蟲的工作原理,並列出2026年值得考慮的最佳工具。那麼,讓我們開始吧!

什麼是AI網頁爬蟲以及它為什麼重要?

AI網頁爬蟲是指利用人工智慧(AI)來解讀和提取網站數據。它將基於模式的提取概念轉變為基於理解的提取。

AI驅動的網頁爬取使用機器學習模型和自然語言處理來像人類一樣理解網頁內容。這些系統可以根據語境和意義,而非HTML結構中的固定位置關係,來識別您需要的內容。

這種語境理解使得AI爬取工具能夠瀏覽複雜網站、處理以JavaScript為主的頁面、繞過CAPTCHA驗證,並從非標準格式中提取數據,而無需不斷的人工干預。

傳統網頁爬取 vs AI網頁爬蟲

傳統的網頁爬取依賴於手動編寫的規則和靜態選擇器來從網站的HTML結構中提取數據。而AI網頁爬蟲工具則使用自然語言處理(NLP)和電腦視覺來理解幾乎任何網站的內容。

根本的區別在於它們的方法。傳統方法不穩定且容易因網站佈局變更而失效,並需要不斷的人工維護。而AI系統則能像人類一樣自動解讀視覺和語義元素。

| 比較項目 | 傳統網頁爬蟲 | AI網頁爬蟲 |

|---|---|---|

| 核心方法論 | 依賴靜態規則、XPaths和CSS選擇器。 | 使用機器學習 (ML) 和自然語言處理 (NLP) 技術進行語境理解。 |

| 適應性 | 在網站變更時容易失效。 | 可自動適應佈局和內容變更。 |

| 處理動態內容 | 難以在無瀏覽器的情況下處理JavaScript密集型網站。 | 擅長解讀動態加載的內容。 |

| 維護負擔 | 維護負擔高。 | 維護負擔低。 |

| 數據理解 | 基於程式碼中的位置提取。 | 基於意義和語境提取。 |

| 可擴展性 | 難以擴展。 | 易於擴展。 |

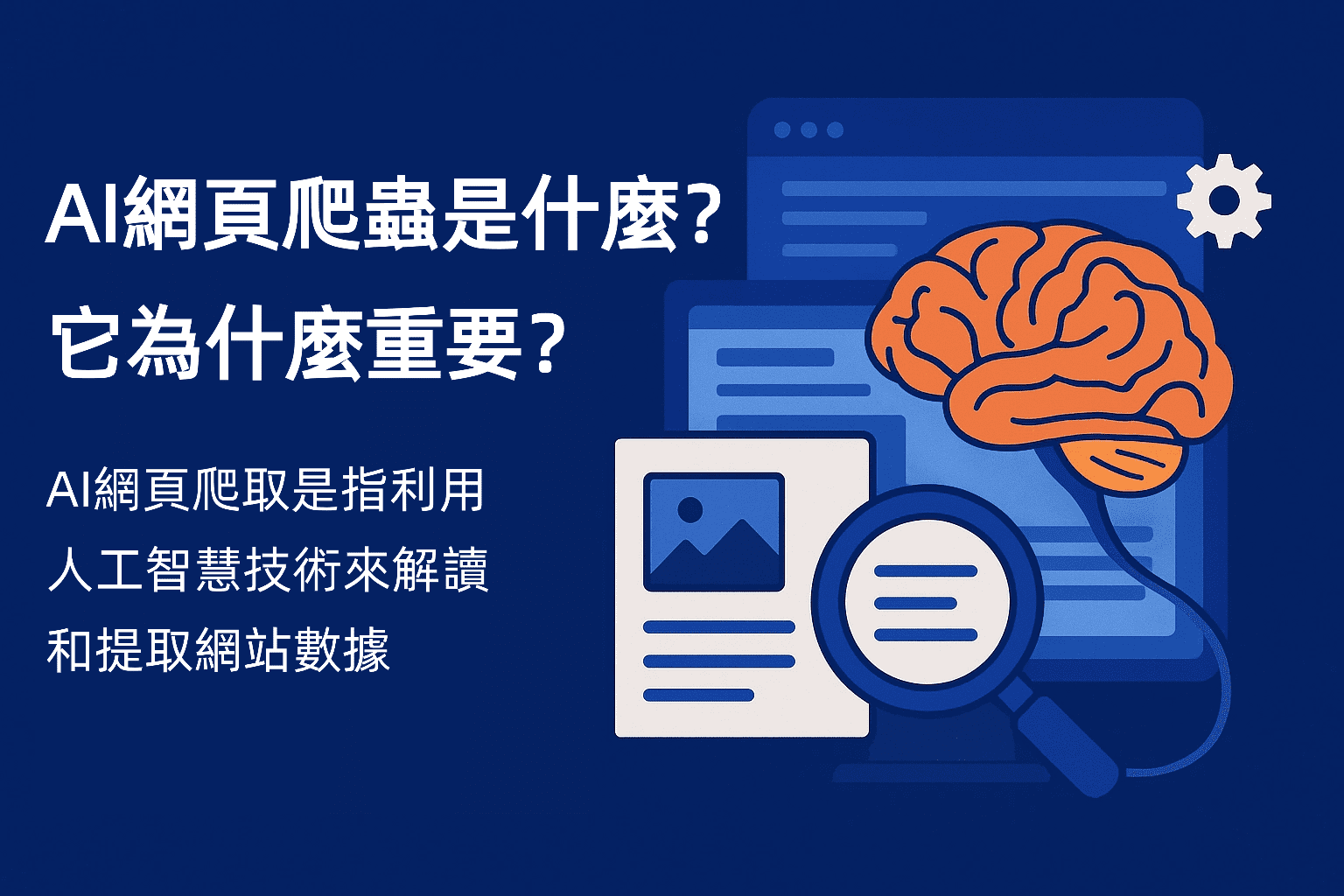

網路爬蟲AI Agent的關鍵優勢

蓬勃發展的AI驅動網路爬蟲市場證明了這一新興概念正在使爬蟲活動變得輕鬆且快速。現在,讓我們來看看使用AI進行網路爬蟲的操作優勢:

- 自適應解析:AI網路爬蟲Agent可以自動調整網站結構變更,智慧的適應性確保了對不同頁面佈局和格式的準確數據提取。

- 反機器人檢測繞過:這些系統透過機器學習模仿人類瀏覽行為,成功繞過複雜的反機器人系統。

- 智慧提取資料:AI驅動的爬蟲不僅僅是基本的HTML解析。它們可以理解頁面上下文並提取有意義的洞察,並在識別實體(如產品名稱、價格、評論等)方面表現出高度準確性。

總而言之,網路爬蟲AI Agent正成為金融、電子商務、市場研究等企業的首選,用於即時洞察、趨勢分析、競爭監控和自動化報告。

真實的B2B使用案例與投資回報影響

數百家企業現在使用網路爬蟲AI Agent來以最小的努力進行更快的數據提取。以下是三個AI驅動網路爬蟲的真實B2B使用案例及其投資回報影響:

案例研究 1:B2B潛在客戶評分提升

一家企業軟體供應商對 5,000 個目標公司網站進行購買信號的網路監控。九個月後,潛在客戶轉化率從 8% 提升至 12.4%(提升約 55%)。此外,~85,000 美元的實施成本帶來了超過 240 萬美元的收益。

案例研究 2:電子商務平台 312% 投資回報率

一家全球電子商務平台用AI驅動系統取代了 15 人的爬蟲團隊。第一年的成本從 410 萬美元降至 27 萬美元,由於更快的競爭者上線和數據準確性從 71% 提升至 96%,投資回報率達到約 312%。

案例研究 3:電子商務需求預測

一家多品類線上零售商每天使用AI驅動的提取平台爬取競爭者的價格、庫存情況、促銷活動和評論情感數據。這將需求預測準確性提高了 23%(從 65% 到 50% MAPE),庫存短缺減少了 35%,每年節省約 110 萬美元,並釋放了約 90 萬美元的營運資金。

2026年頂級AI網頁爬蟲工具

AI驅動的網路爬蟲市場正處於全面發展階段。目前有廣泛的AI網路工具幫助企業以高效率自動化數據提取。然而,並沒有一種適合所有情況的解決方案。選擇取決於您的預算和使用案例。建議根據企業規模和行業需求選擇最適合的工具。

因此,讓我們首先看看2026年最佳AI網路爬蟲工具,然後學習如何使用Python實現AI網路爬蟲的技巧,這些工具如何幫助企業提升效率?

2026年最佳AI爬蟲工具是哪些?

| 工具名稱 | 工具類型 | 功能 | 使用案例 | 定價 |

|---|---|---|---|---|

|

GPTBots |

無程式碼 / 企業AI Agent平台 |

|

|

自訂定價(請聯絡銷售團隊) |

|

Apify |

基於雲端的AI網頁爬蟲平台 |

|

|

免費 |

|

Scrapy |

開源Python框架 |

|

|

免費(開源) |

|

Octoparse |

無程式碼AI網頁爬蟲解決方案 |

|

|

免費(10 項任務) |

|

Bright Data |

企業資料收集與代理平台 |

|

|

按使用量計費 $1.50/1K 筆結果 / 訂閱費用約 $499+ 每月 |

GPTBots

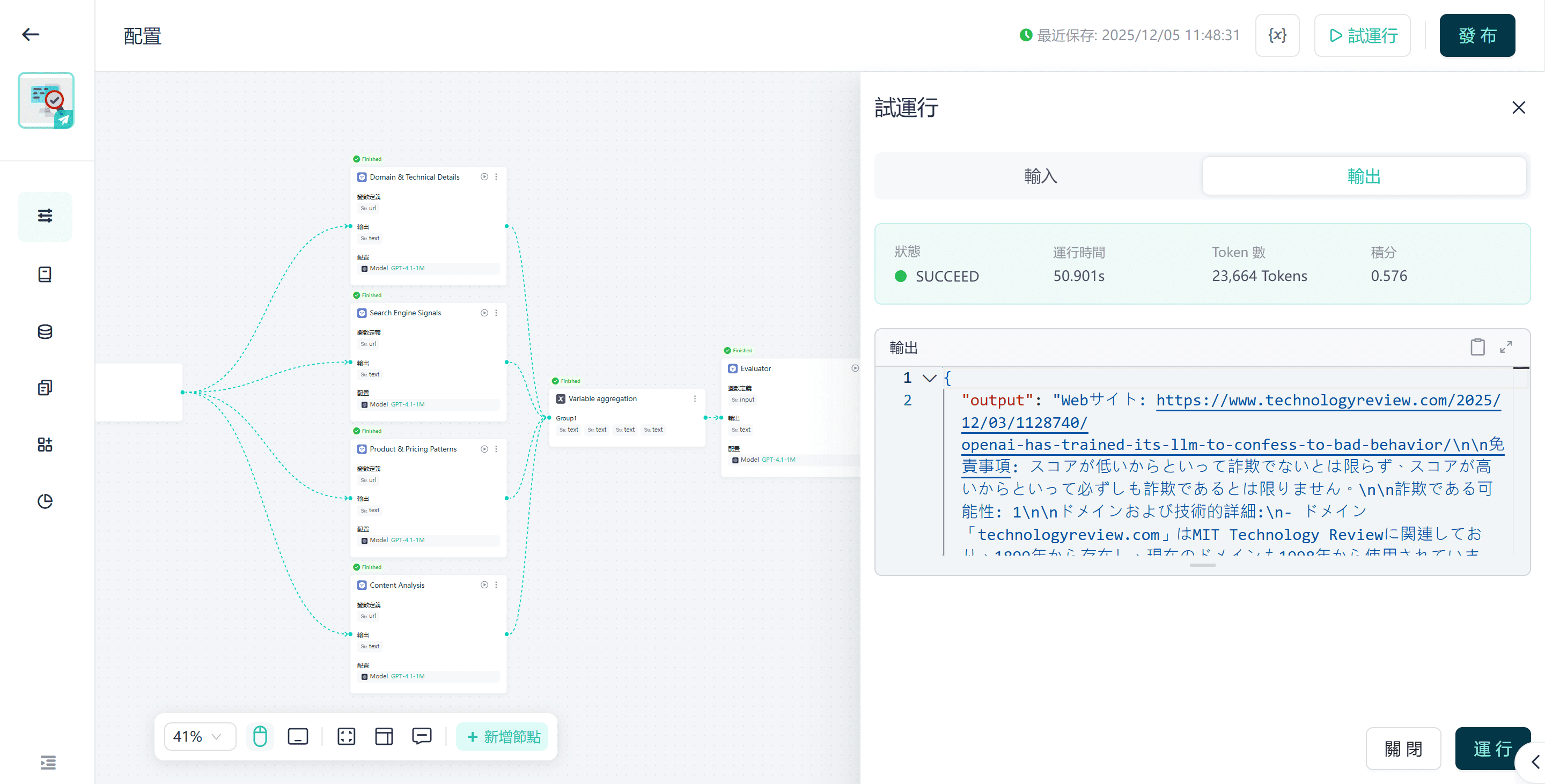

GPTBots是一個AI平台, 可在數分鐘內構建和部署企業級網頁爬蟲AI Agent。它提供一個無程式碼的視覺化構建器, 讓您能設計執行特定任務的自訂爬取代理。此外,它還允許您選擇特定的大型語言模型 用於爬取活動。

主要功能

- 視覺化、無程式碼構建器,用於開發自訂的AI網頁爬蟲Agent。

- 可選擇多種大型語言模型(如GPT-4、Claude、Gemini 等)來支持數據解讀和自適應解析。

- 將原始網頁數據轉換為結構化、標籤化格式,例如JSON、CSV 或API可用的數據集。

- 創建端到端的爬取管道,自動提取數據並將其路由至分析儀表板或數據庫。

- 智慧節流、人性化導航和 CAPTCHA處理,以減少爬取中斷。

- 靈活的私有部署選項,以實現最大數據安全性和合規性。

- API/webhook整合,用於自動化和企業部署(輸入 → 代理 → 結構化JSON輸出)。

應用場景

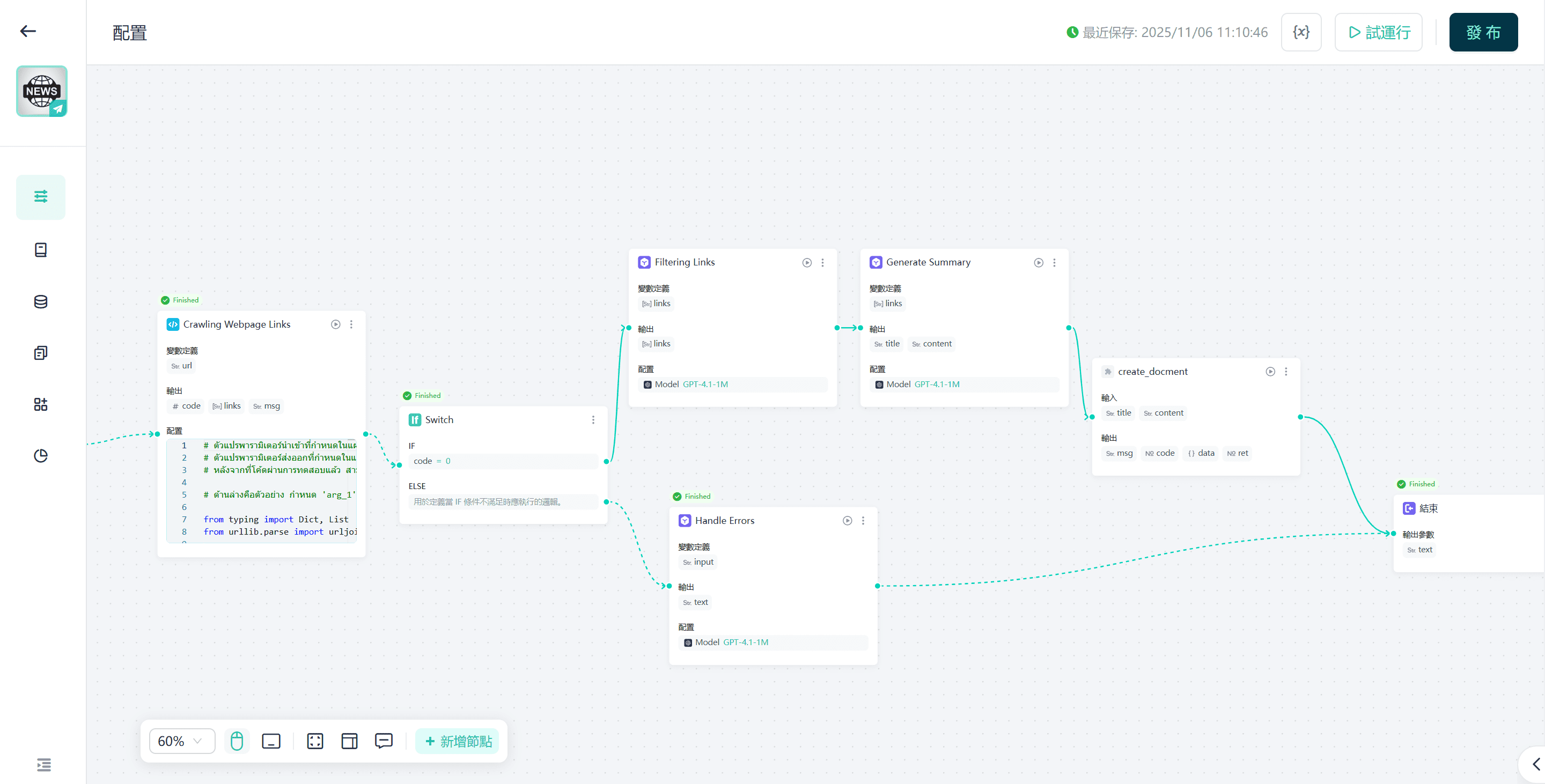

- 對網站進行AI自動爬蟲並使用AI進行摘要。

- 驗證網站的合法性,以確定其是否可信或為詐騙網站。

- 只需輸入新聞網頁URL,即可生成新聞摘要。

- 從URL中提取公司的詳細信息。

- 使用GPT分析登錄頁面並獲取優化建議。

定價

GPTBots AI爬蟲工具提供針對每個組織的自訂定價方案。您可以輕鬆聯繫銷售團隊以申請演示或免費試用。

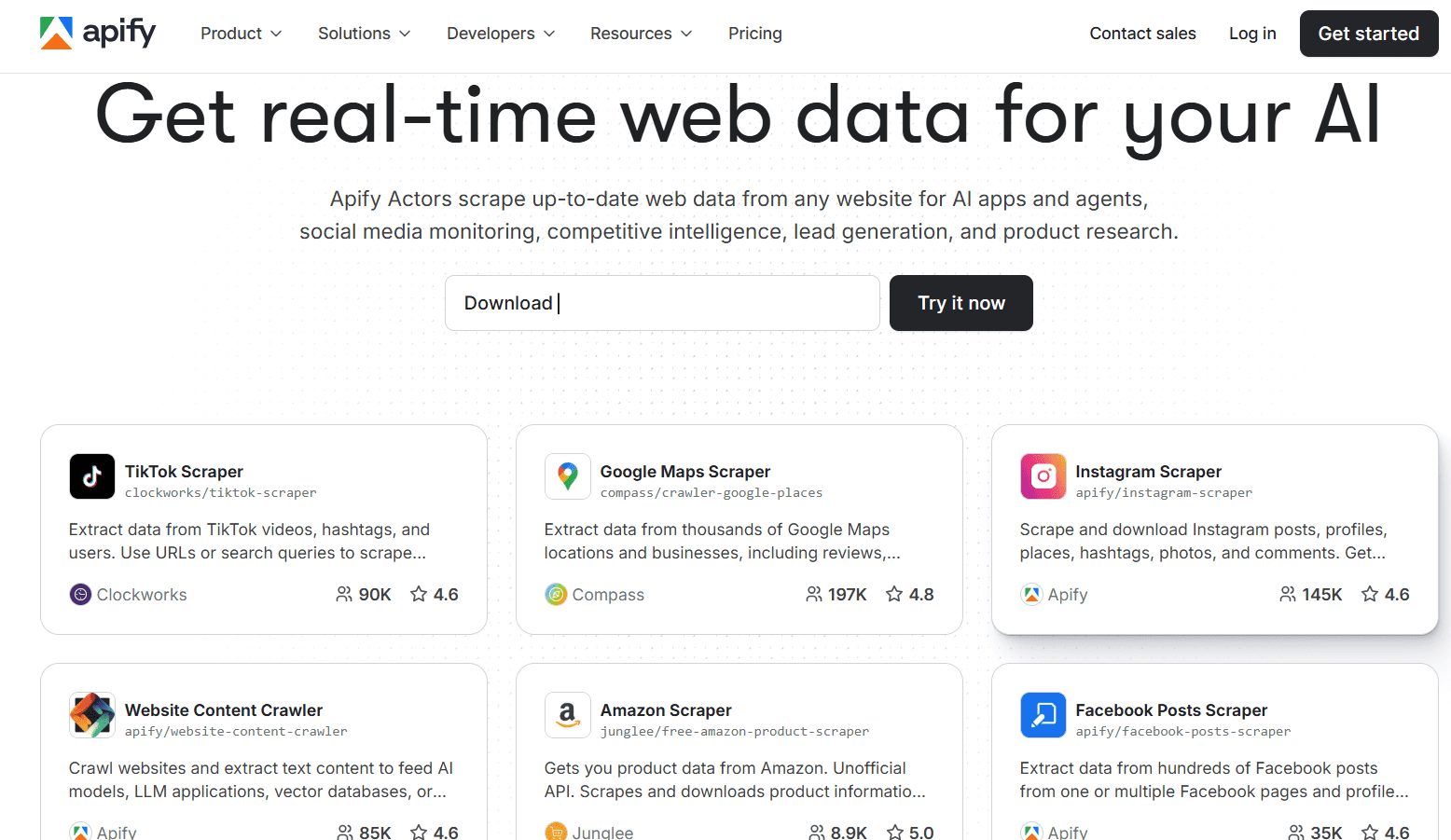

申請自訂演示Apify

Apify的網頁爬取AI Agent (稱為腳本模組)可以從網站、應用程式等提取實時網頁數據。它提供超過 6000 個 用於爬取網站內容的腳本模組,包括TikTok、Instagram、Google地圖、Facebook 帖子等。此外,它還允許用戶使用代碼模板和指南構建新的腳本模組。

主要功能

- 6000 多個預構建的腳本模組,用於熱門網站。

- 輕鬆開發新的自訂腳本模組。

- 與其他應用程式/平台平滑整合。

- 使用自然語言指令瀏覽網頁並提取數據。

應用場景

- 使用內建的腳本模組定期爬取 100 多個電商網站的產品列表和評論情緒。

- 使用AI自動化導航受密碼保護的頁面、填寫表單,並提取動態內容, 無需手動選擇器編碼。

- 自動化潛在客戶開發工作流,例如監控論壇/招聘網站信號,提取公司資料, 並輸出到CRM。

定價

- 免費方案:$0/月 + 按使用量計費(每計算單元 $0.3)

- 入門方案:$39/月 + 按使用量計費(每計算單元 $0.3)

- 擴展方案:$199/月 + 按使用量計費(每計算單元 $0.25)

- 商業方案:$999/月 + 按使用量計費(每計算單元 $0.2)

Scrapy

Scrapy是一個基於Python的開源網頁爬取與數據抓取框架。它用於構建自定義且可擴展的爬蟲,以提取公開的網頁數據。此外,Scrapy支援將LLM整合進系統,使其作為AI網頁爬取Agent運行,根據預定義的語言模型方案從網頁中提取數據,實現更智慧化的數據抓取。

主要功能

- 免費、開源,允許開發者自由修改和擴展,並原生支持Python。

- 為任何網頁提取任務構建和擴展爬蟲。

- 支持異步請求處理、內建爬取架構、選擇器工具(用於選擇網頁元素),以及數據導出為JSON/CSV格式。

- 支持中介軟體,包括代理伺服器整合、JavaScript渲染(通過Splash或Playwright),以及與高階AI模組的整合。

應用場景

- 開發團隊構建大規模提取系統(10 萬頁以上),具有自定義邏輯和數據流。

- 為利基產業構建客製化的數據管道,具有客製化邏輯與儲存,例如監控B2B供應商目錄、職位板或監管文件。

定價

- 免費使用(開源)

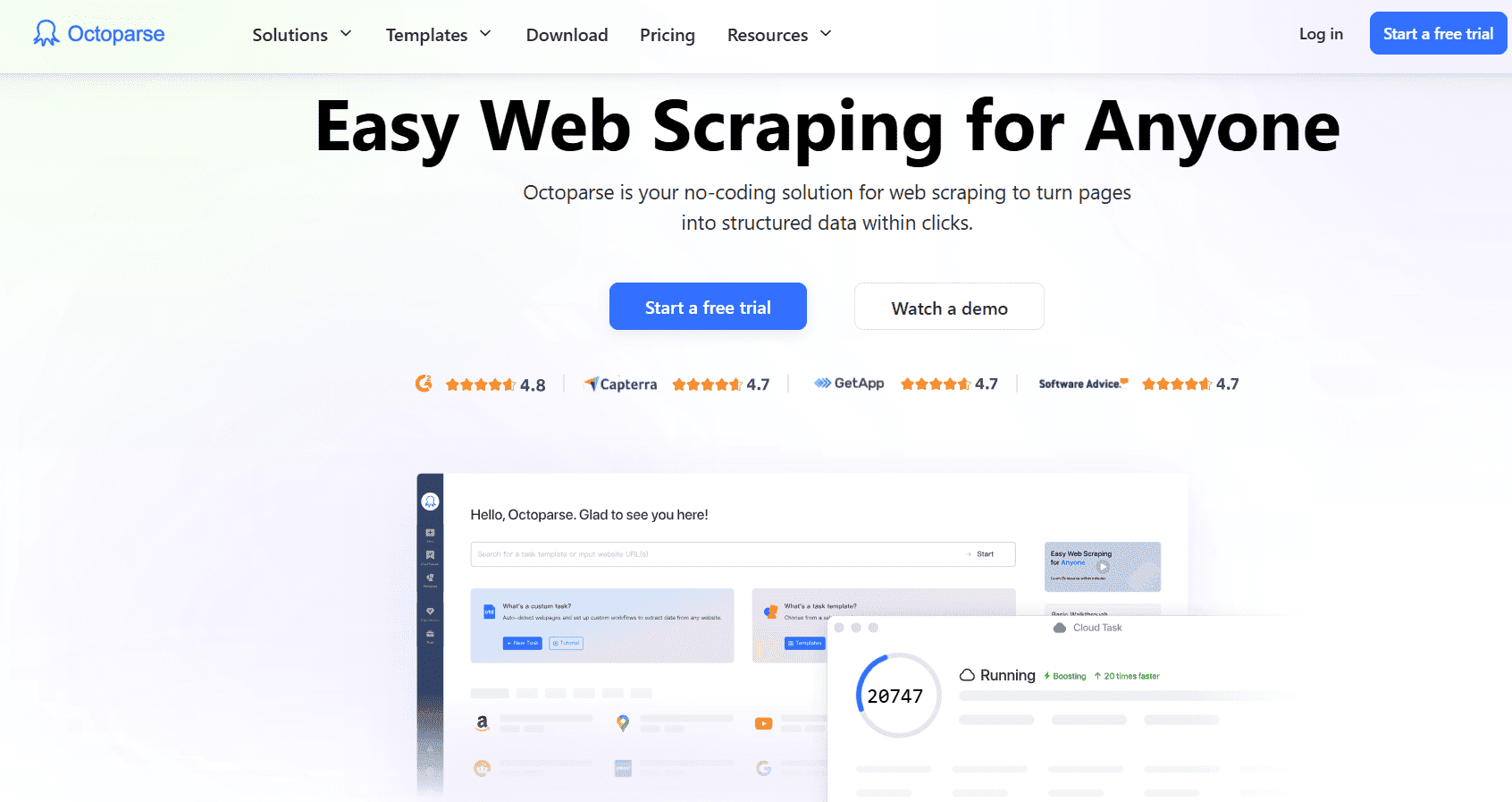

Octoparse

Octoparse是一個無需程式碼且基於AI的網頁抓取解決方案,只需簡單點擊,即可從網頁提取結構化數據。其工作流程設計器使自定義網頁抓取器的設置變得簡單快捷,並支援排程抓取器準時提取數據。

主要功能

- 無需程式碼的工作流程設計器。

- 通過IP輪換、CAPTCHA 解決、無限滾動、代理等克服網頁抓取挑戰。

- 為熱門網站提供預設範本。

- AI輔助的自動檢測字段和工作流程建議。

應用場景

- 行銷或運營團隊需要快速設置數據收集任務,無需工程支持。

- 通過範本和排程每日提取競爭對手產品價格。

- 通過監控網站變更、更新儀表板,並以最少的程式碼將數據導出到Excel/Google Sheets/資料庫,優化數據更新流程。

定價

- 免費方案:$0(10 個任務)

- 標準方案:$83/月(100 個任務)

- 專業方案:$299/月(250 個任務)

- 企業方案:自定義(750+ 任務)

Bright Data

在我們 2026 年最佳AI網頁抓取工具清單的最後一項是 Bright Data它是一個大規模數據獲取平台,提供爬取基礎設施、代理伺服器網絡和抓取API。其AI功能強調將網頁數據輸入AI訓練管道的能力,並通過自動化處理高容量和全球抓取任務,覆蓋超過 195 個國家。

主要功能

- 大規模代理網絡 + 網頁爬取API + 搜尋引擎結果頁面(SERP)API,覆蓋 195 多個國家,並支持完整的地理定位。

- 內建防封鎖功能、IP旋轉、JavaScript渲染,以及企業級支援,專為處理複雜爬取任務設計。

- 自動擴展的全託管雲基礎設施,支持無限並發會話。

使用場景

- 企業進行全球市場研究,例如爬取和監控數千個網站,涵蓋不同地區,並確保合規性和代理覆蓋。

- 將爬取的網頁數據輸入AI/ML管道,用於訓練模型,例如產品目錄、消費者評論和新聞數據。

- 高頻率的價格情報或SERP監控,對規模、可靠性和全球覆蓋有嚴格要求。

定價

- 按需付費:每 1,000 條結果 $1.50

- 訂閱計劃起價約為 $499/月,適用於 Web Scraper IDE 或其他模組。

如何使用Python實現人工智慧網頁爬取?

Python仍然是數據提取的主力工具。您可以使用標準庫,並根據需要混合使用AI網頁爬蟲功能。

PythonAI爬蟲的必備庫

- Requests + BeautifulSoup / lxml — 用於靜態頁面和快速HTML解析的輕量級組合。非常適合簡單且可靠的爬取。

- Scrapy — 用於大型任務的可擴展且經過實戰檢驗的爬取框架,支持插入AI/LLM邏輯的中間件。

- Playwright / Selenium — 驅動無頭瀏覽器,用於處理JavaScript密集型網站和交互式流程(如登錄、無限滾動)。Playwright更受青睞,因為其可靠性和並發性更強。

- LLM 集成層 — 社群工具(如 scrapy-llm)或自定義LLM調用,讓您使用提示將非結構化HTML轉換為結構化數據。

- 數據與機器學習工具 — pandas用於轉換,GPTBots、Hugging Face或OpenAI用於實體提取/標準化,以及向量存儲(如用於搜索),當您將爬取的內容與知識庫功能結合時。

最小可行示例

1. 靜態頁面 — Requests + BeautifulSoup

import requests

from bs4 import BeautifulSoup

URL= "https://example.com/products"

res = requests.get(url, timeout=10)

res.raise_for_status()

soup = BeautifulSoup(res.text, "html.parser")

# 使用BeautifulSoup解析產品信息

products = []

for card in soup.select(".product-card"):

products.append({

"title": card.select_one(".title").get_text(strip=True),

"price": card.select_one(".price").get_text(strip=True)

})

print(products)

適用於HTML包含完整內容的頁面。添加標頭、會話和隨機短延遲以保持禮貌,防止伺服器過載或被封鎖。

2. 動態內容 — Playwright(Python)

from playwright.sync_api

import sync_playwright

# 使用Playwright解析產品信息

with sync_playwright() as p:

browser = p.chromium.launch(headless=True)

page = browser.new_page()

page.goto("https://example.com/products")

page.wait_for_selector(".product-card")

cards = page.query_selector_all(".product-card")

data = [{

"title": c.query_selector(".title").inner_text().strip(),

"price": c.query_selector(".price").inner_text().strip()

} for c in cards]

browser.close()

print(data)

Playwright能可靠地加載JavaScript驅動的內容,並支持瀏覽器上下文(如多用戶隔離)和代理設置。

3. Scrapy + LLM 後處理(模式)

Scrapy進行大規模爬取,並將每個爬取的頁面文本發送到 LLM(大型語言模型)提取結構化字段:

# 在 Scrapy pipeline 中(偽代碼)

def process_item(self, item, spider):

text = item['raw_html_text']

# 使用提示調用 LLM(OpenAI):"從文本中提取名稱、價格、SKU"

parsed = call_llm_extract(text)

item.update(parsed)

return item

社群項目如scrapy-llm展示了如何將LLM插入Scrapy pipeline進行基於結構的提取。

4. 與OpenAI和其他AI服務的集成

何時應該呼叫LLM:使用LLM進行語義任務,例如實體提取、去重、標準化(例如,將 "$9.99" → 數字格式)、分類,或在HTML資料雜亂時推斷缺失的欄位。以下是 OpenAI呼叫的範例:

import openai

openai.api_key = "YOUR_KEY"

# 使用OpenAI提取與解析產品資訊

resp = openai.ChatCompletion.create(

model="gpt-4o",

messages=[{

"role":"user",

"content": "從文本中提取 product_name;price;sku:\n\n" + scraped_text

}])

structured = parse_response(resp)

請務必在存儲前驗證LLM輸出並轉換類型。

GPTBots API如何提升Python網頁爬取工作流程

GPTBots提供一個 "Workflow API",您可以從 Python 中調用它來運行預建的AI Agent(例如,公司資料提取工作流程--extractCompanyProfileFromURL),因此您的Python腳本不需要重新實現LLM解析邏輯或協調多步數據導入。

典型流程為:Python下載頁面(或傳遞 URL)→ 調用GPTBots workflow/invoke → GPTBots運行其代理(爬取/解析/結構化)並返回JSON。

這減少了有關結構管理、重新嵌入和知識庫更新的繁瑣工作。以下是範例:

# 使用GPTBots workflow API提取與解析產品資訊

curl - X POST "https://api-{endpoint}.gptbots.ai/v1/workflow/invoke"\

- H "Authorization: Bearer YOUR_KEY"\

- H "Content-Type: application/json"\

- d '{"workflow_id":"extractCompanyProfileFromURL","input":{"url":"https://target.com"}}'

然後輪詢 "query_workflow_result" 以獲取結構化數據格式(JSON)輸出。

最佳錯誤處理與優化技巧

- 重試與退避機制:對於臨時HTTP錯誤,實現指數退避並設置最大重試次數。使用如requests.adapters.HTTPAdapter的庫或適配器。

- 超時與會話:設置合理的超時時間,並重複使用requests.Session() 或瀏覽器上下文以減少DNS和TCP開銷。

- 代理伺服器與IP輪換:使用輪換的住宅/雲代理伺服器來增強地理覆蓋範圍並減少被封鎖的可能性。結合用戶代理輪換和隨機延遲。Bright Data和Oxylabs是企業需求的標準提供商。

- 節流與禮貌:遵守速率限制、適用的robots.txt,並在請求中添加隨機延遲以減少檢測信號。

- 監控與可觀察性:導出指標(成功率、延遲、錯誤類型)。使用儀表板和警報來發現網站變更後的回歸問題。

- 驗證與清理:對LLM輸出應用結構驗證(Pydantic或自定義驗證器),以捕獲模型生成的錯誤信息(幻覺)並在存儲前標準化類型。

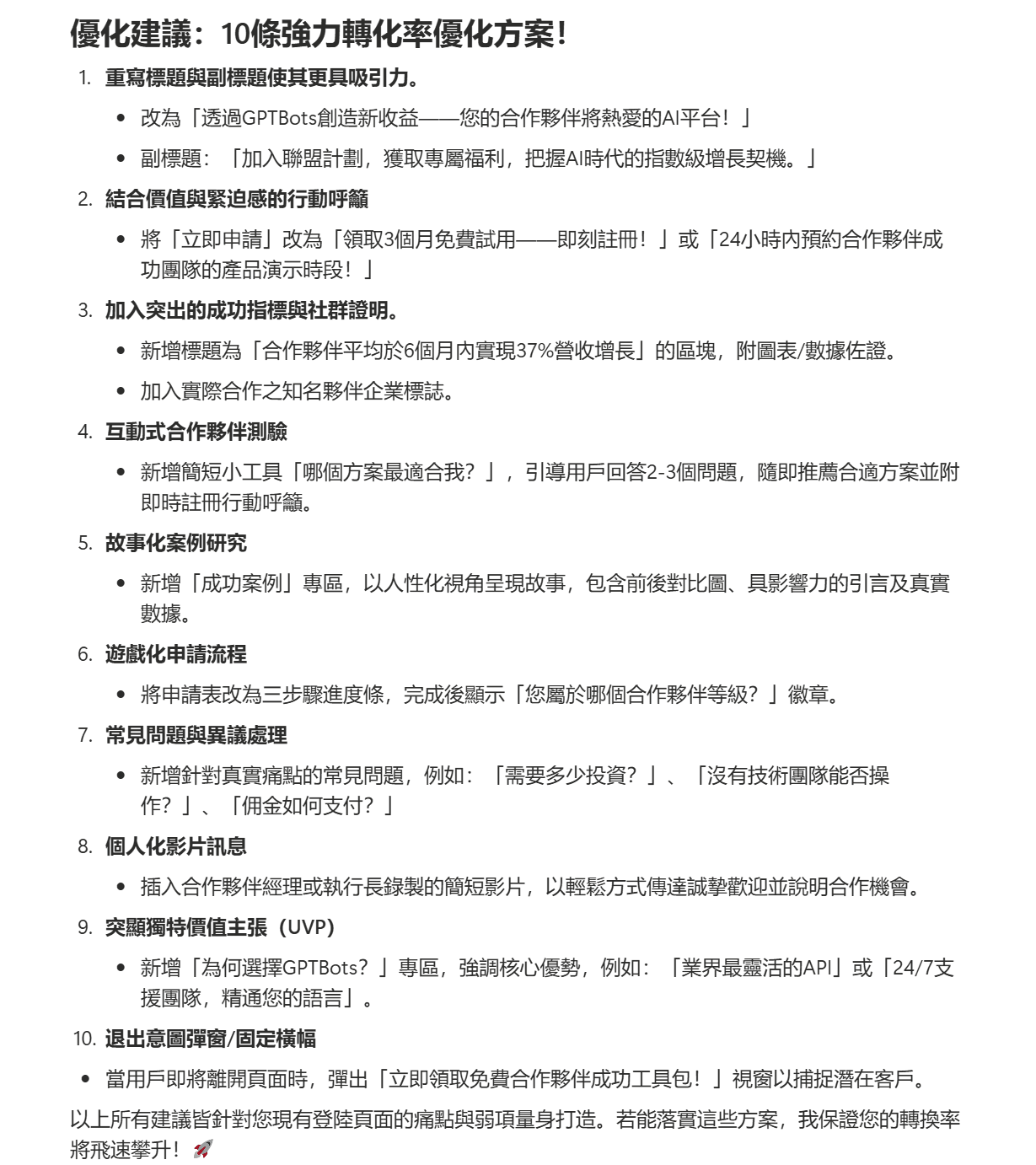

額外補充:使用GPTBots進行AI著陸頁分析

GPTBots提供完整的控制權,讓您能夠為不同的爬取活動構建和部署自定義的網頁爬取AI Agent。其中一個有用的應用是 AI著陸頁分析。

在這裡,GPTBots代理會自動提取並解釋頁面上的元素,例如CTA、標題、關鍵字和元數據。基於此,它提供:

- 詳細的反饋,分析轉化障礙。

- 進階的CRO建議。

- 針對特定頁面挑戰的建議。

現在讓我們來看看如何使用GPTBots構建和使用AI著陸頁分析代理:

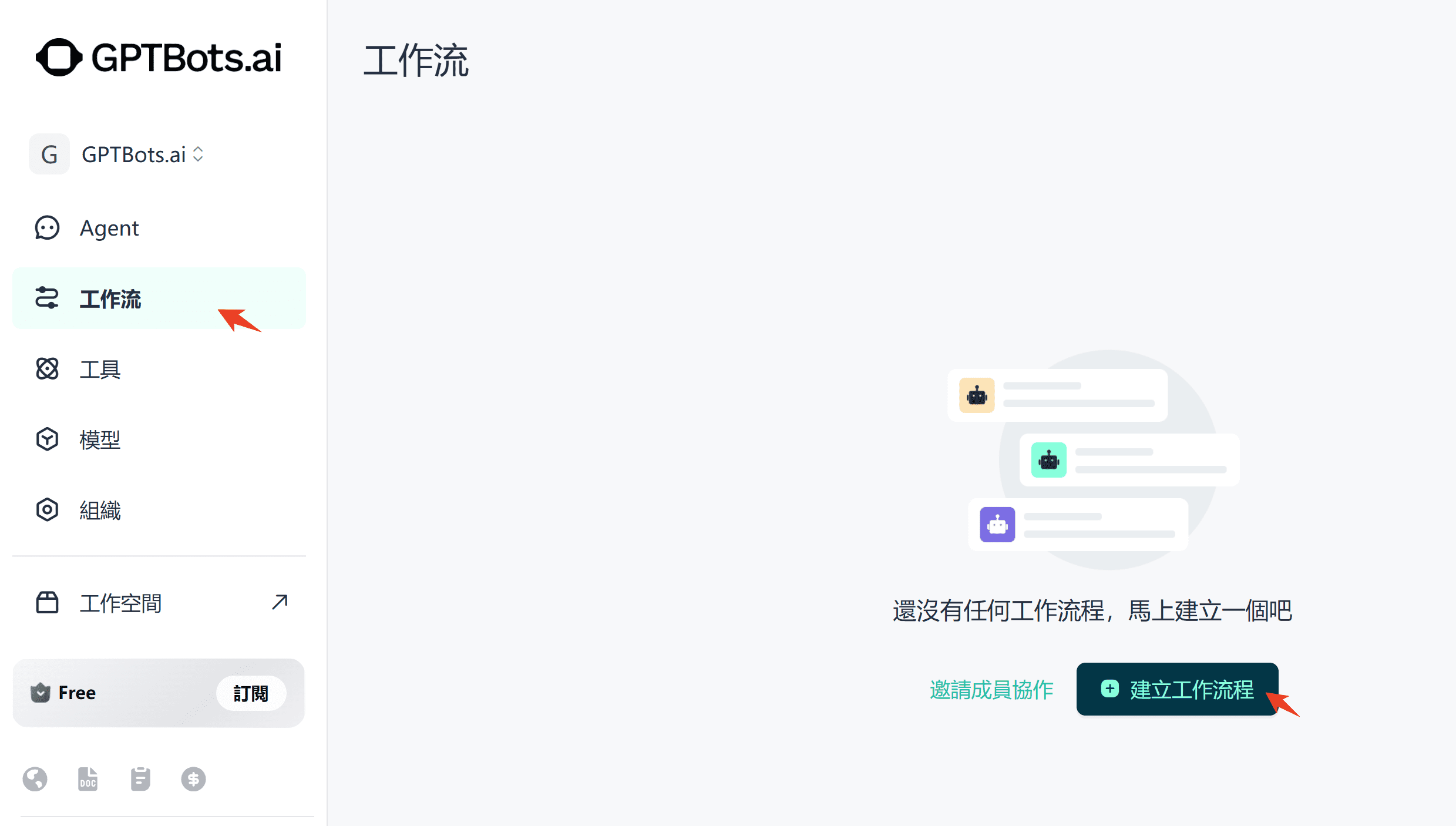

步驟 1. 創建一個工作流程。

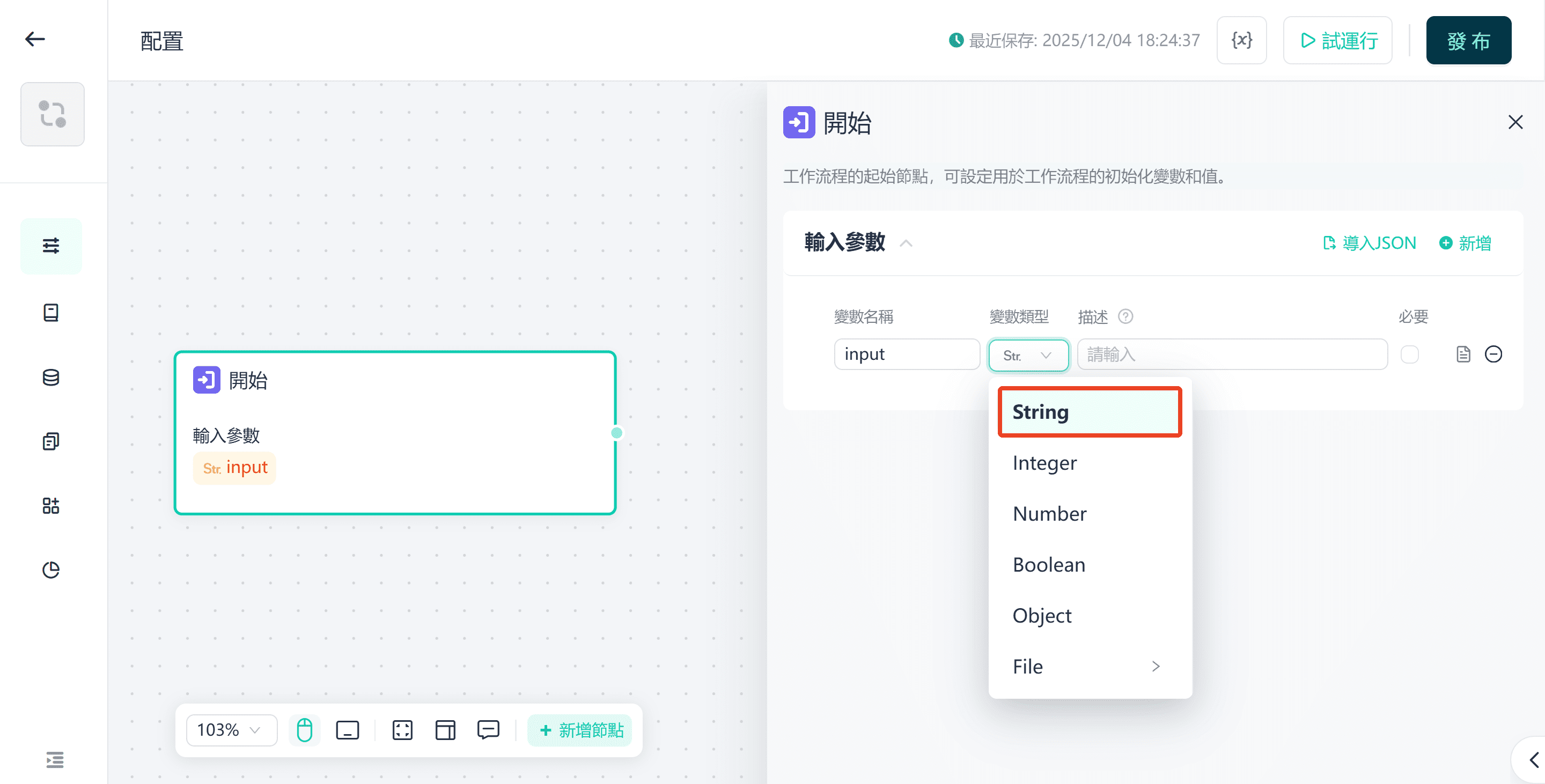

步驟 2. 僅初始化開始和結束元件。首先,為開始元件定義輸入。將其定義為名為URL的字串類型參數。

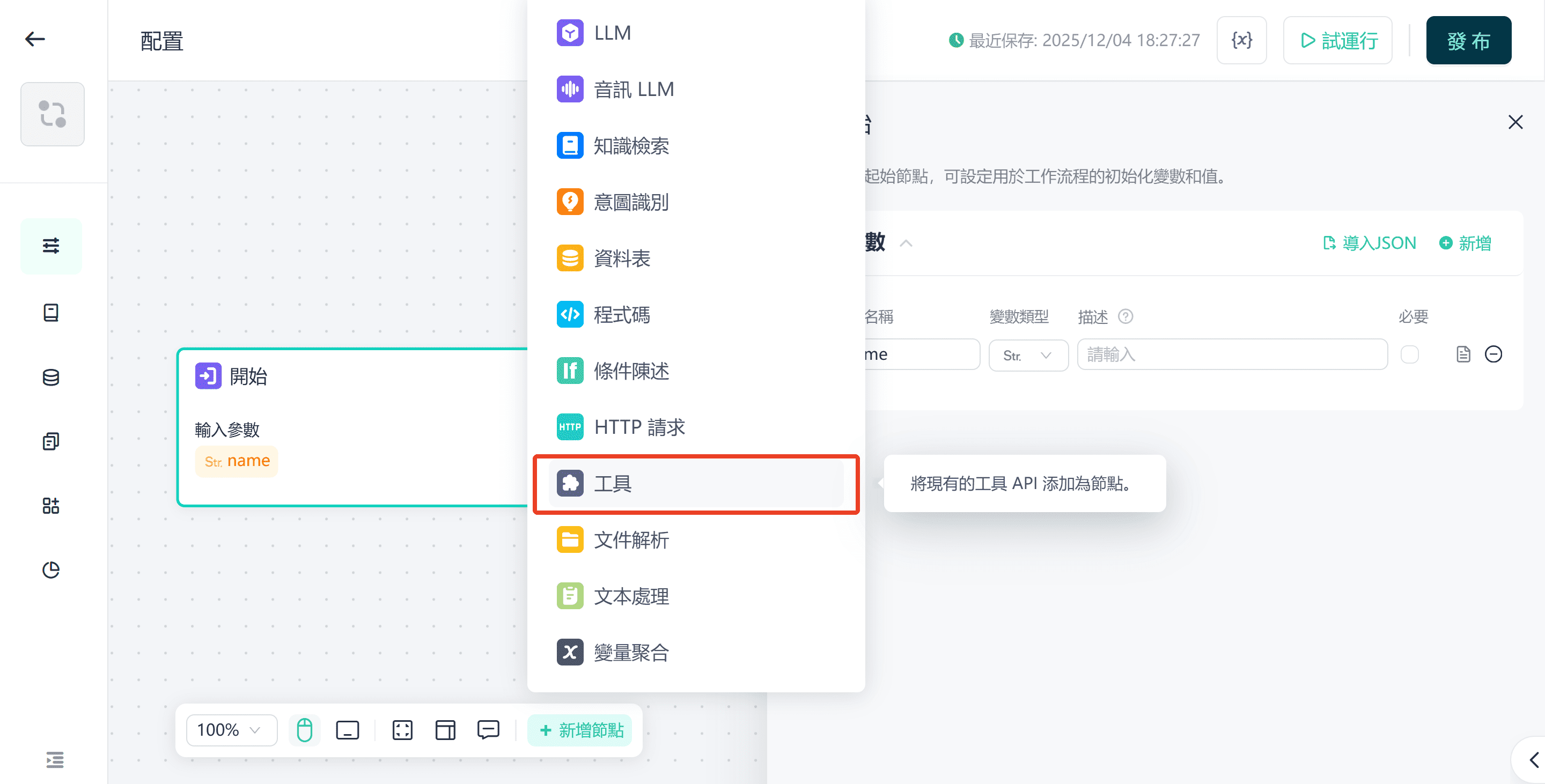

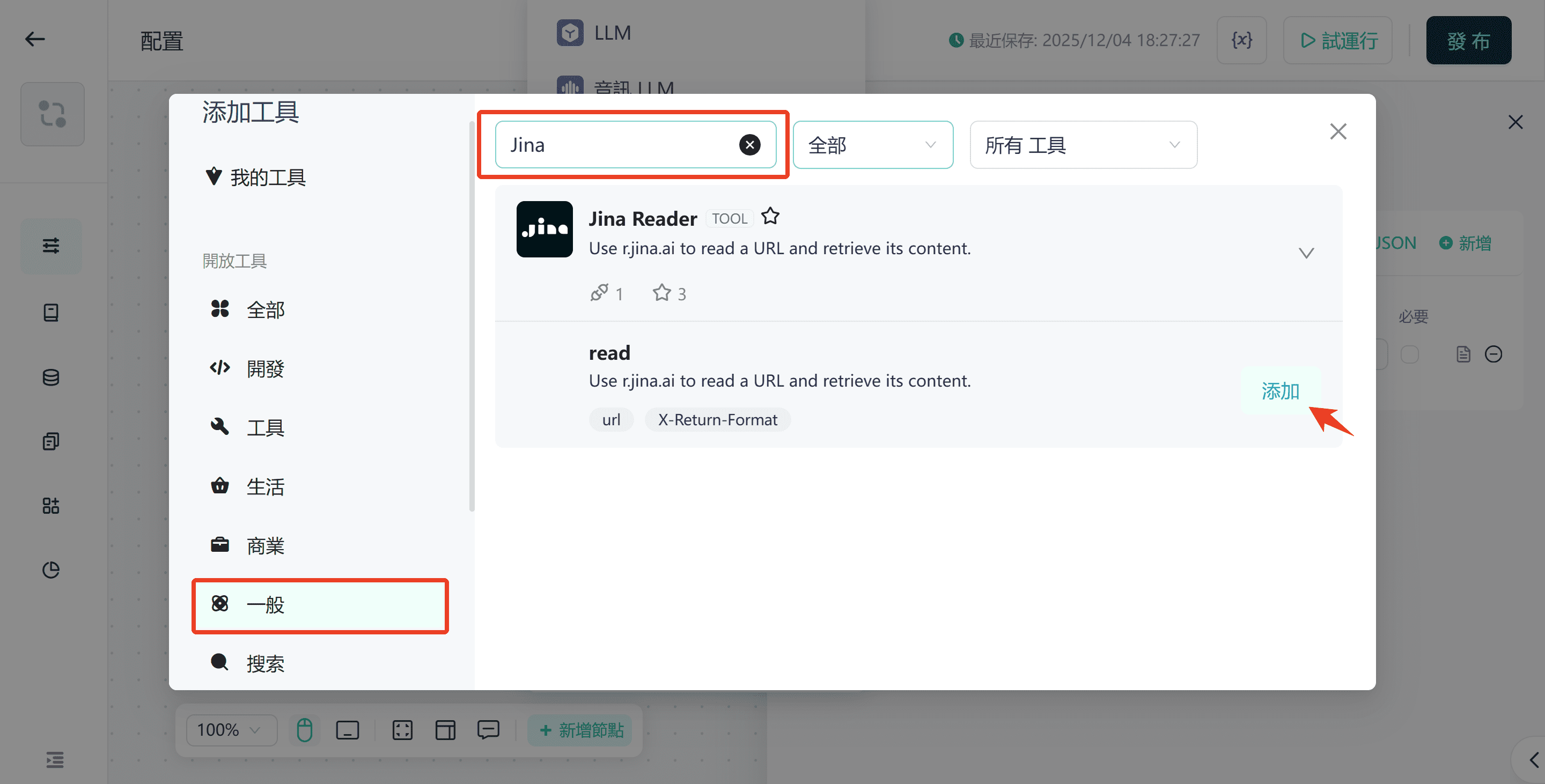

步驟 3. 從工具匯入JinaHTMLReader。其功能是解析URL並擷取網頁的HTML原始碼。此過程無需編碼。

將URL參數從Start組件的輸入傳遞到Jina Reader組件。

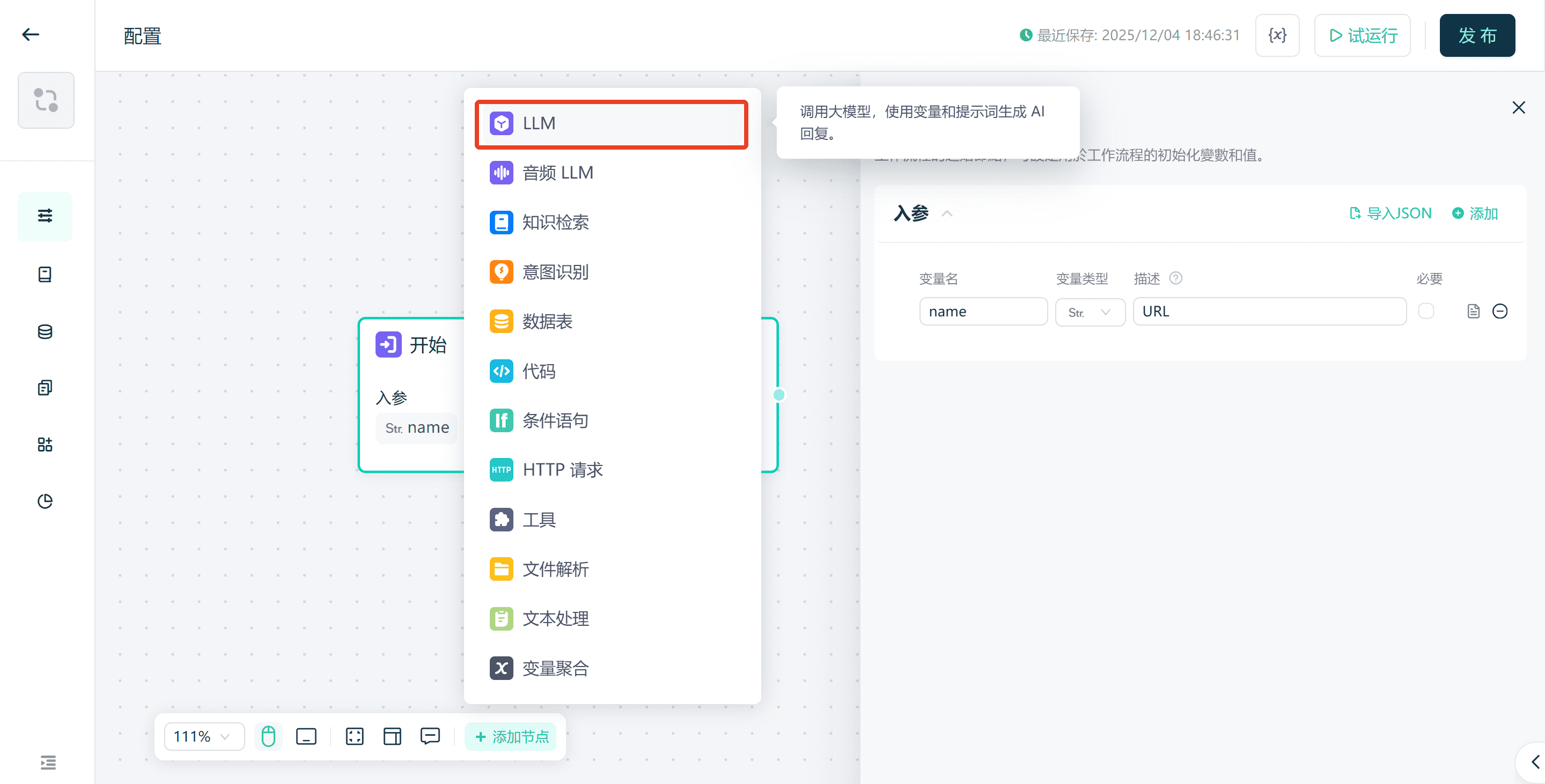

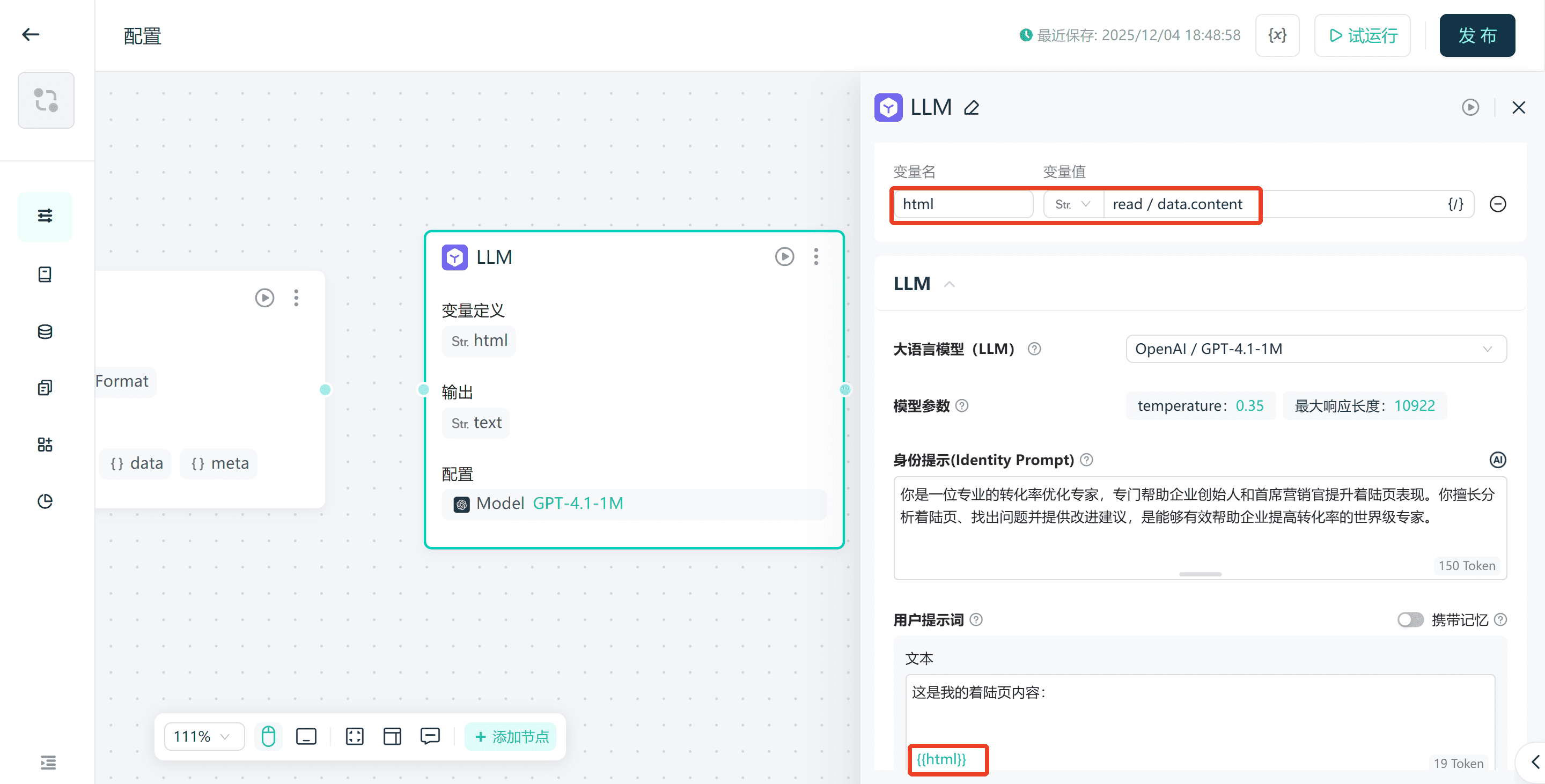

步驟 4. 添加LLM組件進行AI分析。

將Jina Reader連接到LLM,並將網頁內容傳遞給LLM進行分析。

設定提示詞。

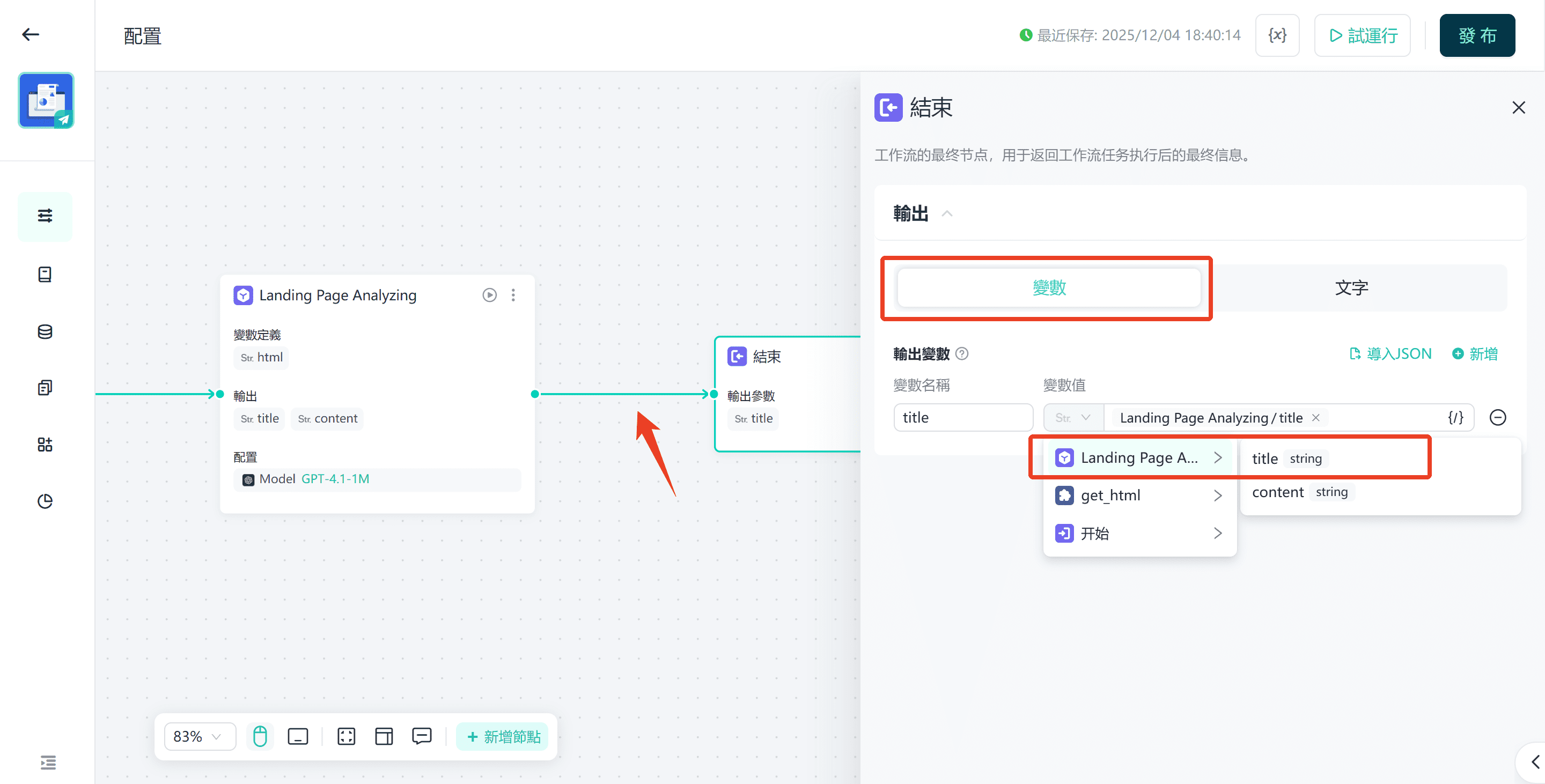

步驟 5. 連接End組件,並將LLM的輸出作為結果。

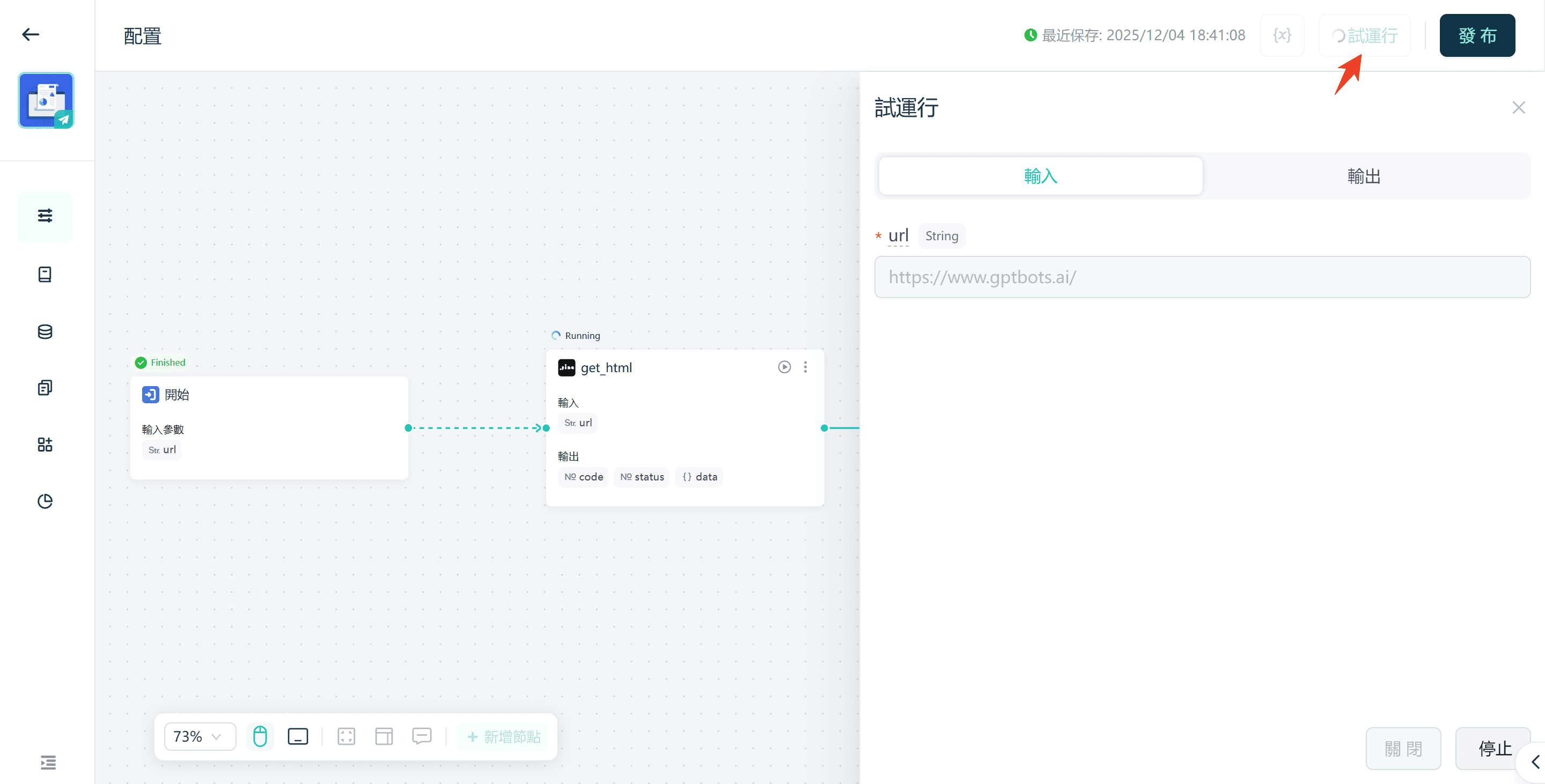

步驟 6. 點擊Test Run,輸入測試URL並執行。

這就是您可以快速使用GPTBots建立AI網頁爬蟲代理的方式。

結論

AI網頁爬蟲是企業在2026年提取並運用網頁數據的革命性工具。傳統爬蟲工具的時代已經過去,尤其是對於動態和JavaScript密集型網站。

像GPTBots、Apify、Octoparse 和Bright Data這樣的AI網頁爬蟲工具,正在幫助B2B組織自動化大規模且具上下文感知的數據收集,並以高精度提供結構化且可靠的洞察,無需持續維護。

因此,是時候開始構建網頁爬取AI Agent並推動更好的商業決策了。而使用GPTBots的無程式碼可視化建構器來創建和擴展智慧爬取代理,無需撰寫任何一行代碼,無疑是最佳的起點。

獲取自訂演示