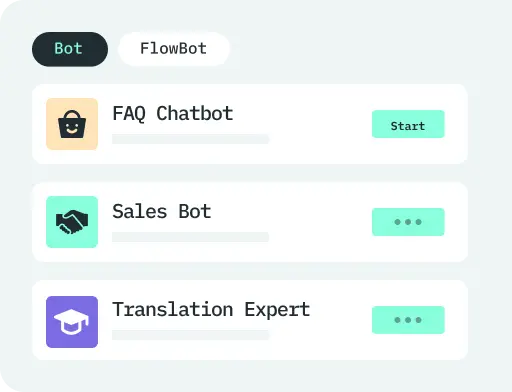

Create and Train AI Agents with Simple Clicks

- Build powerful AI Agents without coding experience

- Create Agents in minutes and automate workflows hourly

- Access best-practice AI Agent templates with one click

- Enable your staff to train and personalize AI Agents

- Integrates ChatGPT, DeepSeek & top AI models with flexible switching

Explore Features

![[2024 Guide] How to Make a Discord Bot Without Coding in 5 Minutes!](https://img.gptbots.cc/article/en/how-to-make-a-discord-bot.webp)

![[100% Working] How to Build an AI Chatbot for Telegram Without Coding](https://img.gptbots.cc/article/en/how-to-build-telegram-ai-chatbot.png)