ปัจจุบันการตัดสินใจในธุรกิจแบบ B2B ส่วนใหญ่พึ่งพาข้อมูลมากขึ้น โดย 96% ของผู้ตอบแบบสอบถามจาก S&P Global Market Intelligence Study เน้นย้ำถึงความสำคัญของการใช้ข้อมูลในกระบวนการตัดสินใจ อย่างไรก็ตาม วิธีการดึงข้อมูลจากเว็บไซต์แบบเดิมไม่สามารถรับมือกับเทคโนโลยีเว็บสมัยใหม่ (web scraping AI agents) ได้อีกต่อไป

วิธีดึงข้อมูลจากเว็บไซต์แบบเดิมที่ใช้สคริปต์เฉพาะและตัวเลือกแบบคงที่เริ่มไม่มีประสิทธิภาพเมื่อเจอกับเว็บไซต์ที่ใช้ JavaScript จำนวนมากและเนื้อหาแบบไดนามิก จริง ๆ แล้ว เครื่องมือเหล่านี้มักล้มเหลวทุกครั้งที่โครงสร้างเว็บไซต์เปลี่ยนแปลง และต้องคอยดูแลแก้ไขอยู่เสมอ

ในทางกลับกัน โซลูชันการดึงข้อมูลเว็บด้วย AI ใช้ computer vision, การประมวลผลภาษาธรรมชาติ และ machine learning เพื่อเข้าใจเนื้อหาเว็บ อัตโนมัติการดึงข้อมูล และปรับตัวตามการเปลี่ยนแปลงของเว็บไซต์ นี่จึงเป็นเหตุผลที่ตลาด AI web scraping คาดว่าจะเติบโตจาก 886.03 ล้านดอลลาร์ในปี 2025 เป็น 4,369.4 ล้านดอลลาร์ ภายในปี 2035 ด้วยอัตราการเติบโตเฉลี่ยต่อปี (CAGR) 17.3%

เมื่อ web scraping AI agents มีบทบาทมากขึ้น เราจึงจัดทำคู่มือนี้เพื่ออธิบายหลักการทำงานของ AI web scraping และแนะนำเครื่องมือที่น่าสนใจสำหรับปี 2026 มาเริ่มกันเลย!

AI Web Scraping คืออะไร และทำไมถึงสำคัญ?

AI web scraping คือการใช้เทคโนโลยีปัญญาประดิษฐ์ (AI) เพื่อแปลความหมายและดึงข้อมูลจากเว็บไซต์ โดยเปลี่ยนจากการดึงข้อมูลตามรูปแบบ (pattern-based extraction) ไปสู่การดึงข้อมูลด้วยความเข้าใจ (understanding-based extraction)

การดึงข้อมูลจากเว็บไซต์ด้วย AI ใช้โมเดล machine learning และการประมวลผลภาษาธรรมชาติเพื่อเข้าใจเนื้อหาของหน้าเว็บในแบบที่มนุษย์เข้าใจ ระบบเหล่านี้สามารถระบุสิ่งที่คุณต้องการได้จากบริบทและความหมาย ไม่ใช่แค่ตำแหน่งในโครงสร้าง HTML

ความสามารถในการเข้าใจบริบทนี้ทำให้เครื่องมือ AI scraping สามารถนำทางเว็บไซต์ที่ซับซ้อน จัดการกับหน้าเว็บที่มี JavaScript หนัก ๆ ข้ามผ่าน CAPTCHA และดึงข้อมูลจากรูปแบบที่ไม่เป็นมาตรฐานได้ โดยไม่ต้องปรับแต่งด้วยมือบ่อย ๆ

เปรียบเทียบ Traditional Web Scraping กับ AI Web Scraping

การดึงข้อมูลจากเว็บไซต์แบบดั้งเดิมจะอาศัยกฎที่เขียนด้วยมือและตัวเลือกแบบคงที่เพื่อดึงข้อมูลจากโครงสร้าง HTML ของเว็บไซต์ ในขณะที่เครื่องมือ AI web scraping ใช้การประมวลผลภาษาธรรมชาติ (NLP) และ computer vision เพื่อเข้าใจเนื้อหาจากเกือบทุกเว็บไซต์

ความแตกต่างหลักอยู่ที่วิธีการเข้าถึง วิธีดั้งเดิมมีข้อจำกัด เปราะบาง และมักล้มเหลวเมื่อโครงสร้างเว็บไซต์เปลี่ยน อีกทั้งยังต้องดูแลแก้ไขด้วยมืออยู่เสมอ ขณะที่ระบบ AI สามารถตีความทั้งภาพและความหมายโดยอัตโนมัติ เหมือนที่มนุษย์ทำ

| แง่มุม | การดึงข้อมูลเว็บไซต์แบบดั้งเดิม | AI Web Scraping |

|---|---|---|

| วิธีการหลัก | อาศัยกฎแบบคงที่, XPath และ CSS selector | ใช้ ML & NLP agent เพื่อความเข้าใจเชิงบริบท |

| ความสามารถในการปรับตัว | ล้มเหลวง่ายเมื่อเว็บไซต์มีการเปลี่ยนแปลง | ปรับตัวอัตโนมัติตามการเปลี่ยนแปลงของเลย์เอาต์และเนื้อหา |

| การจัดการเนื้อหาแบบไดนามิก | มีปัญหากับเว็บไซต์ที่ใช้ JavaScript หนักหากไม่มี browser | ยอดเยี่ยมในการตีความเนื้อหาที่โหลดแบบไดนามิก |

| ภาระงานบำรุงรักษา | สูง | ต่ำ |

| ความเข้าใจข้อมูล | ดึงข้อมูลตามตำแหน่งในโค้ด | ดึงข้อมูลตามความหมายและบริบท |

| ความสามารถในการขยายระบบ | ขยายระบบได้ยาก | ขยายระบบได้ง่าย |

ข้อดีสำคัญของ AI Agent สำหรับการดึงข้อมูลจากเว็บไซต์

ตลาดการดึงข้อมูลเว็บไซต์ด้วย AI ที่เติบโตอย่างรวดเร็วเป็นข้อพิสูจน์ว่าคอนเซปต์ใหม่นี้ช่วยให้การดึงข้อมูลง่ายและรวดเร็วยิ่งขึ้น มาดูข้อได้เปรียบเชิงปฏิบัติของการใช้ AI ในการดึงข้อมูลเว็บไซต์กัน:

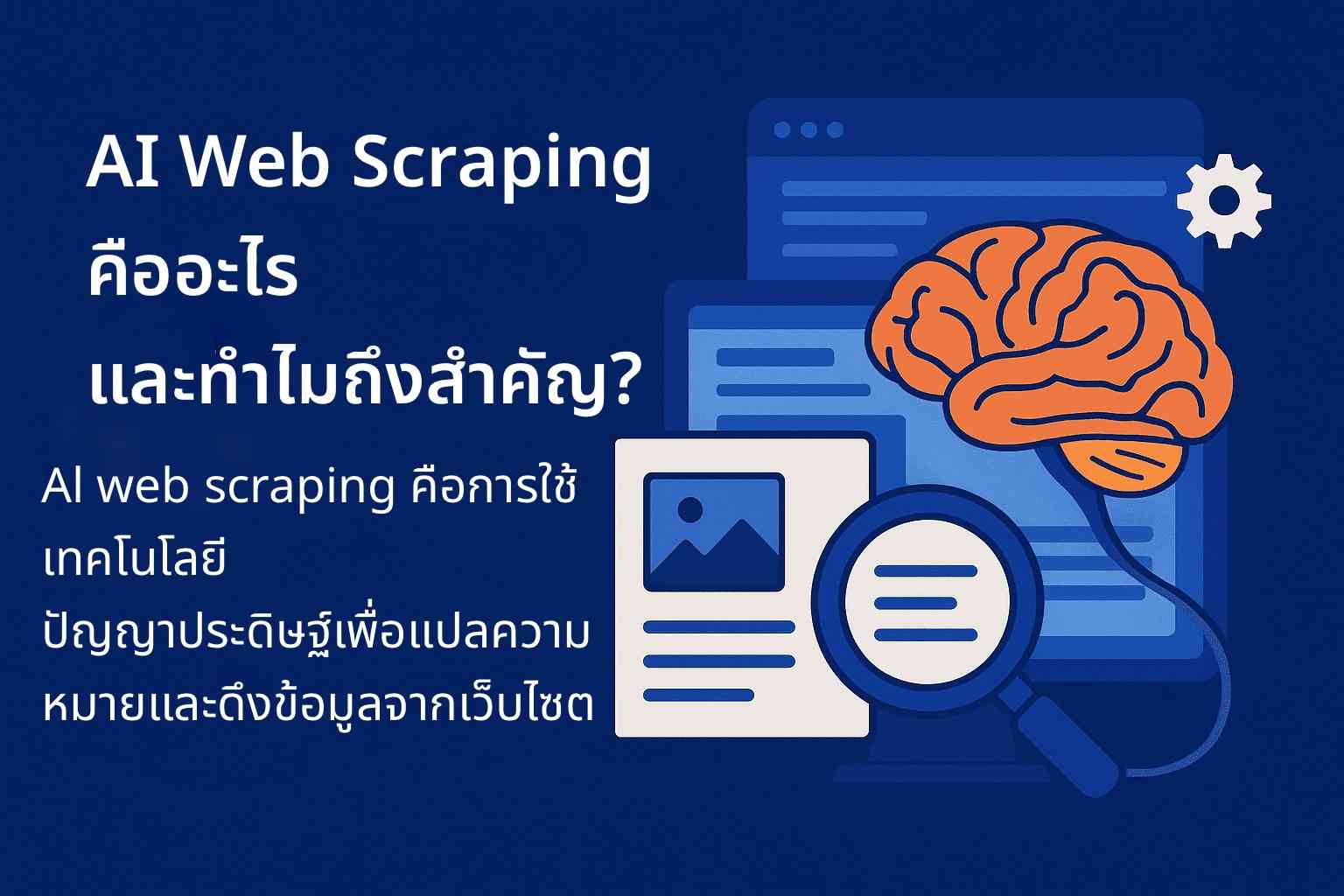

- การแยกข้อมูลแบบปรับตัวอัตโนมัติ: AI Agent สำหรับดึงข้อมูลเว็บไซต์สามารถปรับตัวเข้ากับโครงสร้างเว็บไซต์ที่เปลี่ยนแปลงได้โดยอัตโนมัติ ไม่ต้องตั้งค่าด้วยตนเองซ้ำ ๆ ความสามารถในการปรับตัวอย่างชาญฉลาดนี้ช่วยให้ดึงข้อมูลได้แม่นยำไม่ว่าจะเป็นรูปแบบหรือเลย์เอาต์หน้าเว็บแบบใด

- ข้ามการตรวจจับบอท: โซลูชัน AI สำหรับการดึงข้อมูลเว็บไซต์สมัยใหม่มีเทคนิคขั้นสูงเพื่อหลีกเลี่ยงการถูกตรวจจับและบล็อก โดยจะจำลองพฤติกรรมการท่องเว็บของมนุษย์ผ่าน machine learning ทำให้สามารถข้ามระบบป้องกันบอทที่ซับซ้อนได้

- การดึงข้อมูลอย่างชาญฉลาด: AI Agent สำหรับดึงข้อมูลเว็บไซต์ทำได้มากกว่าการแยกโค้ด HTML ทั่วไป สามารถเข้าใจบริบทของหน้าและดึงข้อมูลเชิงลึกที่มีความหมาย เช่น ชื่อสินค้า ราคา รีวิว ฯลฯ ได้อย่างแม่นยำสูง

สรุปแล้ว AI Agent สำหรับการดึงข้อมูลเว็บไซต์กำลังกลายเป็นเครื่องมือยอดนิยมของธุรกิจการเงิน อีคอมเมิร์ซ วิจัยตลาด และองค์กรอื่น ๆ เพื่อการวิเคราะห์ข้อมูลเรียลไทม์ วิเคราะห์เทรนด์ เฝ้าระวังคู่แข่ง และรายงานอัตโนมัติ

ตัวอย่างการใช้งานจริงในธุรกิจ B2B และผลกระทบต่อ ROI

ปัจจุบันมีองค์กรนับร้อยที่ใช้ AI Agent สำหรับการดึงข้อมูลเว็บไซต์เพื่อให้ได้ข้อมูลรวดเร็วโดยใช้แรงงานน้อย มาดู 3 กรณีศึกษาการใช้งานจริงในธุรกิจ B2B พร้อมผลลัพธ์ด้าน ROI:

กรณีศึกษา 1: การให้คะแนนกลุ่มเป้าหมาย B2B

ผู้ให้บริการซอฟต์แวร์องค์กรรายหนึ่งใช้ AI Agent เฝ้าติดตามเว็บไซต์บริษัทเป้าหมาย 5,000 แห่งเพื่อจับสัญญาณการซื้อ หลังจาก 9 เดือน อัตราการเปลี่ยนลูกค้าเพิ่มจาก 8% เป็น 12.4% (เพิ่มขึ้นประมาณ 55%) ขณะที่ต้นทุนการติดตั้งราว 85,000 ดอลลาร์สหรัฐ กลับสร้างประโยชน์กว่า 2.4 ล้านดอลลาร์สหรัฐ

กรณีศึกษา 2: ROI 312% สำหรับแพลตฟอร์มอีคอมเมิร์ซใน 1 ปี

แพลตฟอร์มอีคอมเมิร์ซระดับโลกแทนที่ทีมดึงข้อมูล 15 คนด้วยระบบ AI Agent ในปีแรกต้นทุนลดจาก 4.1 ล้านดอลลาร์สหรัฐ เหลือ 270,000 ดอลลาร์สหรัฐ และได้ ROI สูงถึง 312% จากการนำคู่แข่งขึ้นระบบได้เร็วขึ้นและความแม่นยำของข้อมูลเพิ่มจาก 71% เป็น 96%

กรณีศึกษา 3: การพยากรณ์ความต้องการในอีคอมเมิร์ซ

ผู้ค้าปลีกออนไลน์หลายหมวดหมู่ใช้ AI Agent ดึงข้อมูลราคา สต็อก โปรโมชั่น และรีวิวคู่แข่งทุกวัน ช่วยเพิ่มความแม่นยำในการพยากรณ์ความต้องการ 23% (MAPE ลดจาก 65% เหลือ 50%) ลดสินค้าขาดสต็อกลง 35% ประหยัดได้ราว 1.1 ล้านดอลลาร์สหรัฐต่อปี และปลดล็อกเงินทุนหมุนเวียนอีก 900,000 ดอลลาร์สหรัฐ

5 อันดับเครื่องมือ AI สำหรับการดึงข้อมูลเว็บไซต์ ปี 2026

ตลาดเครื่องมือ AI สำหรับการดึงข้อมูลเว็บไซต์กำลังเติบโตอย่างรวดเร็ว มีเครื่องมือให้เลือกหลากหลาย ช่วยให้ธุรกิจดึงข้อมูลอัตโนมัติได้อย่างมีประสิทธิภาพ อย่างไรก็ตาม ยังไม่มีเครื่องมือใดที่เหมาะกับทุกกรณี การเลือกใช้งานขึ้นอยู่กับงบประมาณและความต้องการของแต่ละธุรกิจ

มาดูกันว่าเครื่องมือ AI สำหรับการดึงข้อมูลเว็บไซต์ที่ดีที่สุดในปี 2026 มีอะไรบ้าง พร้อมทั้งเคล็ดลับการใช้งาน AI ดึงข้อมูลเว็บด้วย Python

เครื่องมือ AI สำหรับการดึงข้อมูลเว็บไซต์ที่ดีที่สุดในปี 2026 มีอะไรบ้าง?

| เครื่องมือ | ประเภท | ฟีเจอร์เด่น | กรณีการใช้งาน | ราคา |

|---|---|---|---|---|

|

GPTBots |

แพลตฟอร์ม AI Agent สำหรับองค์กร/ไม่ต้องเขียนโค้ด |

|

|

ราคาตามการใช้งาน (ติดต่อฝ่ายขาย) / ทดลองใช้งานฟรี |

|

Apify |

แพลตฟอร์ม AI ดึงข้อมูลเว็บไซต์บนคลาวด์ |

|

|

ฟรี / Starter $39 / Scale $199 / Business $999 ต่อเดือน |

|

Scrapy |

เฟรมเวิร์ก Python แบบโอเพ่นซอร์ส |

|

|

ฟรี (โอเพ่นซอร์ส) |

|

Octoparse |

โซลูชัน AI ดึงข้อมูลเว็บไซต์แบบไม่ต้องเขียนโค้ด |

|

|

ฟรี (10 งาน) / Standard $83 / Professional $299 / Enterprise แบบกำหนดเอง |

Bright Data

แพลตฟอร์มเก็บข้อมูลและพร็อกซีสำหรับองค์กร

-

เครือข่ายพร็อกซีครอบคลุมทั่วโลก + API สำหรับดึงข้อมูล (มากกว่า 195 ประเทศ)

-

ระบบป้องกันการบล็อกและหมุนเวียน IP อัตโนมัติ

-

ชุดข้อมูลพร้อมใช้สำหรับฝึก AI

-

โครงสร้างพื้นฐานแบบโฮสต์ที่ปรับขยายได้

-

องค์กรที่ต้องการดึงข้อมูลขนาดใหญ่ ถูกต้องตามกฎหมาย และครอบคลุมทั่วโลก

-

ทีม AI/ML ที่ต้องการฝึกโมเดลด้วยข้อมูลเว็บไซต์แบบเรียลไทม์หรือย้อนหลัง

จ่ายตามการใช้งาน $1.50/1,000 ผลลัพธ์ / รายเดือนแบบสมาชิก เริ่ม ~$499+

GPTBots

GPTBots คือแพลตฟอร์ม AI สำหรับสร้างและใช้งาน AI Agent เพื่อดึงข้อมูลเว็บไซต์ระดับองค์กรได้ในไม่กี่นาที มาพร้อมเครื่องมือสร้าง Agent แบบไม่ต้องเขียนโค้ด (no-code visual builder) ให้คุณออกแบบ Agent สำหรับงานดึงข้อมูลเฉพาะทางได้เอง และยังเลือก LLM (Large Language Model) ที่ต้องการใช้ในกระบวนการดึงข้อมูลได้อีกด้วย

จุดเด่น

- เครื่องมือสร้าง AI Agent ดึงข้อมูลเว็บไซต์แบบไม่ต้องเขียนโค้ด (visual, no-code builder) ปรับแต่งได้ตามต้องการ

- เลือกใช้ LLM ได้หลากหลาย (เช่น GPT-4, Claude, Gemini ฯลฯ) เพื่อช่วยตีความข้อมูลและแยกข้อมูลแบบอัตโนมัติ

- แปลงข้อมูลดิบจากเว็บไซต์เป็นข้อมูลที่มีโครงสร้างและติดป้ายกำกับ เช่น JSON, CSV หรือชุดข้อมูลพร้อมใช้งานกับ API

- สร้างกระบวนการดึงข้อมูลแบบ end-to-end ที่สามารถดึงและส่งข้อมูลไปยัง dashboard วิเคราะห์หรือฐานข้อมูลได้โดยอัตโนมัติ

- ระบบควบคุมความถี่อัจฉริยะ เดินเว็บเหมือนมนุษย์ และจัดการ CAPTCHA เพื่อลดปัญหาโดนบล็อกขณะดึงข้อมูล

- รองรับการติดตั้งใช้งานแบบ private เพื่อความปลอดภัยและเป็นไปตามข้อกำหนดสูงสุด

- เชื่อมต่อ API/webhook สำหรับงานอัตโนมัติและใช้งานในองค์กร (input → agent → structured JSON output)

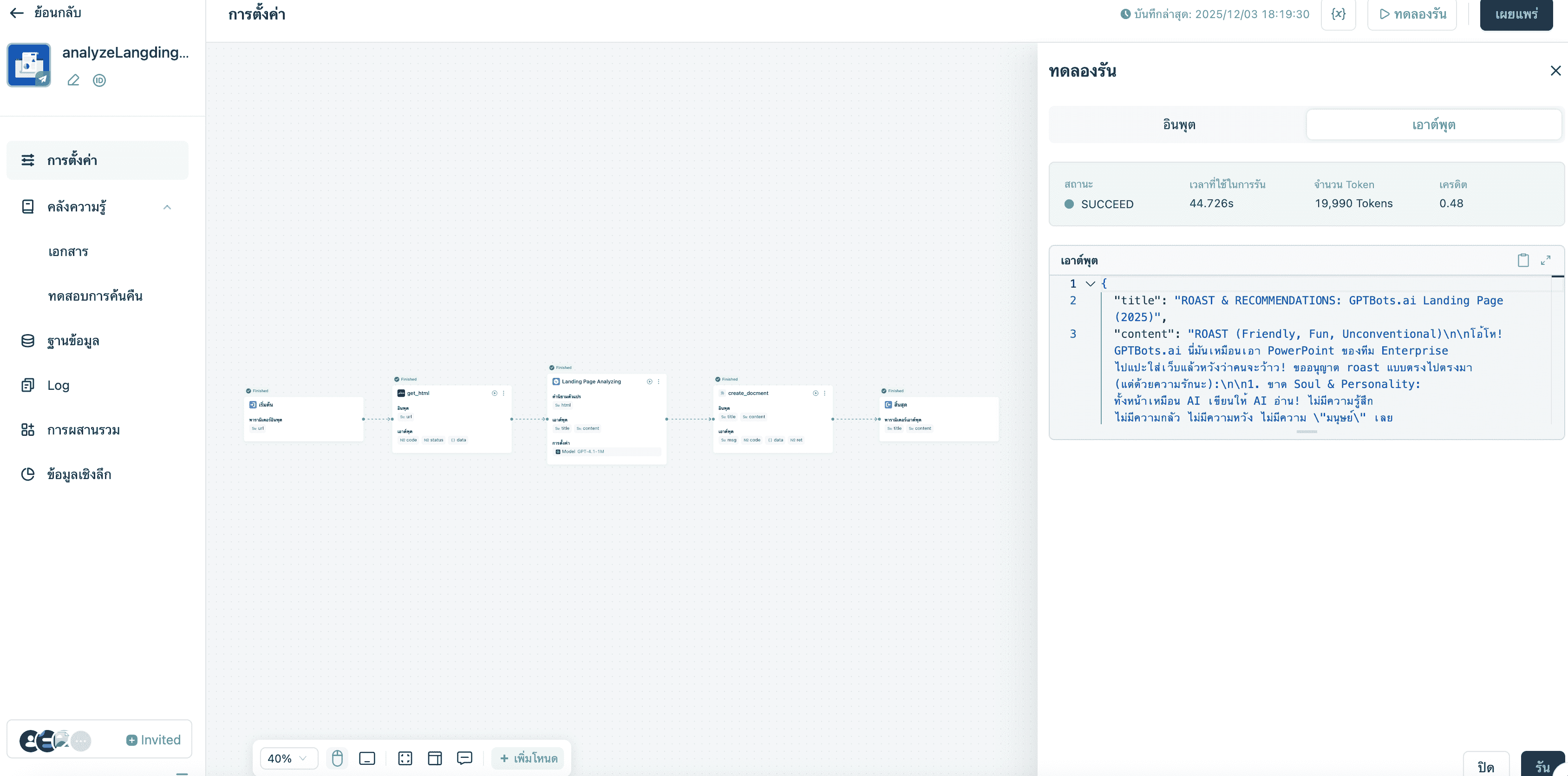

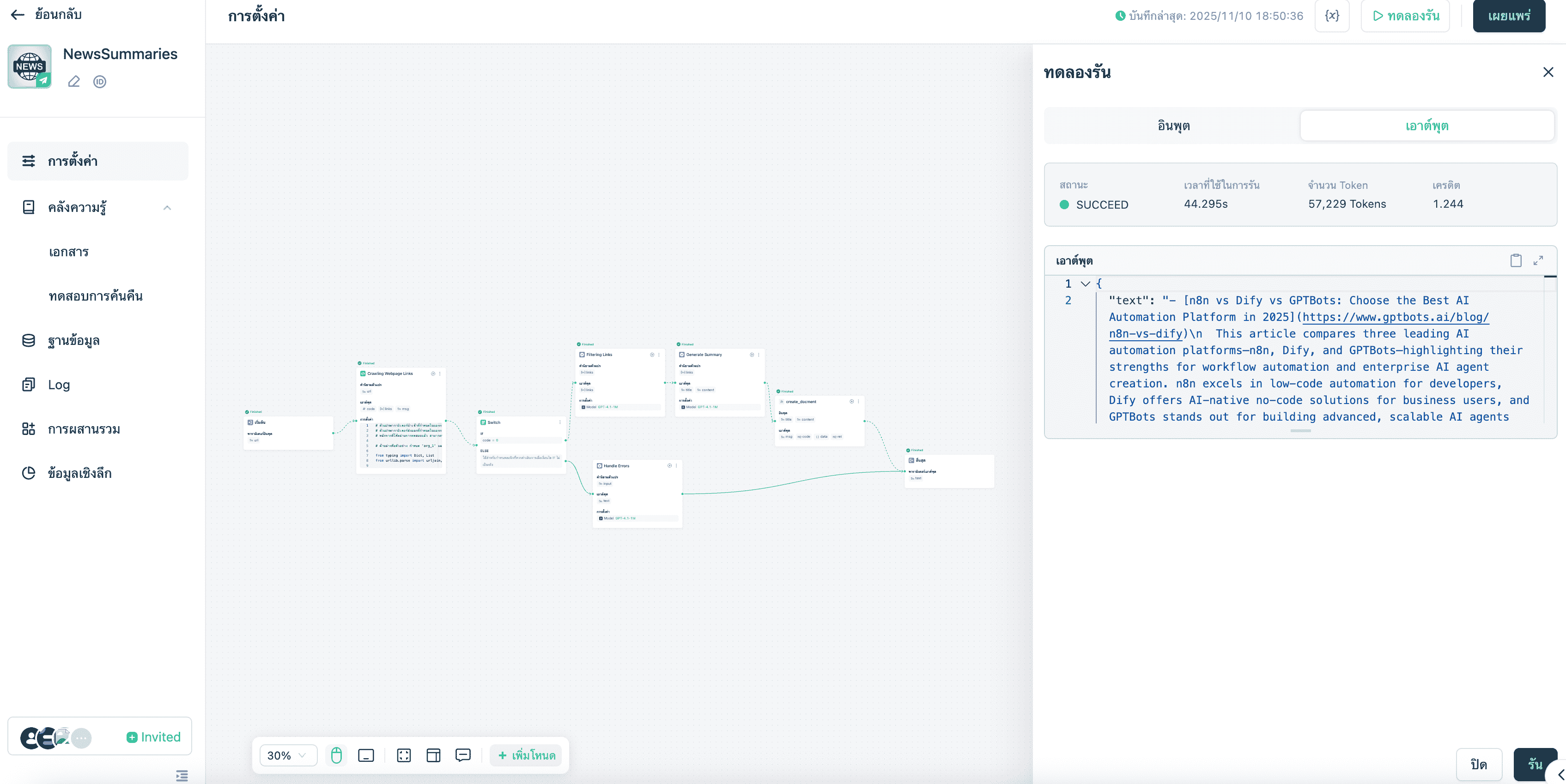

ตัวอย่างการใช้งาน

- ดึงข้อมูลเว็บไซต์และสรุปเนื้อหาด้วย AI อัตโนมัติ

- ตรวจสอบความน่าเชื่อถือของเว็บไซต์ วิเคราะห์ว่าเป็นเว็บจริงหรือเว็บหลอกลวง

- สร้างสรุปข่าวอัตโนมัติ เพียงใส่ URL ของข่าวที่ต้องการ

- ดึงข้อมูลรายละเอียดบริษัทจาก URL

- วิเคราะห์หน้า landing page ด้วย GPT และรับคำแนะนำในการปรับปรุง

ราคา

GPTBots มีรูปแบบราคาแบบปรับแต่งตามความต้องการของแต่ละองค์กร สามารถติดต่อฝ่ายขายเพื่อขอเดโมหรือทดลองใช้งานฟรีได้

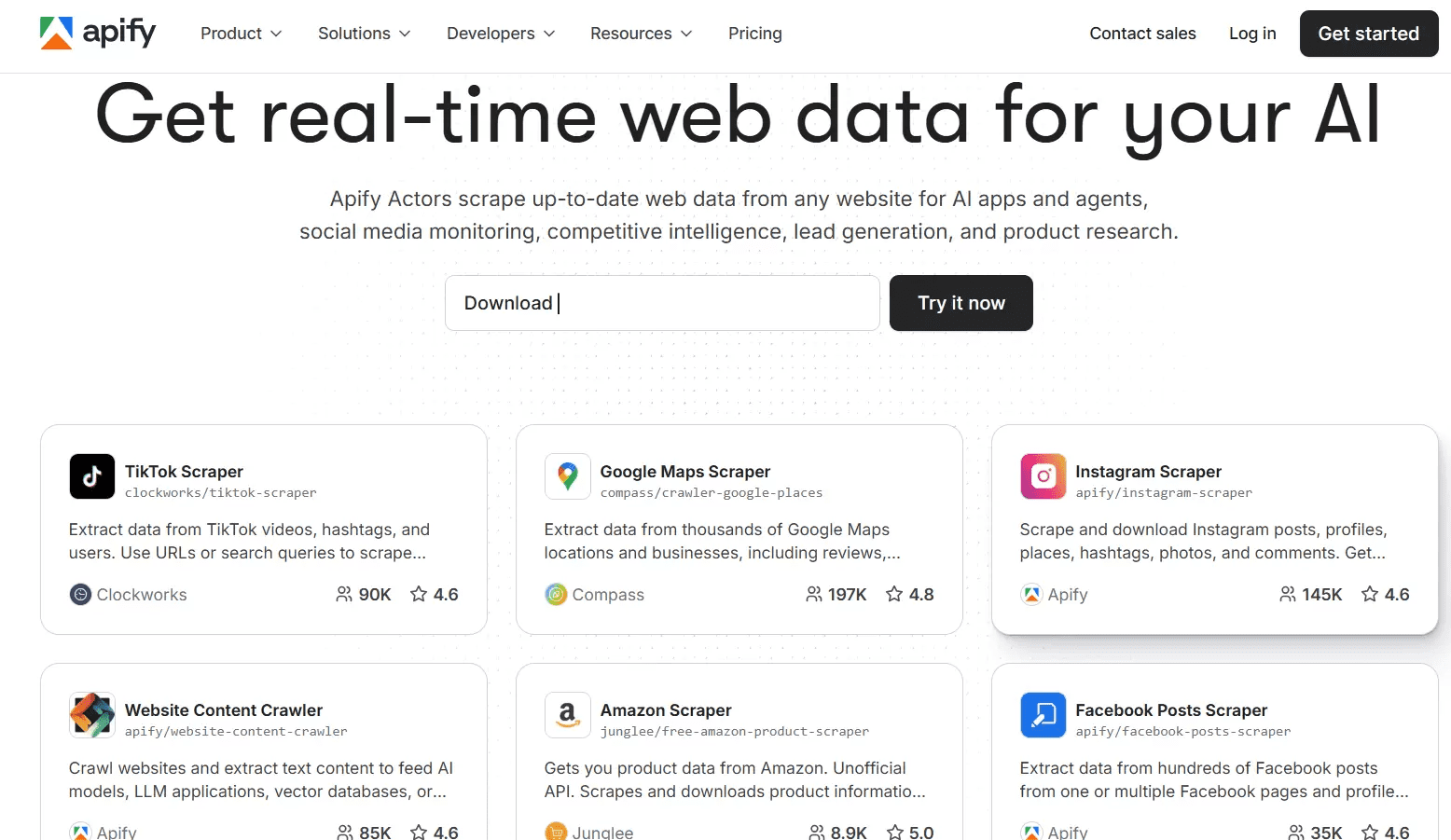

ขอเดโมสำหรับองค์กรApify

Apify เป็น AI Agent สำหรับดึงข้อมูลเว็บไซต์ (เรียกว่า Actors) ที่สามารถดึงข้อมูลแบบเรียลไทม์จากเว็บไซต์ แอป และอื่น ๆ มี Actors ให้เลือกใช้งานมากกว่า 6,000 ตัว สำหรับดึงข้อมูลจากเว็บไซต์ยอดนิยม เช่น TikTok, Instagram, Google Maps, โพสต์ Facebook และอีกมากมาย รวมถึงสามารถสร้าง Actors ใหม่ด้วยเทมเพลตโค้ดและคู่มือแนะนำ

จุดเด่น

- Actors สำเร็จรูปกว่า 6,000 ตัว สำหรับเว็บไซต์ยอดนิยม

- พัฒนา Actors ใหม่ได้ง่ายตามความต้องการ

- เชื่อมต่อกับแอปและแพลตฟอร์มอื่น ๆ ได้อย่างราบรื่น

- สั่งงานด้วยภาษาธรรมชาติให้ดึงข้อมูลและท่องเว็บได้

ตัวอย่างการใช้งาน

- ตั้งเวลาดึงข้อมูลสินค้าและวิเคราะห์รีวิวจาก e-commerce กว่า 100 เว็บไซต์ ด้วย Actors สำเร็จรูป

- ใช้ AI automation เพื่อดึงข้อมูลจากหน้าเว็บที่ต้องล็อกอิน กรอกฟอร์ม และดึงคอนเทนต์ไดนามิกโดยไม่ต้องเขียน selector เอง

- อัตโนมัติกระบวนการหาลีด เช่น ตรวจสอบฟอรั่ม/บอร์ดงาน ดึงโปรไฟล์บริษัท และส่งข้อมูลเข้า CRM

ราคา

- ฟรี: $0/เดือน + คิดค่าบริการตามการใช้งาน ($0.3 ต่อ compute unit)

- เริ่มต้น: $39/เดือน + คิดค่าบริการตามการใช้งาน ($0.3 ต่อ compute unit)

- ขยายขนาด: $199/เดือน + คิดค่าบริการตามการใช้งาน ($0.25 ต่อ compute unit)

- ธุรกิจ: $999/เดือน + คิดค่าบริการตามการใช้งาน ($0.2 ต่อ compute unit)

Scrapy

Scrapy คือเฟรมเวิร์กโอเพ่นซอร์สสำหรับ Python ที่ใช้ในการรวบรวมและดึงข้อมูลจากเว็บไซต์ เหมาะสำหรับการสร้าง spider ที่ปรับแต่งและขยายขนาดได้ เพื่อดึงข้อมูลสาธารณะจากเว็บ ปัจจุบัน Scrapy สามารถเชื่อมต่อกับ LLM เพื่อให้ทำงานเป็น AI web scraping agent ที่ดึงข้อมูลจากเว็บตามรูปแบบที่คุณกำหนดไว้ใน language model ที่ต้องการ

จุดเด่น

- ฟรี, โอเพ่นซอร์ส และพัฒนาโดยใช้ Python โดยตรง

- สร้างและขยาย spider สำหรับงานดึงข้อมูลเว็บทุกรูปแบบ

- รองรับการประมวลผลแบบอะซิงโครนัส มีโครงสร้างการรวบรวมข้อมูลในตัว รองรับ selector และส่งออกข้อมูลเป็น JSON/CSV

- รองรับ middleware เช่น การเชื่อมต่อ proxy, การเรนเดอร์ JavaScript (ผ่าน Splash หรือ Playwright) และการผสานกับโมดูล AI ระดับสูง

กรณีการใช้งาน

- ทีมพัฒนาที่ต้องการสร้างระบบดึงข้อมูลขนาดใหญ่ (มากกว่า 100,000 หน้า) พร้อมตรรกะและกระบวนการข้อมูลที่ปรับแต่งเอง

- สร้าง pipeline เฉพาะทางสำหรับอุตสาหกรรม เช่น การติดตามไดเรกทอรี B2B, กระดานงาน หรือเอกสารกำกับดูแล

ราคา

- ใช้ฟรี (โอเพ่นซอร์ส)

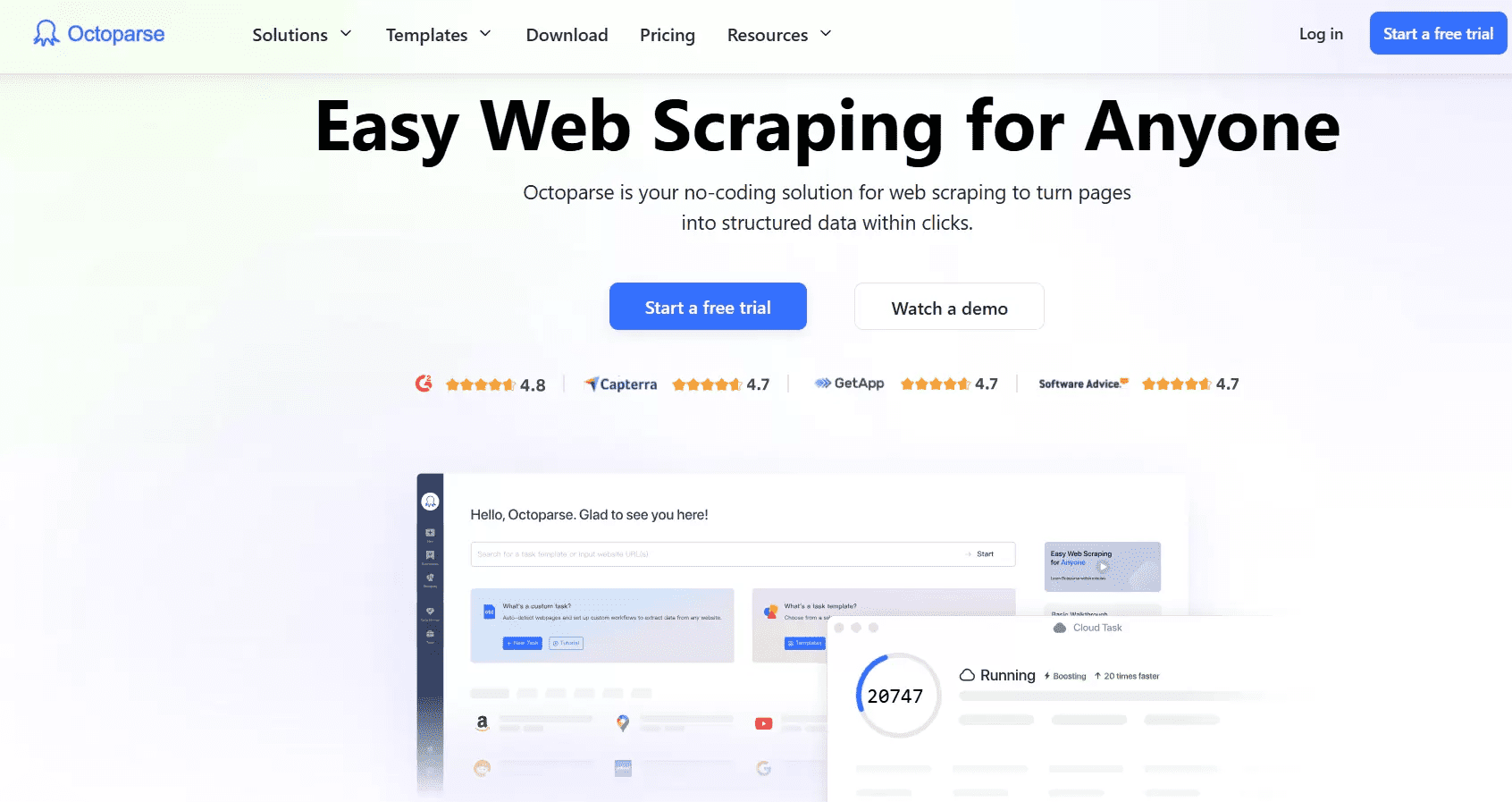

Octoparse

Octoparse คือโซลูชัน web scraping แบบไม่ต้องเขียนโค้ดและใช้ AI ช่วยดึงข้อมูลเชิงโครงสร้างจากหน้าเว็บด้วยการคลิกง่าย ๆ มี workflow designer ที่ช่วยให้การสร้าง web scraper แบบกำหนดเองทำได้ง่ายและรวดเร็ว พร้อมทั้งสามารถตั้งเวลาการดึงข้อมูลล่วงหน้าได้

จุดเด่น

- ออกแบบ workflow ได้โดยไม่ต้องเขียนโค้ด

- รับมือกับความท้าทายของ web scraping เช่น หมุน IP, แก้ CAPTCHA, เลื่อนหน้าแบบไม่สิ้นสุด, proxy ฯลฯ

- มีเทมเพลตสำเร็จรูปสำหรับเว็บไซต์ยอดนิยม

- AI ช่วยตรวจจับฟิลด์และแนะนำ workflow อัตโนมัติ

กรณีการใช้งาน

- ทีมการตลาดหรือฝ่ายปฏิบัติการที่ต้องการตั้งค่าการเก็บข้อมูลอย่างรวดเร็วโดยไม่ต้องพึ่งวิศวกร

- ดึงราคาสินค้าคู่แข่งรายวันด้วยเทมเพลต + ตั้งเวลางาน

- อัปเดตข้อมูลอัตโนมัติ เช่น ตรวจสอบการเปลี่ยนแปลงเว็บไซต์ อัปเดต dashboard และส่งออกข้อมูลไปยัง Excel/Google Sheets/ฐานข้อมูล ด้วยการเขียนโค้ดน้อยที่สุด

ราคา

- ฟรี: $0 (10 งาน)

- แพ็กเกจมาตรฐาน: $83/เดือน (100 งาน)

- แพ็กเกจมืออาชีพ: $299/เดือน (250 งาน)

- แพ็กเกจองค์กร: กำหนดเอง (750+ งาน)

Bright Data

ตัวสุดท้ายในรายชื่อเครื่องมือ AI web scraping ที่ดีที่สุดปี 2026 คือ Bright Data แพลตฟอร์มดึงข้อมูลขนาดใหญ่ที่ให้บริการโครงสร้างพื้นฐานสำหรับการรวบรวมข้อมูล, เครือข่าย proxy และ API สำหรับ scraping โดยเฉพาะ จุดเด่นของ AI ที่นี่คือความสามารถในการป้อนข้อมูลเว็บเข้าสู่ pipeline การฝึก AI และรองรับการดึงข้อมูลปริมาณมากจากทั่วโลกแบบอัตโนมัติ

จุดเด่น

- เครือข่ายพร็อกซี่ขนาดใหญ่ + Web Scraper API + SERP API ครอบคลุมกว่า 195 ประเทศ พร้อมระบบระบุตำแหน่งทางภูมิศาสตร์เต็มรูปแบบ

- ระบบป้องกันการบล็อกในตัว หมุน IP อัตโนมัติ รองรับการเรนเดอร์ JavaScript และรองรับงานดึงข้อมูลขนาดใหญ่ระดับองค์กรที่ซับซ้อน

- โครงสร้างพื้นฐานคลาวด์แบบโฮสต์เต็มรูปแบบที่ขยายอัตโนมัติ รองรับการเปิดใช้งานพร้อมกันไม่จำกัดจำนวนเซสชัน

กรณีการใช้งาน

- บริษัทขนาดใหญ่ที่ต้องการวิจัยตลาดระดับโลก เช่น การดึงและติดตามข้อมูลจากเว็บไซต์นับพันแห่งทั่วโลก พร้อมการปฏิบัติตามข้อกำหนดและครอบคลุมพร็อกซี่

- นำข้อมูลที่ดึงจากเว็บไปป้อนเข้าสู่กระบวนการ AI/ML เพื่อฝึกโมเดล เช่น แค็ตตาล็อกสินค้า รีวิวผู้บริโภค และข้อมูลข่าวสาร

- การติดตามราคาหรือ SERP ปริมาณสูง ที่ต้องการความสามารถในการขยายตัว ความน่าเชื่อถือ และครอบคลุมทั่วโลก

ราคา

- จ่ายตามการใช้งาน: $1.50 ต่อ 1,000 ผลลัพธ์

- แพ็กเกจรายเดือนเริ่มต้นที่ประมาณ $499/เดือน สำหรับ Web Scraper IDE หรือโมดูลอื่น ๆ

วิธีใช้งาน AI Web Scraping ด้วย Python

Python ยังคงเป็นเครื่องมือหลักสำหรับการดึงข้อมูล คุณสามารถใช้ไลบรารีมาตรฐานและผสมผสาน AI web scraping กับ Python ได้ตามต้องการ

ไลบรารี Python ที่จำเป็นสำหรับ AI Web Scraping Python

- Requests + BeautifulSoup / lxml — สแต็กน้ำหนักเบาสำหรับหน้าเว็บแบบสแตติกและการแปลง HTML อย่างรวดเร็ว เหมาะสำหรับงานดึงข้อมูลที่เรียบง่ายและเชื่อถือได้

- Scrapy — เฟรมเวิร์กการรวบรวมข้อมูลที่ขยายขนาดได้และผ่านการทดสอบจริงสำหรับงานขนาดใหญ่ พร้อม middleware hook สำหรับเพิ่มตรรกะ AI/LLM

- Playwright / Selenium — ขับเคลื่อนเบราว์เซอร์แบบ headless สำหรับเว็บไซต์ที่ใช้ JavaScript หนักและโฟลว์แบบอินเทอร์แอกทีฟ (เช่น ล็อกอิน, เลื่อนแบบไม่มีที่สิ้นสุด) Playwright ได้รับความนิยมมากกว่าในด้านความน่าเชื่อถือและการรองรับการทำงานพร้อมกัน

- LLM integration layers — เครื่องมือจากชุมชน เช่น scrapy-llm หรือการเรียก LLM แบบ custom ช่วยเปลี่ยน HTML ที่ไม่มีโครงสร้างให้เป็นข้อมูลที่มีโครงสร้างด้วย prompt

- เครื่องมือ Data & ML — pandas สำหรับการแปลงข้อมูล, GPTBots, Hugging Face หรือ OpenAI สำหรับการสกัด/ปรับข้อมูล entity และ vector store (เช่น สำหรับค้นหา) เมื่อรวมเนื้อหาที่ดึงมาจากเว็บกับฟีเจอร์ฐานความรู้

ตัวอย่างโค้ดการใช้งานเบื้องต้น

1. หน้า Static — Requests + BeautifulSoup

import requests

from bs4 import BeautifulSoup

url = "https://example.com/products"

res = requests.get(url, timeout=10)

res.raise_for_status()

soup = BeautifulSoup(res.text, "html.parser")

# Parsing product info with BeautifulSoup

products = []

for card in soup.select(".product-card"):

products.append({

"title": card.select_one(".title").get_text(strip=True),

"price": card.select_one(".price").get_text(strip=True)

})

print(products)

ใช้สำหรับหน้าเว็บที่ HTML มีเนื้อหาครบถ้วน สามารถเพิ่ม header, session และดีเลย์สุ่มสั้น ๆ เพื่อความสุภาพ

2. เนื้อหาแบบไดนามิก — Playwright (Python)

from playwright.sync_api

import sync_playwright

# Parsing product info with Playwright

with sync_playwright() as p:

browser = p.chromium.launch(headless=True)

page = browser.new_page()

page.goto("https://example.com/products")

page.wait_for_selector(".product-card")

cards = page.query_selector_all(".product-card")

data = [{

"title": c.query_selector(".title").inner_text().strip(),

"price": c.query_selector(".price").inner_text() .strip()

} for c in cards ]

browser.close()

print(data)

Playwright โหลดเนื้อหาที่ขับเคลื่อนด้วย JS ได้อย่างน่าเชื่อถือ และรองรับ context ของเบราว์เซอร์และการตั้งค่าพร็อกซี่

3. Scrapy + LLM post-processing (รูปแบบ)

Scrapy รวบรวมข้อมูลขนาดใหญ่และส่งข้อความแต่ละหน้าที่ดึงมาไปยัง LLM เพื่อสกัดข้อมูลแบบมีโครงสร้าง:

# inside your Scrapy pipeline(pseudocode)

def process_item( self, item, spider):

text = item['raw_html_text']

# call LLM(OpenAI) with prompt: "Extract name, price, sku from text"

parsed = call_llm_extract(text)

item.update(parsed)

return item

โครงการจากชุมชนอย่าง scrapy-llm แสดงให้เห็นการเชื่อมต่อ LLM เข้ากับ pipeline ของ Scrapy เพื่อดึงข้อมูลตาม schema

4. การเชื่อมต่อกับ OpenAI และบริการ AI อื่น ๆ

เมื่อไหร่ควรเรียกใช้ LLM: ใช้ LLM กับงานที่เกี่ยวข้องกับความหมาย เช่น การดึงข้อมูลเอนทิตี การลบข้อมูลซ้ำ การปรับข้อมูลให้เป็นมาตรฐาน (เช่น แปลง "$9.99" → ตัวเลข), การจัดประเภท หรือการอนุมานข้อมูลที่ขาดหายไปเมื่อ HTML มีความซับซ้อน ตัวอย่างการเรียกใช้ OpenAI:

import openai

openai.api_key = "YOUR_KEY"

# การแยกข้อมูลสินค้าโดยใช้ OpenAI

resp = openai.ChatCompletion.create(

model="gpt-4o",

messages=[{

"role":"user",

"content": "Extract product_name;price;sku from the text:\n\n" + scraped_text

}])

structured = parse_response(resp)

ควรตรวจสอบผลลัพธ์ของโมเดลและแปลงประเภทข้อมูลให้ถูกต้องก่อนบันทึกเสมอ

GPTBots API ช่วยเสริมประสิทธิภาพ Workflow การดึงข้อมูลด้วย Python ได้อย่างไร

GPTBots มี "Workflow API" ที่สามารถเรียกใช้จาก Python เพื่อรัน AI Agent ที่สร้างไว้ล่วงหน้า (เช่น extractCompanyProfileFromURL) ทำให้สคริปต์ Python ของคุณไม่ต้องเขียนตรรกะ LLM ซ้ำหรือจัดการกระบวนการดึงข้อมูลหลายขั้นตอนเอง

ขั้นตอนทั่วไปคือ: Python ดาวน์โหลดหน้าเว็บ (หรือส่ง URL) → เรียกใช้ workflow/invoke ของ GPTBots → GPTBots รัน agent (scrape/parse/structure) แล้วส่งคืนข้อมูลในรูปแบบ JSON

วิธีนี้ช่วยลดภาระงานในการจัดการ schema, การจัดการข้อมูลซ้ำ และการอัปเดต knowledge-base มาดูตัวอย่างกัน:

# การแยกข้อมูลสินค้าโดยใช้ GPTBots workflow API

curl - X POST "https://api-{endpoint}.gptbots.ai/v1/workflow/invoke"\

- H "Authorization: Bearer YOUR_KEY"\

- H "Content-Type: application/json"\

- d '{"workflow_id":"extractCompanyProfileFromURL","input":{"url":"https://target.com"}}'

จากนั้นให้ดึงข้อมูล JSON ที่จัดโครงสร้างแล้วโดย polling ที่ "query_workflow_result"

เทคนิคการจัดการข้อผิดพลาดและเพิ่มประสิทธิภาพที่ดีที่สุด

- การลองใหม่ & Backoff: ใช้ exponential backoff พร้อมจำกัดจำนวนครั้งสำหรับข้อผิดพลาด HTTP ชั่วคราว ใช้ไลบรารีหรือ adapter เช่น requests.adapters.HTTPAdapter

- ตั้งค่า Timeout & ใช้ Session: กำหนด timeout ที่เหมาะสมและใช้ requests.Session() หรือ context ของ browser ซ้ำเพื่อลด overhead ของ DNS และ TCP

- Proxy & หมุน IP: ใช้ proxy แบบ residential/cloud ที่หมุนเวียนได้เพื่อขยายขอบเขตประเทศและลดโอกาสโดนบล็อก ควรจับคู่กับการหมุน user-agent และเพิ่มดีเลย์แบบมนุษย์ ผู้ให้บริการมาตรฐานสำหรับองค์กร เช่น Bright Data และ Oxylabs

- การควบคุมอัตรา & ความสุภาพ: เคารพ rate limit, robots.txt (ถ้ามี) และเพิ่ม jitter ให้กับ request เพื่อลดโอกาสถูกตรวจจับ

- การมอนิเตอร์ & การสังเกตการณ์: ส่งออก metric (อัตราสำเร็จ, latency, ประเภท error) ใช้ dashboard และระบบแจ้งเตือนเพื่อตรวจจับปัญหาหลังเว็บไซต์เปลี่ยนแปลง

- การตรวจสอบ & ทำความสะอาด: ตรวจสอบ schema (ด้วย Pydantic หรือ validator ที่กำหนดเอง) บนผลลัพธ์ LLM เพื่อป้องกันข้อมูลเท็จและปรับประเภทข้อมูลก่อนจัดเก็บ

Bonus: วิเคราะห์ Landing Page ด้วย AI ผ่าน GPTBots

GPTBots เปิดโอกาสให้คุณสร้างและใช้งาน AI Agent สำหรับดึงข้อมูลเว็บที่ปรับแต่งได้อย่างเต็มที่ เหมาะกับงาน scraping หลากหลาย หนึ่งในตัวอย่างการใช้งานที่โดดเด่นคือ AI landing page analysis

ที่นี่ GPTBots agent จะดึงและวิเคราะห์องค์ประกอบบนหน้าเว็บโดยอัตโนมัติ เช่น ปุ่ม CTA, หัวข้อ, คีย์เวิร์ด และ metadata จากนั้นนำเสนอ:

- ข้อเสนอแนะเชิงลึกที่ชี้จุดอุปสรรคต่อการแปลงยอดขาย

- คำแนะนำการเพิ่มประสิทธิภาพ CRO ขั้นสูง

- คำแนะนำเฉพาะสำหรับความท้าทายของแต่ละหน้า

ต่อไปมาดูวิธีสร้างและใช้งาน AI agent สำหรับวิเคราะห์ landing page ด้วย GPTBots:

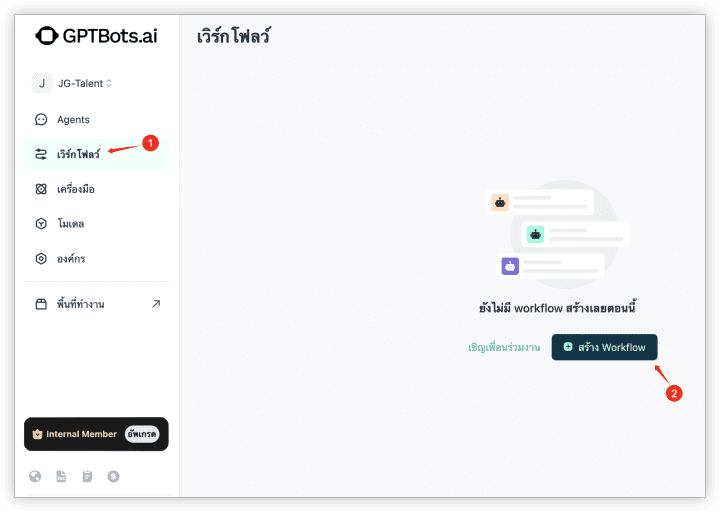

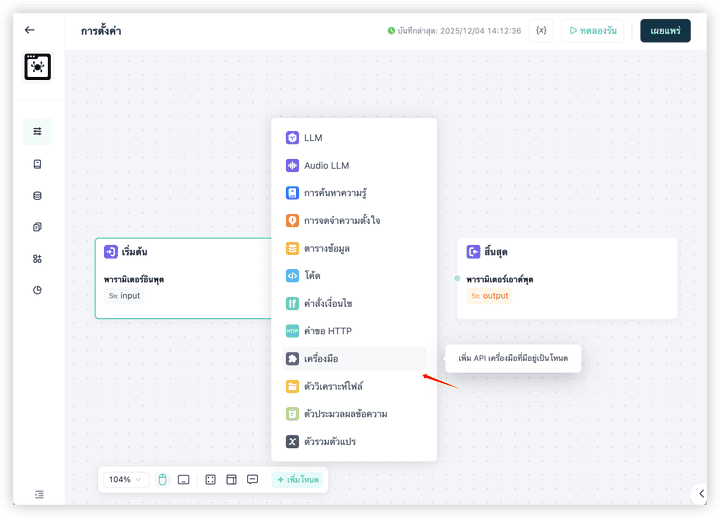

ขั้นตอนที่ 1. สร้าง workflow

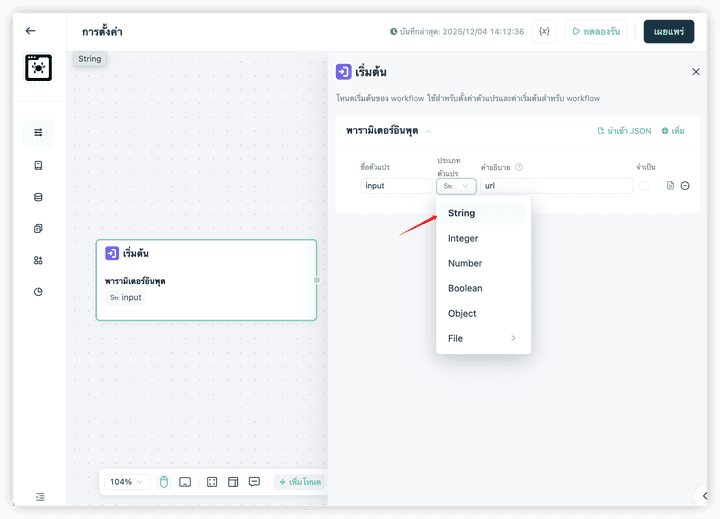

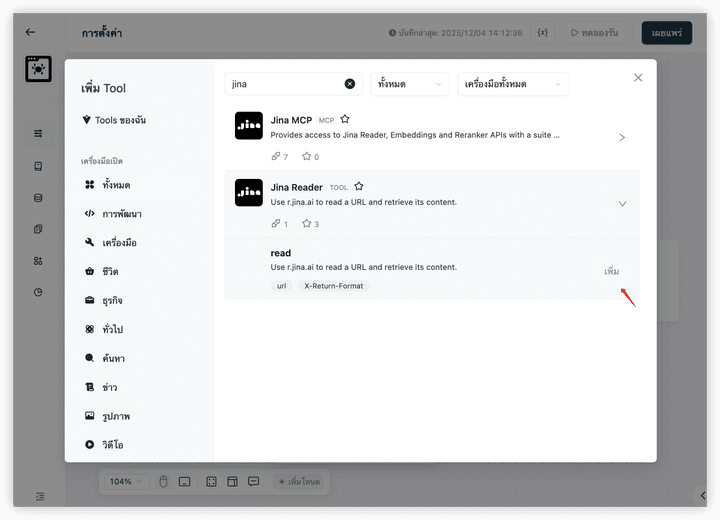

ขั้นตอนที่ 2. กำหนดองค์ประกอบ Start และ End โดยเริ่มจากตั้งค่า input สำหรับ Start ให้เป็นพารามิเตอร์ประเภท String ชื่อว่า URL

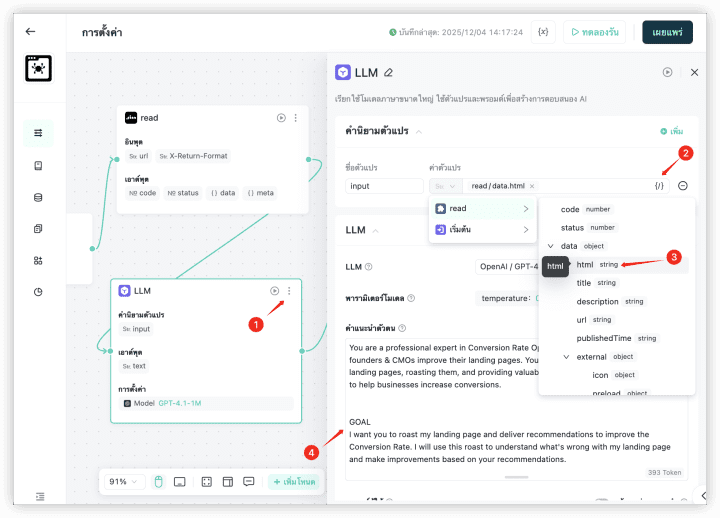

ขั้นตอนที่ 3. นำเข้า Jina HTML Reader จาก Tools โดยเครื่องมือนี้ใช้สำหรับแปลง URL และดึงซอร์สโค้ด HTML ของหน้าเว็บ ซึ่งขั้นตอนนี้ไม่ต้องเขียนโค้ดใด ๆ

เชื่อมต่อกับคอมโพเนนต์ Start และส่งพารามิเตอร์ URL จาก Start/input ไปยังคอมโพเนนต์ Jina Reader

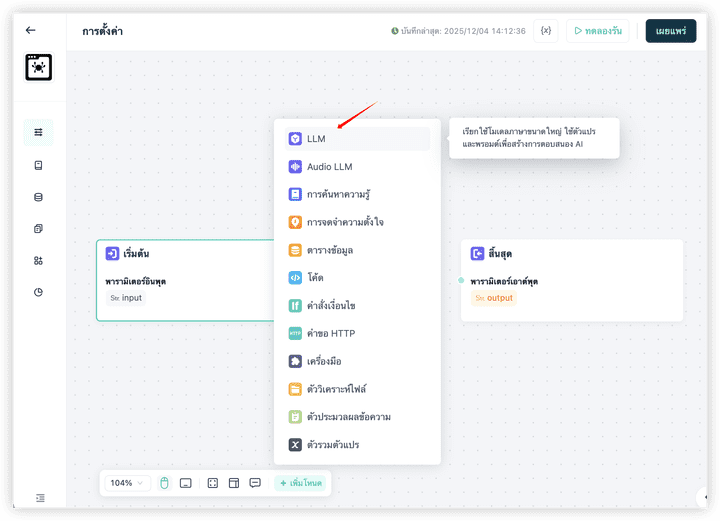

ขั้นตอนที่ 4. เพิ่มคอมโพเนนต์ LLM สำหรับการวิเคราะห์ด้วย AI

เชื่อมต่อ Jina Reader เข้ากับ LLM และส่งเนื้อหาของหน้าเว็บไปยัง LLM เพื่อวิเคราะห์ข้อมูล

ตั้งค่า prompt

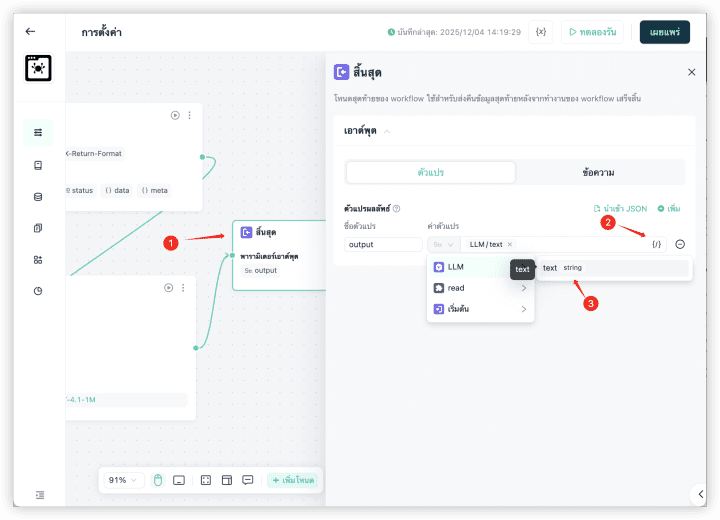

ขั้นตอนที่ 5. เชื่อมต่อคอมโพเนนต์ End และใช้ผลลัพธ์ที่ได้จาก LLM เป็นผลลัพธ์สุดท้าย

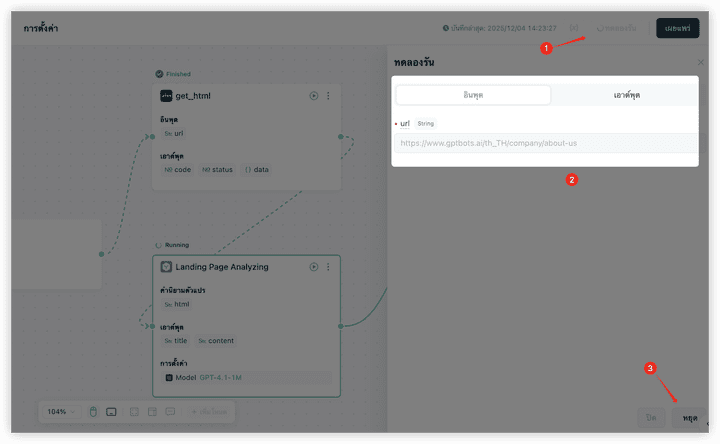

ขั้นตอนที่ 6. คลิก Test Run กรอก URL ที่ต้องการทดสอบ แล้วดำเนินการ

เพียงเท่านี้ คุณก็สามารถสร้าง AI web scraping agent ด้วย GPTBots ได้อย่างรวดเร็ว

สรุป

AI web scraping คือเกมเปลี่ยนธุรกิจสำหรับการดึงข้อมูลจากเว็บไซต์และนำไปใช้เชิงปฏิบัติในปี 2026 หมดยุคที่องค์กรต้องลำบากกับ scraper แบบเดิม ๆ โดยเฉพาะกับเว็บที่มีความซับซ้อนหรือใช้ JavaScript หนัก ๆ

เครื่องมือ AI web scraping อย่าง GPTBots, Apify, Octoparse และ Bright Data ช่วยให้องค์กร B2B สามารถเก็บข้อมูลขนาดใหญ่แบบอัตโนมัติและเข้าใจบริบทได้อย่างแม่นยำ แพลตฟอร์มเหล่านี้ผสาน machine learning, NLP และ adaptive parsing เพื่อให้ข้อมูลเชิงลึกที่มีโครงสร้างและเชื่อถือได้ โดยไม่ต้องดูแลระบบตลอดเวลา

ดังนั้น ถึงเวลาสร้าง AI Agent สำหรับดึงข้อมูลเว็บไซต์เพื่อขับเคลื่อนการตัดสินใจธุรกิจที่ดียิ่งขึ้น และไม่มีวิธีไหนจะเริ่มต้นได้ง่ายไปกว่าการใช้ visual builder แบบ no-code ของ GPTBots เพื่อสร้างและขยาย agent ดึงข้อมูลอัจฉริยะโดยไม่ต้องเขียนโค้ดแม้แต่บรรทัดเดียว

ขอรับเดโมสำหรับธุรกิจ