現在、B2Bの意思決定はデータへの依存度がますます高まっています。S&P Global Market Intelligence Studyの回答者の96%が、意思決定プロセスにおけるデータ活用の重要性を強調しています。しかし、従来のウェブスクレイピング手法は、WebスクレイピングAIエージェントなどの最新のウェブ技術に対応できなくなっています。

カスタムスクリプトや固定セレクターを用いた従来のウェブスクレイピング手法は、JavaScriptを多用した現代のウェブサイトや動的コンテンツには効果が薄れつつあります。実際、多くの従来のツールはウェブサイトのレイアウトが変わるたびに動作しなくなり、頻繁なメンテナンスが必要です。

一方、AIウェブスクレイピングツールは、コンピュータビジョン、自然言語処理、機械学習を活用し、ウェブコンテンツを理解して自動で抽出し、サイトの変化にも柔軟に適応します。そのため、AIウェブスクレイピング市場は2025年の8億8,603万ドルから、2035年には43億6,940万ドルまで、年平均成長率17.3%で拡大すると予測されています。

WebスクレイピングAIエージェントが主流となる中、本ガイドではAIウェブスクレイピングの仕組みを分かりやすく解説し、2026年に注目すべきおすすめツールも紹介します。それでは、さっそく見ていきましょう!

AIウェブスクレイピングとは?重要性を徹底解説

AIウェブスクレイピングとは、人工知能(AI)を活用し、ウェブサイトからデータを解釈して抽出する技術です。パターンベースの抽出から、内容を理解して抽出できるようになっています。

AIウェブスクレイピングは、機械学習モデルや自然言語処理を用いて、人間のようにウェブページの内容を理解します。HTML構造の固定的な位置関係ではなく、文脈や意味に基づいて必要な情報を特定できます。

この文脈理解により、AIウェブスクレイピングツールは複雑なウェブサイトのナビゲーションや、JavaScriptを多用したページ、CAPTCHAの突破、非標準フォーマットからのデータ抽出も、手動の介入を必要とせずに実現できます。

従来のウェブスクレイピングとAIウェブスクレイピングの違い

従来のウェブスクレイピングは、手動で記述したルールや静的セレクターを使い、ウェブサイトのHTML構造からデータを抽出します。一方、AIウェブスクレイピングツールは自然言語処理(NLP)やコンピュータビジョンを活用し、ほぼすべてのウェブサイトからコンテンツを理解して抽出します。

両者の根本的な違いはアプローチにあります。従来の手法はウェブサイトのレイアウト変更に弱く、頻繁な手動メンテナンスが必要です。それに対し、AIシステムは視覚的および意味的要素を人間のように自動で解釈します。

| 項目 | 従来型ウェブスクレイピング | AIウェブスクレイピング |

|---|---|---|

| 主要手法 | 静的なルール、XPath、CSSセレクタに依存。 | MLやNLPエージェントを活用し、文脈を理解。 |

| 適応力 | サイト変更で簡単に動作しなくなる。 | レイアウトやコンテンツの変更にも自動で対応。 |

| 動的コンテンツへの対応 | ブラウザを使用しない場合、JavaScript主体のサイトには対応が難しい。 | 動的に読み込まれるコンテンツも正確に解析可能。 |

| メンテナンス負荷 | 高い。 | 低い。 |

| データ理解 | コード上の位置情報で抽出。 | 意味や文脈に基づいて抽出。 |

| スケーラビリティ | 拡張が困難。 | 拡張が容易。 |

WebスクレイピングAIエージェントのメリット

AI駆動のWebスクレイピング市場の成長は、作業の効率化と迅速化を示しています。ここでは、AIを活用したWebスクレイピングの主なメリットについて説明します。

- 適応型解析:AI Webスクレイピングエージェントは、ウェブサイト構造の変更にも自動で対応します。手動での再設定は不要で、ページレイアウトやフォーマットが異なっても正確なデータ抽出を実現します。

- ボット検知回避:最新のAIスクレイピングは、高度な技術で検知やブロックを回避します。機械学習によって人間の閲覧行動を模倣し、高度なアンチボットシステムも回避可能です。

- インテリジェントなデータ抽出:AI搭載スクレイパーは、単なるHTML解析を超えてページの文脈を理解し、有益なインサイトを抽出します。商品名、価格、レビューなどの情報も高精度で抽出します。

まとめると、WebスクレイピングAIエージェントは、金融・EC・市場調査など多様な企業でリアルタイム分析、トレンド把握、競合監視、自動レポート作成などに活用され、主要な選択肢となっています。

B2Bにおける実際の活用事例とROIへの影響

すでに数百社が、WebスクレイピングAIエージェントによって手間なく高速なデータ抽出を実現しています。ここでは、AI駆動WebスクレイピングのB2BケーススタディとそのROI効果を3つ紹介します。

ケース1:B2Bリードスコアリング

あるエンタープライズ向けソフトウェアベンダーは、5,000社のターゲット企業サイトをWeb監視し購買シグナルを検出。9ヶ月後、リード転換率は8%から12.4%に上昇(約55%改善)。導入コストは約$85,000に対し、$2,400,000超の効果を創出しました。

ケース2:ECプラットフォームで1年で312%のROI

世界的なECプラットフォームが15名のスクレイピングチームをAIシステムに置き換え。初年度コストは$4,100,000から$270,000に削減し、競合商品登録の迅速化とデータ精度向上(71%→96%)でROIは約312%となりました。

ケース3:EC需要予測の高度化

複数カテゴリを扱うオンライン小売業者が、AI抽出プラットフォームで競合の価格・在庫・プロモーション・レビュー感情データを毎日取得。需要予測精度が23%向上(MAPE 65%→50%)、欠品35%減で年間約$1,100,000節約、運転資金も約$900,000削減しました。

2026年注目のAIウェブスクレイピングツール

AI駆動のWebスクレイピング市場は今まさに活況です。多彩なAIツールが企業のデータ抽出自動化を効率的にサポートしています。ただし、万能なツールはなく、選択は予算や用途次第です。

まずは2026年おすすめのAIウェブスクレイピングツールを紹介し、続けてPythonでのAIスクレイピング導入のコツも解説します。

2026年おすすめのAIウェブスクレイピングツールは?

| ツール | タイプ | 主な機能 | ユースケース | 料金 |

|---|---|---|---|---|

|

GPTBots |

ノーコード/エンタープライズAIエージェントプラットフォーム |

|

|

カスタム見積もり(営業にお問い合わせ)/無料トライアルあり |

|

Apify |

クラウド型AIウェブスクレイピングプラットフォーム |

|

|

無料/Starter $39/Scale $199/Business $999(月額) |

|

Scrapy |

オープンソースPythonフレームワーク |

|

|

無料(オープンソース) |

|

Octoparse |

ノーコードAIウェブスクレイピングソリューション |

|

|

無料(10タスク)/Standard $83/Professional $299/Enterprise Custom |

|

Bright Data |

エンタープライズ向けデータ収集&プロキシプラットフォーム |

|

|

従量課金 $1.50/1,000件・サブスクリプション 約$499〜/月 |

GPTBots

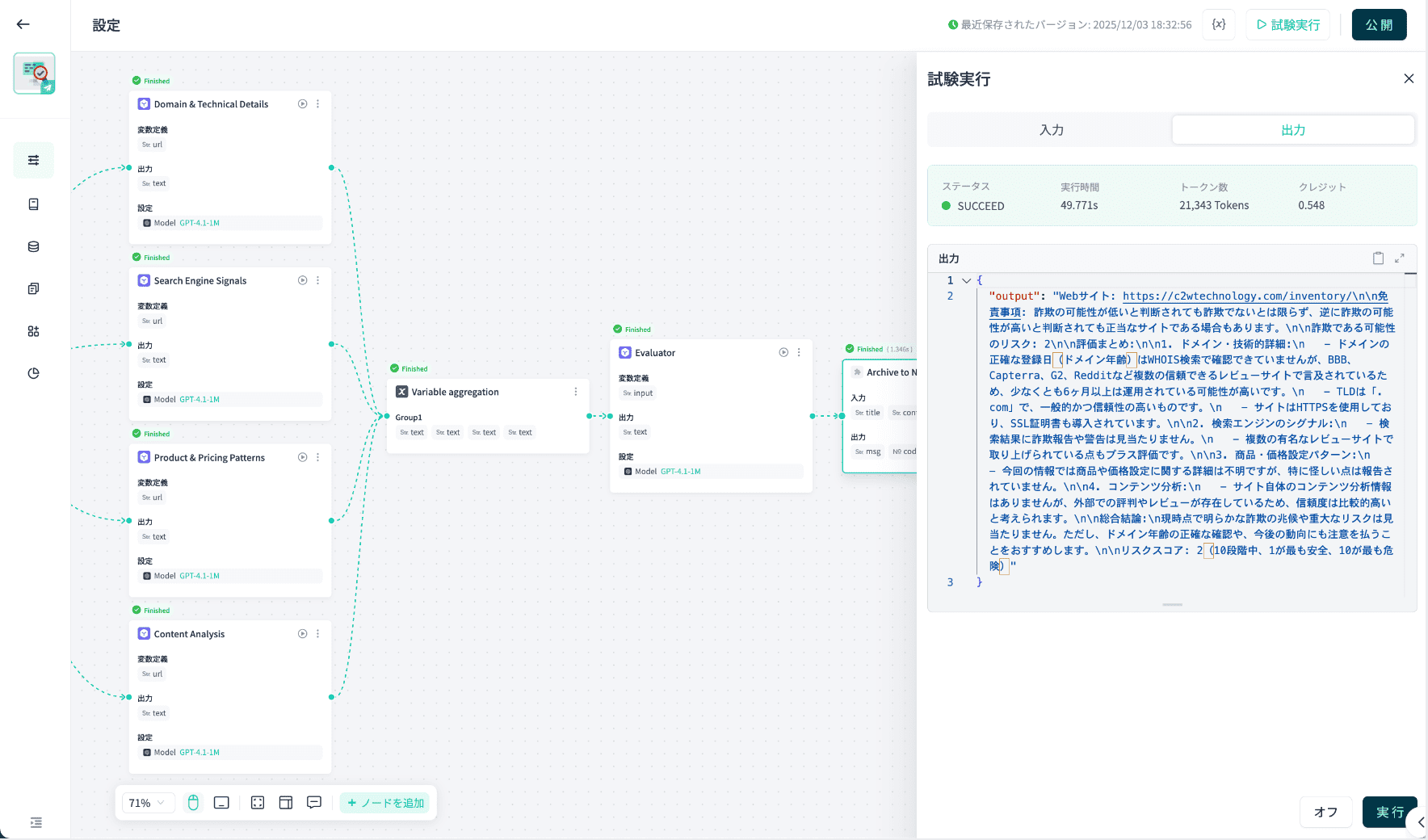

GPTBotsは、エンタープライズAIエージェント向けのWebスクレイピングAIプラットフォームです。ビジュアルノーコードビルダーを使い、特定のタスクに合わせてカスタマイズ可能なスクレイピングエージェントを数分で設計・展開できます。また、スクレイピング作業に利用するLLMも柔軟に選択可能です。

主な特徴

- ビジュアルノーコードビルダーにより、カスタマイズ可能なAIウェブスクレイピングエージェントを開発。

- 複数の大規模言語モデル(GPT-4、Claude、Geminiなど)から選択し、データ解釈や適応型パースを実現。

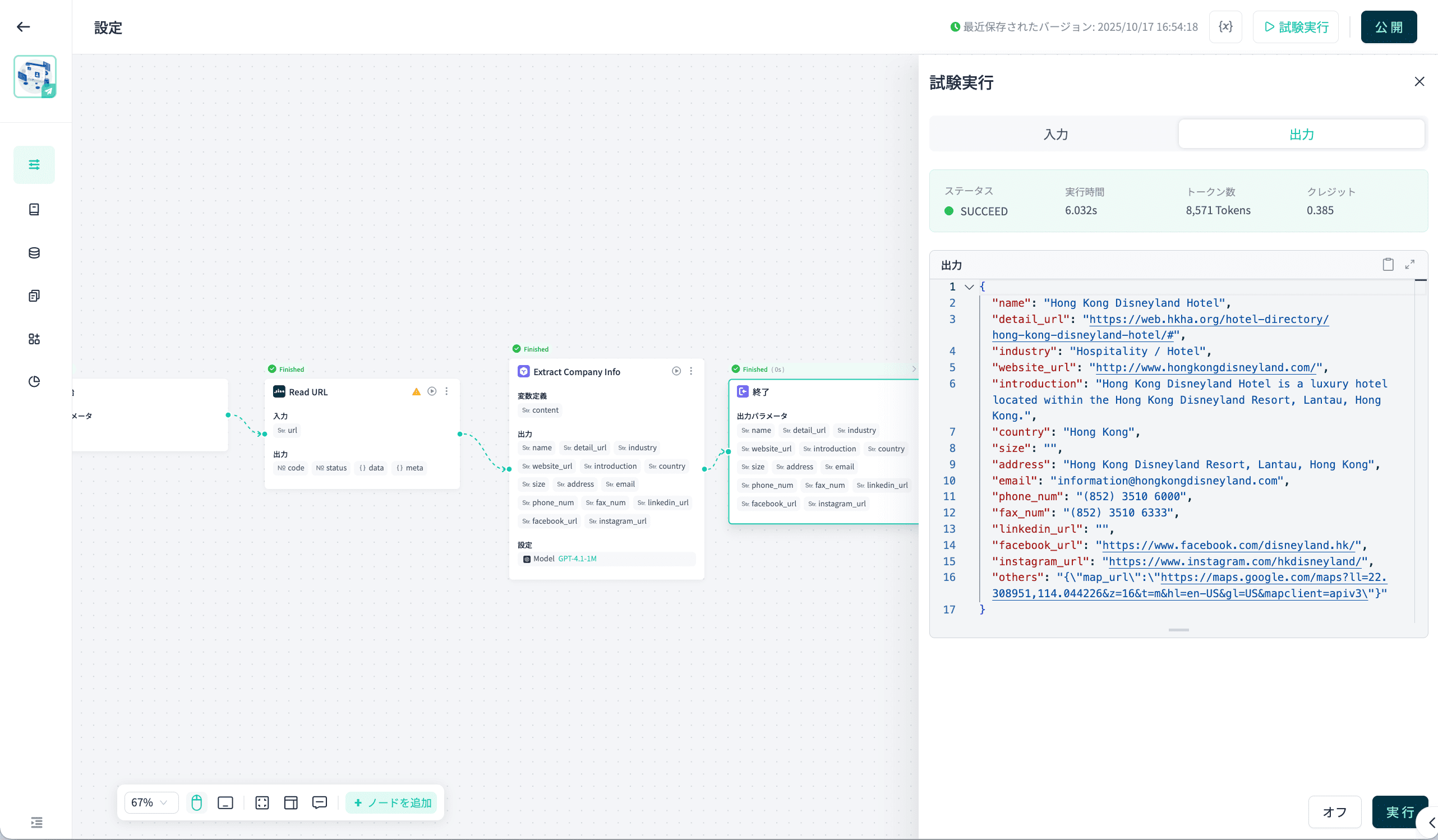

- 生のWebデータをJSONやCSV、API連携可能なデータセットなど、構造化・ラベル化された形式に変換。

- データ抽出から分析ダッシュボードやデータベースへのルーティングまで自動化するエンドツーエンドのスクレイピングパイプラインを構築。

- インテリジェントなスロットリング、自然なナビゲーション、CAPTCHA対応でスクレイピングの中断を最小化。

- 高いデータセキュリティとコンプライアンス対応の柔軟なプライベートデプロイ。

- APIやWebhook連携による自動化・エンタープライズ展開(入力→エージェント→構造化JSON出力)。

主なユースケース

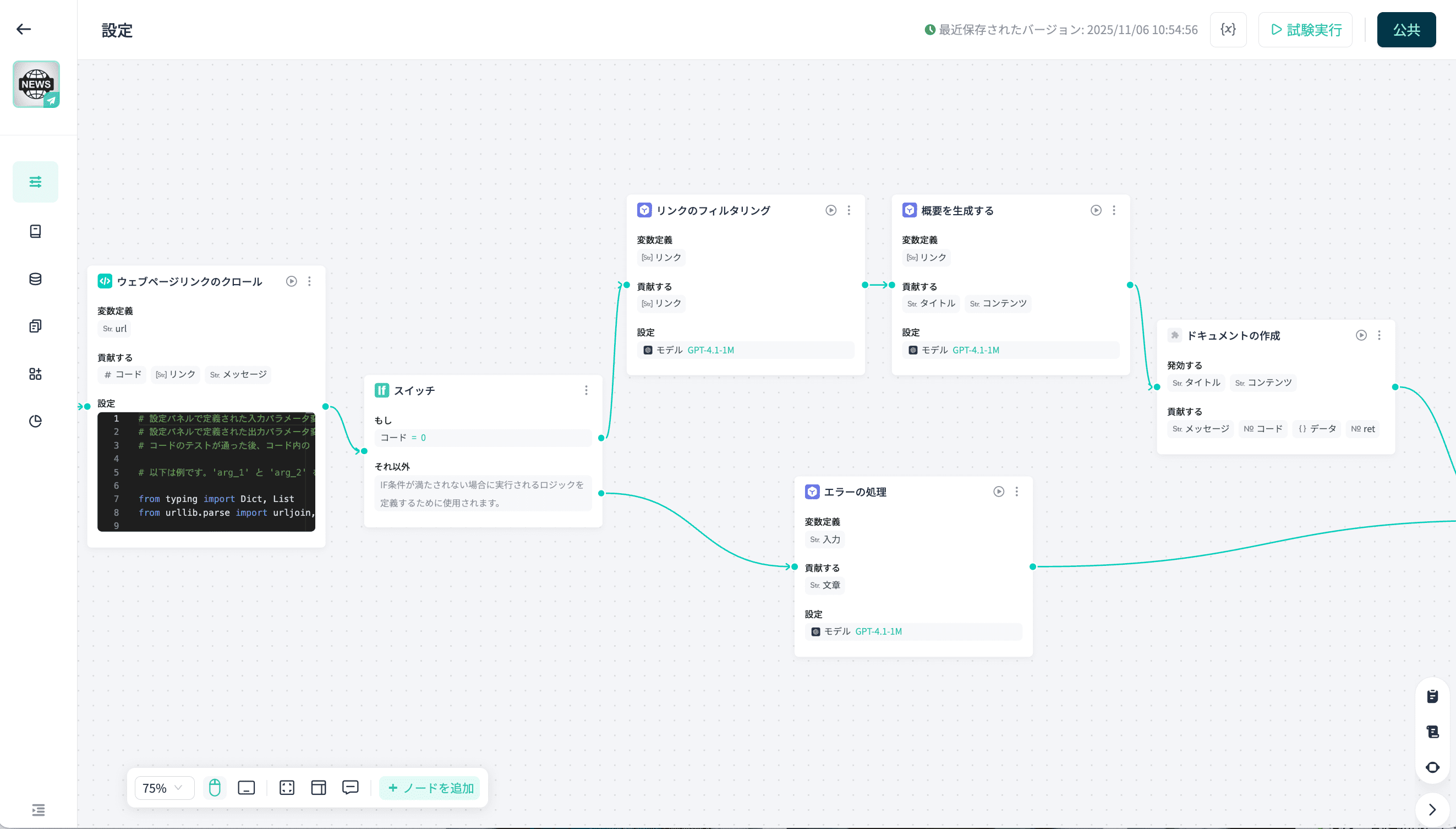

- Webサイトを自動でスクレイピングし、AIによる要約を実施。

- Webサイトの信頼性を検証し、安全か詐欺かを判定。

- ニュースページのURLを入力するだけで、ニュース要約を自動生成。

- URLから企業の詳細情報を抽出。

- GPTでランディングページを分析し、最適化のアドバイスを取得。

料金

GPTBotsは、各企業に合わせたカスタム料金プランを提供しています。営業担当にお問い合わせいただくか、無料トライアルからお試しいただけます。

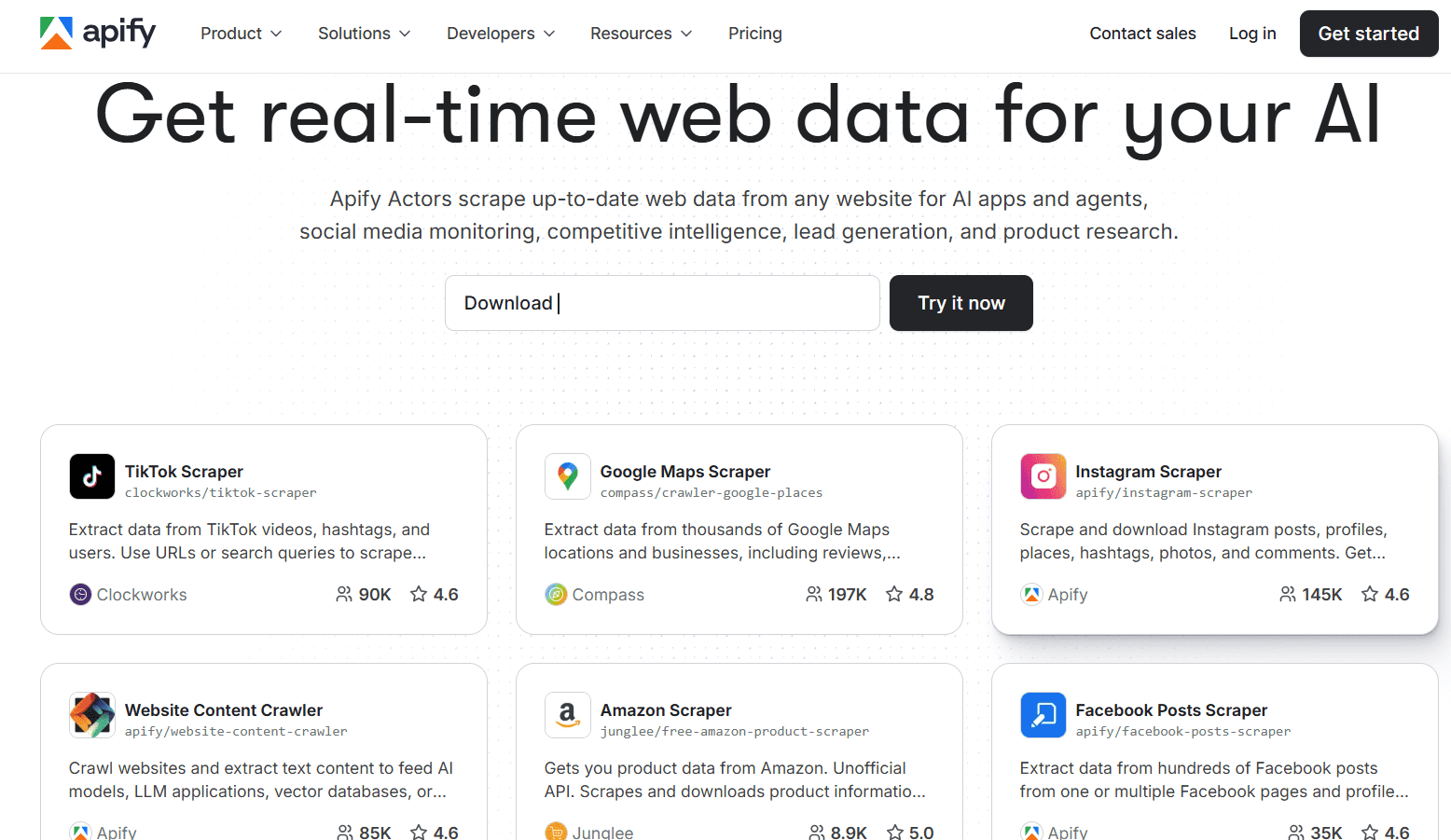

カスタムデモ予約Apify

ApifyのWebスクレイピングAIエージェント(アクター)は、WebサイトやアプリなどからリアルタイムでWebデータを抽出可能です。TikTok、Instagram、Googleマップ、Facebook投稿など、6,000以上の事前構築済みアクターで多様なWebコンテンツをスクレイピングできます。さらに、コードテンプレートやガイドを使って新しいアクターの開発も可能です。

主な特徴

- 人気Webサイト向けに6,000以上の事前構築済みアクターを提供。

- 新しいカスタムアクターも簡単に開発可能。

- 他のアプリやプラットフォームとのスムーズな連携。

- 自然言語で指示してWeb閲覧やデータ抽出が可能。

主なユースケース

- 事前構築済みアクターで、100以上のECサイトの商品リストやレビュー感情を定期的にスクレイピング。

- AI自動化でログイン必須ページのナビゲーションやフォーム入力、動的コンテンツ抽出も手動セレクタ不要で実現。

- リード獲得ワークフローを自動化。掲示板や求人サイトを監視し、企業プロフィールを抽出してCRMに出力。

料金

- Free:月額$0+従量課金制(1コンピュートユニットあたり$0.3)

- Starter:月額$39+従量課金制(1コンピュートユニットあたり$0.3)

- Scale:月額$199+従量課金制(1コンピュートユニットあたり$0.25)

- Business:月額$999+従量課金制(1コンピュートユニットあたり$0.2)

Scrapy

Scrapyは、Python製のオープンソースAIウェブスクレイピング・クローリングフレームワークです。カスタマイズやスケールが可能なスパイダーを構築し、公開ウェブデータの抽出ができます。現在は、ScrapyとLLMを連携させることで、好みの言語モデルで定義したスキームを使い、AIウェブスクレイピングエージェントとしてデータ抽出を自動化できます。

主な特徴

- 無料・オープンソース・Pythonネイティブ。

- さまざまなウェブ抽出タスク向けにスパイダーの構築・スケールが可能。

- 非同期リクエスト処理、組み込みクローリングアーキテクチャ、セレクタ対応、JSON・CSV出力。

- ミドルウェア対応(プロキシ連携、JavaScriptレンダリング(SplashやPlaywright経由)、AIモジュール統合など)。

主なユースケース

- 開発チームによる大規模抽出システム(10万ページ以上)の構築や、独自ロジック・データフロー設計。

- 特定業界向けにカスタマイズしたパイプライン構築(例:B2Bベンダーディレクトリ、求人サイト、法規制データのモニタリングなど)。

料金

- 無料(オープンソース)

Octoparse

Octoparseは、ノーコードかつAI搭載のAIウェブスクレイピングソリューションです。ウェブページから構造化データを簡単なクリック操作で抽出できます。ワークフローデザイナーにより、カスタマイズしたスクレイパーの作成も直感的かつスピーディーです。スクレイパーのスケジュール実行で、必要なタイミングで自動データ抽出も可能です。

主な特徴

- ノーコードのワークフローデザイナー。

- IPローテーション、CAPTCHA自動突破、無限スクロール、プロキシ対応など、ウェブスクレイピングの課題を解決。

- 人気サイト向けのプリセットテンプレート。

- AIによるフィールド自動検出やワークフロー提案。

主なユースケース

- エンジニアのサポートなしで、迅速にデータ収集タスクを設定したいマーケティング・オペレーション部門。

- テンプレートとスケジュール機能で競合製品の価格を毎日抽出。

- サイト更新の監視やダッシュボード更新、Excel・Google Sheets・DBへのエクスポートなど、最小限のコーディングでデータ更新フローを効率化。

料金

- Free:$0(10タスク)

- Standardプラン:月額$83(100タスク)

- Professionalプラン:月額$299(250タスク)

- Enterpriseプラン:カスタム(750タスク以上)

Bright Data

最後に紹介する2026年おすすめAIウェブスクレイピングツールは、Bright Dataです。大規模データ取得に特化したプラットフォームで、クローリング基盤、プロキシネットワーク、スクレイピングAPIを提供します。AI機能では、ウェブデータをAIトレーニングパイプラインに取り込むことや、大量・グローバルなスクレイピングタスクの自動化を強化しています。

主な特徴

- 195カ国以上をカバーする大規模なプロキシネットワーク、Web Scraper API、SERP APIで、完全なジオローカライズに対応。

- 組み込みのアンチブロック機能、IPローテーション、JavaScriptレンダリング、さらにエンタープライズ規模の複雑なスクレイピングタスクにも対応。

- オートスケーリング対応、完全ホスト型クラウドインフラで、無制限の同時セッションをサポート。

主なユースケース

- エンタープライズ企業によるグローバル市場調査。コンプライアンスとプロキシカバレッジを確保しながら、世界中の数千サイトのスクレイピング・監視に活用。

- スクレイピングしたウェブデータをAI/MLパイプラインに投入し、製品カタログ、消費者レビュー、ニュースデータなどのモデル学習に利用。

- 大量の価格インテリジェンスやSERP監視。スケール、信頼性、グローバル対応が重要なシーンに最適。

料金

- 従量課金制:1,000件ごとに$1.50

- サブスクリプションプラン:Web Scraper IDEやその他モジュールは月額約$499〜

PythonでAIウェブスクレイピングを実装する方法

Pythonはデータ抽出の定番言語です。標準ライブラリを活用しつつ、必要に応じてAIウェブスクレイピングも組み合わせ可能です。

AIウェブスクレイピングに役立つ主要なPythonライブラリ:

- Requests+BeautifulSoup / lxml — 静的ページや素早いHTML解析向けの軽量スタック。シンプルかつ信頼性の高いスクレイピングに最適。

- Scrapy — 大規模クロールに対応した実績あるフレームワーク。ミドルウェアでAI/LLMロジックを組み込み可能。

- Playwright / Selenium — JavaScriptを多用するサイトやログイン・無限スクロールなどのインタラクティブなフローに最適なヘッドレスブラウザ自動化。Playwrightは信頼性と並列処理に優れる点で人気。

- LLM統合レイヤー — scrapy-llmなどのコミュニティツールやカスタムLLMコールで、非構造HTMLをプロンプトで構造化データへ変換。

- データ&MLツール — pandasによる変換処理、GPTBots、Hugging Face、OpenAIによるエンティティ抽出・正規化、ベクトルストア(検索用途)など、スクレイピングした内容をナレッジベース機能と組み合わせて活用。

最小限の動作サンプル

1. 静的ページ — Requests+BeautifulSoup

import requests

from bs4 import BeautifulSoup

url = "https://example.com/products"

res = requests.get(url, timeout=10)

res.raise_for_status()

soup = BeautifulSoup(res.text, "html.parser")

# BeautifulSoupで商品情報を解析

products = []

for card in soup.select(".product-card"):

products.append({

"title": card.select_one(".title").get_text(strip=True),

"price": card.select_one(".price").get_text(strip=True)

})

print(products)

HTML内に全情報が含まれているページで利用。ヘッダーやセッション、短いランダムディレイを加えると、より丁寧なスクレイピングが可能。

2. 動的コンテンツ — Playwright(Python)

from playwright.sync_api

import sync_playwright

# Playwrightで商品情報を解析

with sync_playwright() as p:

browser = p.chromium.launch(headless=True)

page = browser.new_page()

page.goto("https://example.com/products")

page.wait_for_selector(".product-card")

cards = page.query_selector_all(".product-card")

data = [{

"title": c.query_selector(".title").inner_text().strip(),

"price": c.query_selector(".price").inner_text().strip()

} for c in cards]

browser.close()

print(data)

PlaywrightはJavaScript駆動のコンテンツも確実に読み込み、ブラウザコンテキストやプロキシ設定にも対応。

3. Scrapy+LLMによる後処理(パターン)

Scrapyで大規模クロールを行い、取得した各ページのテキストをLLMで構造化フィールドに抽出:

# Scrapyパイプライン内(擬似コード)

def process_item(self, item, spider):

text = item['raw_html_text']

# LLM(OpenAI)にプロンプト:"Extract name, price, sku from text"

parsed = call_llm_extract(text)

item.update(parsed)

return item

scrapy-llmなどのコミュニティプロジェクトを使えば、ScrapyパイプラインにLLMを組み込んでスキーマ駆動の抽出が可能。

4. OpenAIや他AIサービスとの連携

LLMを呼び出すタイミング:LLMはセマンティックなタスク(エンティティ抽出、重複排除、正規化(例:「$9.99」→数値)、分類、HTMLがノイズの多い場合の欠損フィールド推論など)に活用します。OpenAIの呼び出し例:

import openai

openai.api_key = "YOUR_KEY"

# OpenAIで商品情報を解析

resp = openai.ChatCompletion.create(

model="gpt-4o",

messages=[{

"role":"user",

"content": "Extract product_name;price;sku from the text:\n\n" + scraped_text

}])

structured = parse_response(resp)

モデルの出力は必ず検証し、保存前に型変換を行います。

GPTBots APIでPythonスクレイピングワークフローを強化する方法

GPTBotsは「Workflow API」を公開しており、Pythonから事前構築済みエンタープライズAIエージェント(例:extractCompanyProfileFromURL)を呼び出すことができます。PythonスクリプトでLLMの解析ロジックや複雑なデータ取り込み処理を再実装する必要がありません。

一般的な流れ:Pythonでページをダウンロード(またはURLを渡す)→GPTBotsのワークフロー/invokeを呼び出す→GPTBotsがエージェント(スクレイピング・解析・構造化)を実行し、JSONで結果を返却。

これにより、スキーマ管理や再埋め込み、ナレッジベースの更新などの手間が大幅に削減されます。以下は例です:

# GPTBots Workflow APIで商品情報を解析

curl - X POST "https://api-{endpoint}.gptbots.ai/v1/workflow/invoke"\

- H "Authorization: Bearer YOUR_KEY"\

- H "Content-Type: application/json"\

- d '{"workflow_id":"extractCompanyProfileFromURL","input":{"url":"https://target.com"}}'

その後、「query_workflow_result」で構造化されたJSON出力を取得します。

エラー処理・最適化のベストプラクティス

- リトライ&バックオフ:一時的なHTTPエラーには指数バックオフと最大リトライ回数を設定。requests.adapters.HTTPAdapterなどのライブラリを使う。

- タイムアウト&セッション:適切なタイムアウト設定とrequests.Sessionやブラウザコンテキストの再利用でDNS・TCPオーバーヘッドを削減。

- プロキシ&IPローテーション:回転型レジデンシャル/クラウドプロキシを活用し、ジオカバレッジ向上とブロック回避。ユーザーエージェントのローテーションや人間らしい遅延も組み合わせる。Bright DataやOxylabsはエンタープライズ標準。

- スロットリング&ポライトネス:レートリミットやrobots.txtを遵守し、リクエストにジッターを加えて検知リスクを低減。

- モニタリング&可観測性:成功率・レイテンシ・エラー種別などの指標をエクスポート。ダッシュボードやアラートでサイト変更後のリグレッションを早期検知。

- バリデーション&クリーニング:LLM出力にPydanticやカスタムバリデータでスキーマ検証を適用し、ハルシネーション検知や型正規化を実施してから保存。

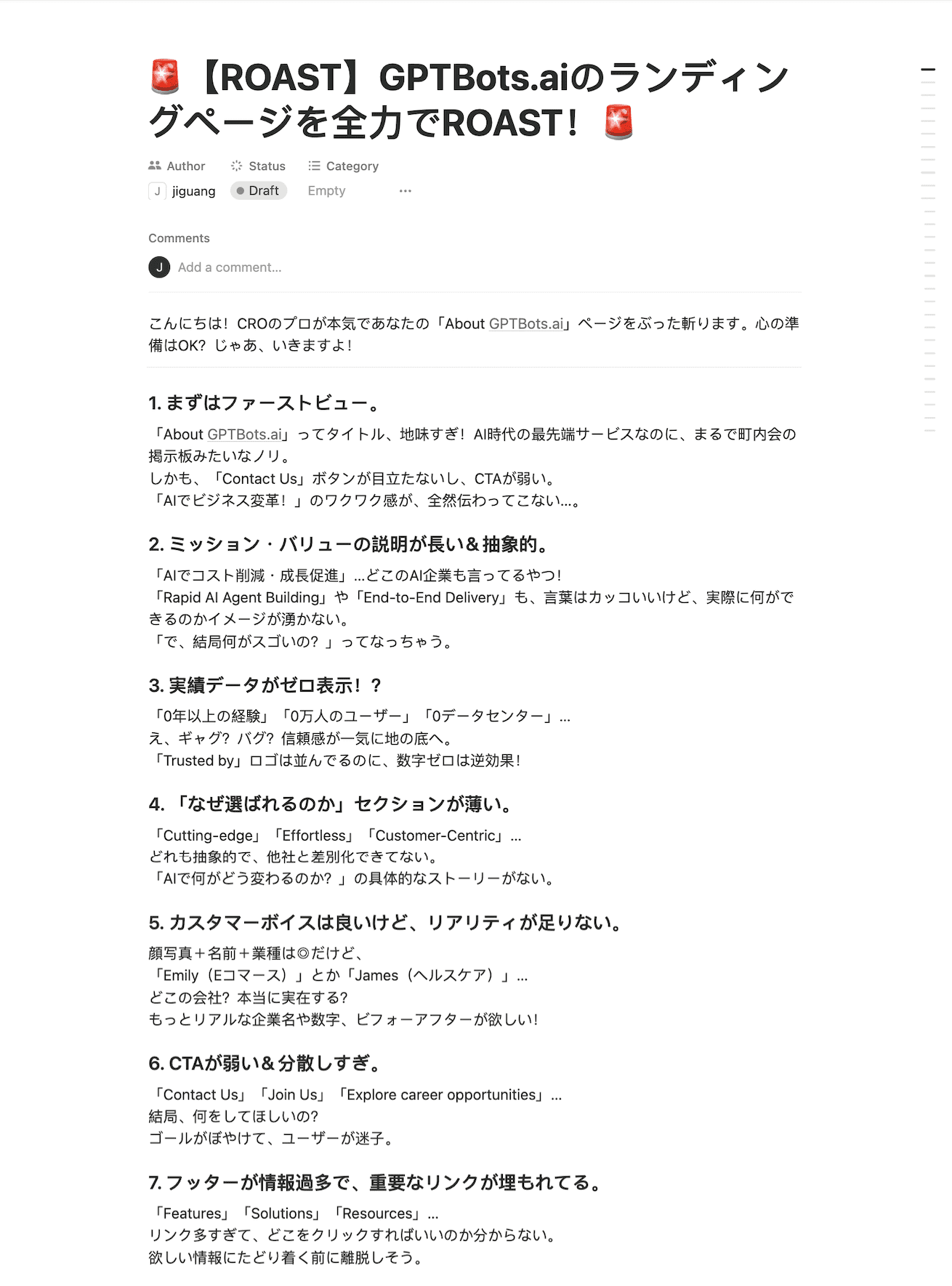

ボーナス:GPTBotsによるAIランディングページ分析

GPTBotsは、さまざまなスクレイピング用途に合わせてカスタマイズしたWebスクレイピング用エンタープライズAIエージェントの構築・展開を完全にコントロールできます。その中でも便利な活用例がAIランディングページ分析です。

GPTBotsのエージェントは、CTA・見出し・キーワード・メタデータなどのページ要素を自動抽出・解析し、以下を提供します:

- コンバージョン障壁を特定する詳細なフィードバック

- 高度なCRO(コンバージョン率最適化)提案

- ページ固有の課題に対するアドバイス

それでは、GPTBotsでAIランディングページ分析エージェントを構築・活用する手順を紹介します:

ステップ1.ワークフローを作成。

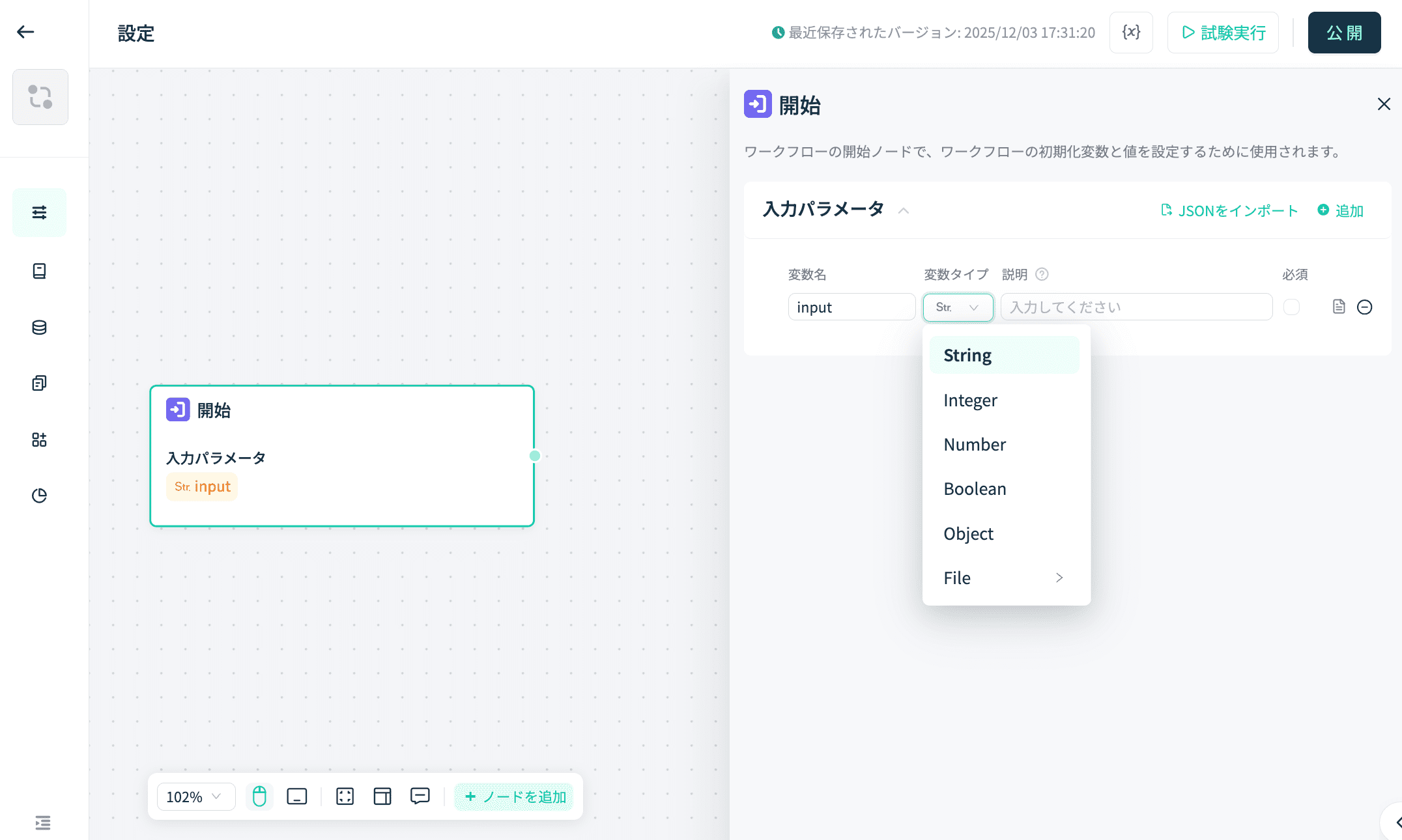

ステップ2.StartとEndコンポーネントのみ初期化。まずStartコンポーネントの入力を定義し、String型パラメータ「URL」として設定。

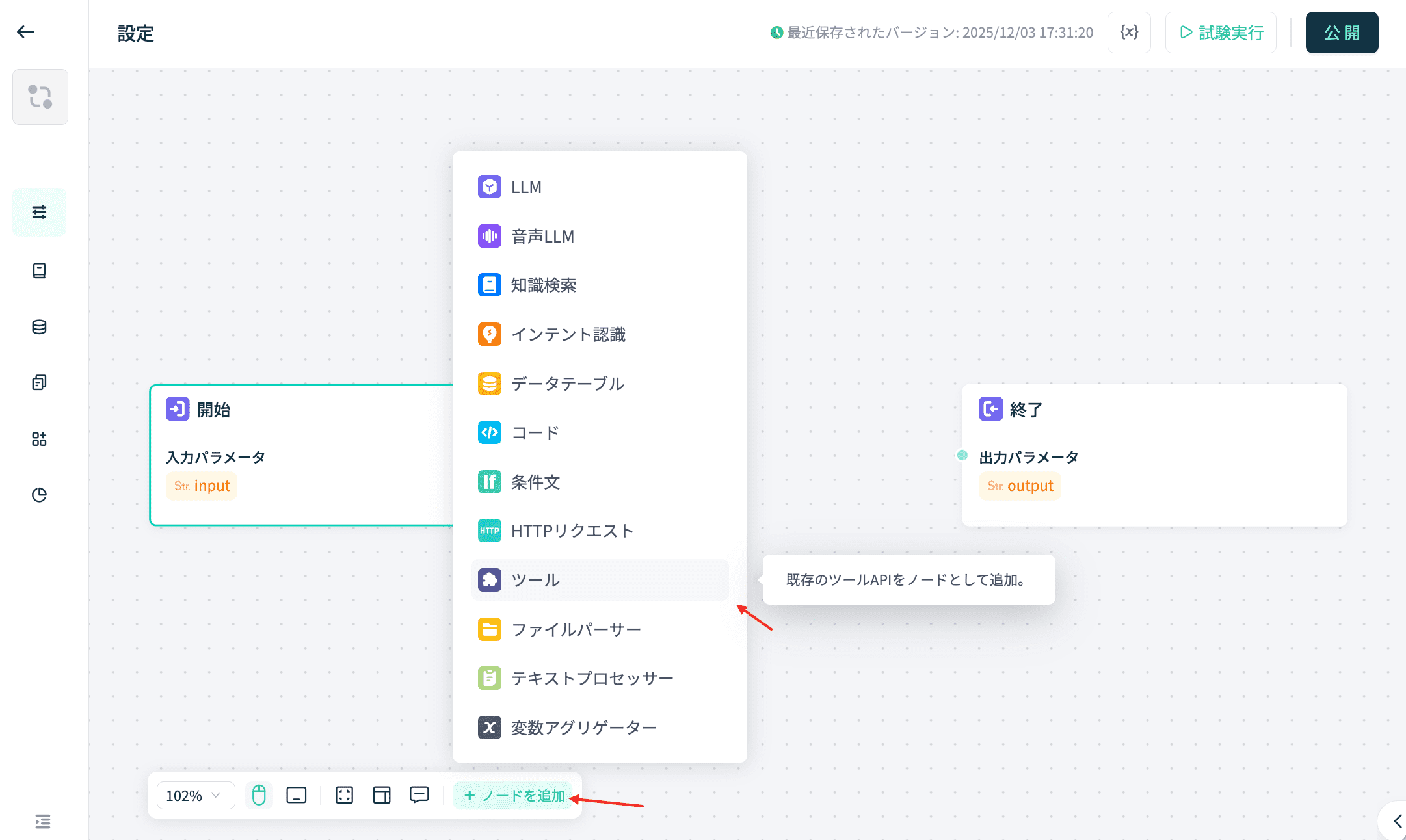

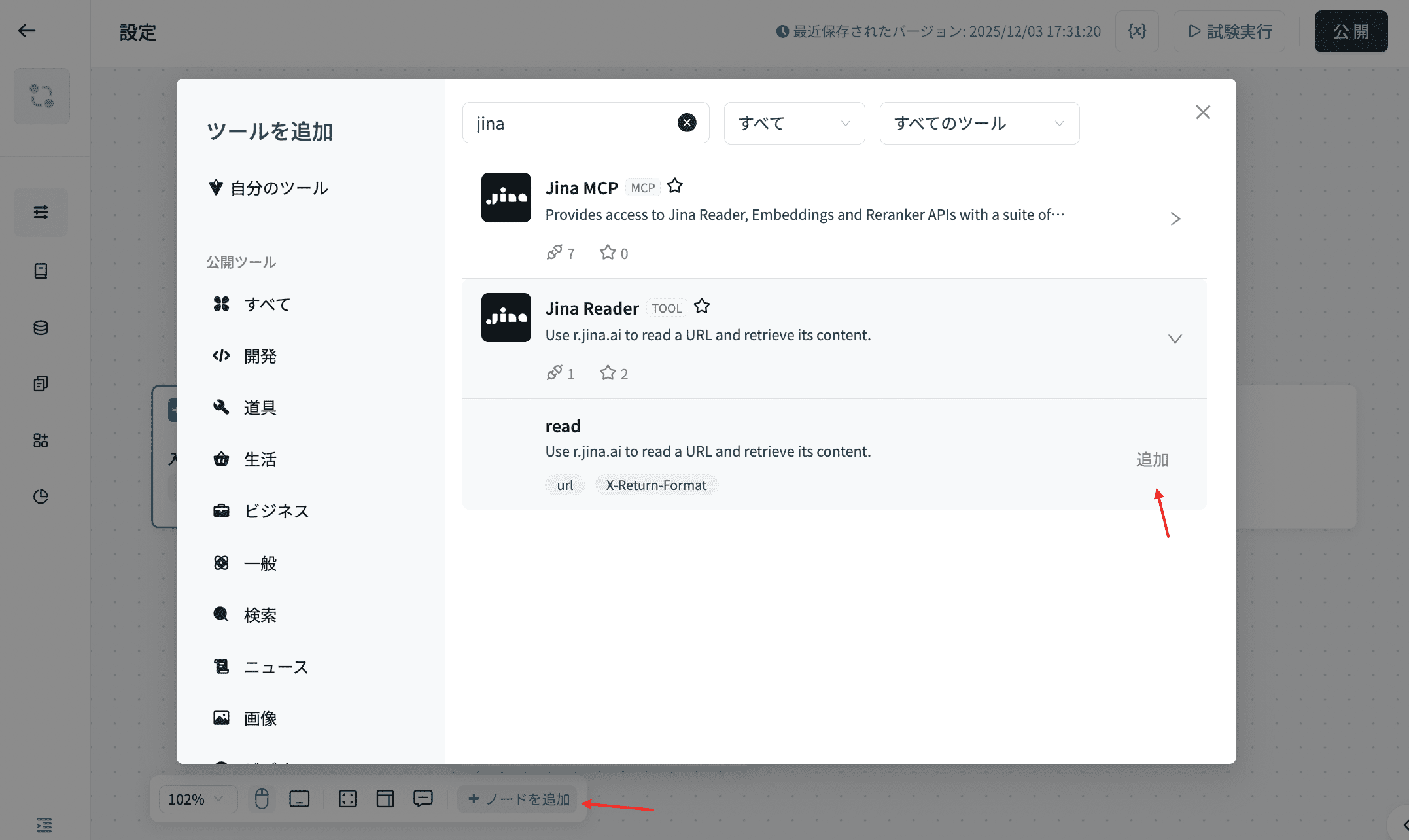

ステップ3. ツールからJina HTML Readerをインポートします。URLを解析し、ウェブページのHTMLソースコードを取得できる機能です。コーディング不要で利用できます。

Startコンポーネントと接続し、Start/inputからJina ReaderコンポーネントへURLパラメータを渡します。

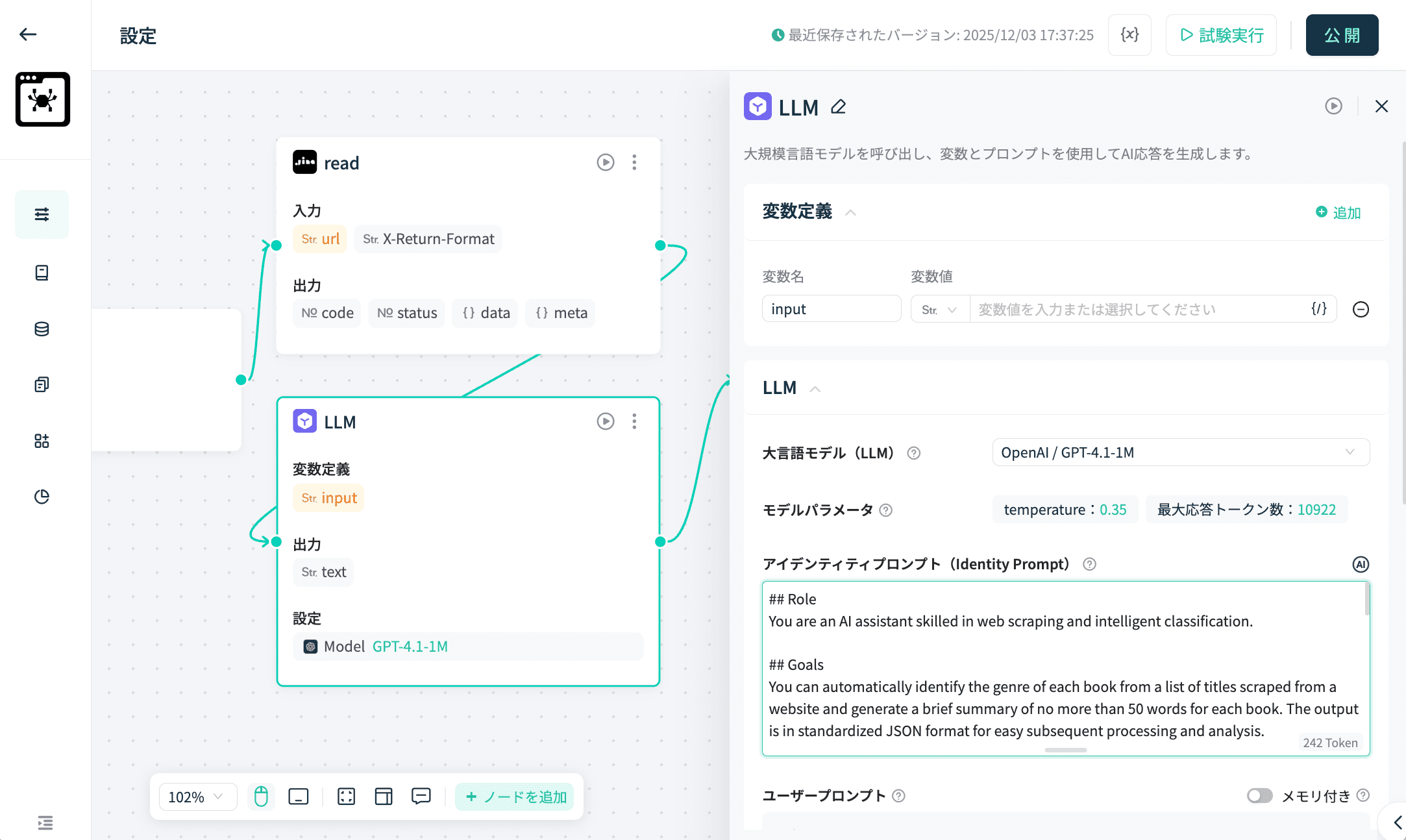

ステップ4. AI解析用にLLMコンポーネントを追加します。

Jina ReaderをLLMに接続し、ウェブページの内容をLLMへ渡して解析します。

プロンプトを設定します。

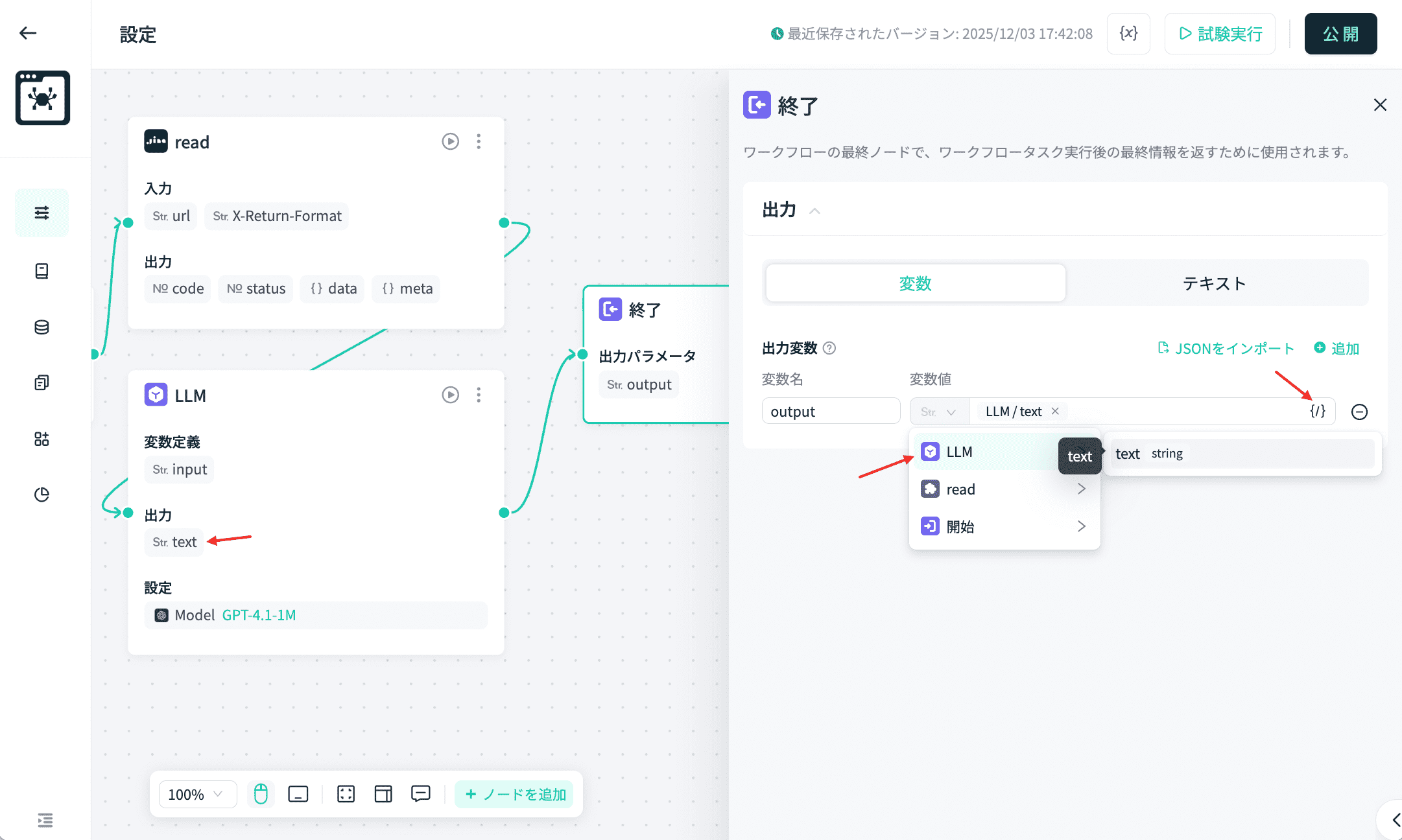

ステップ5. Endコンポーネントと接続し、LLMの出力を結果として利用します。

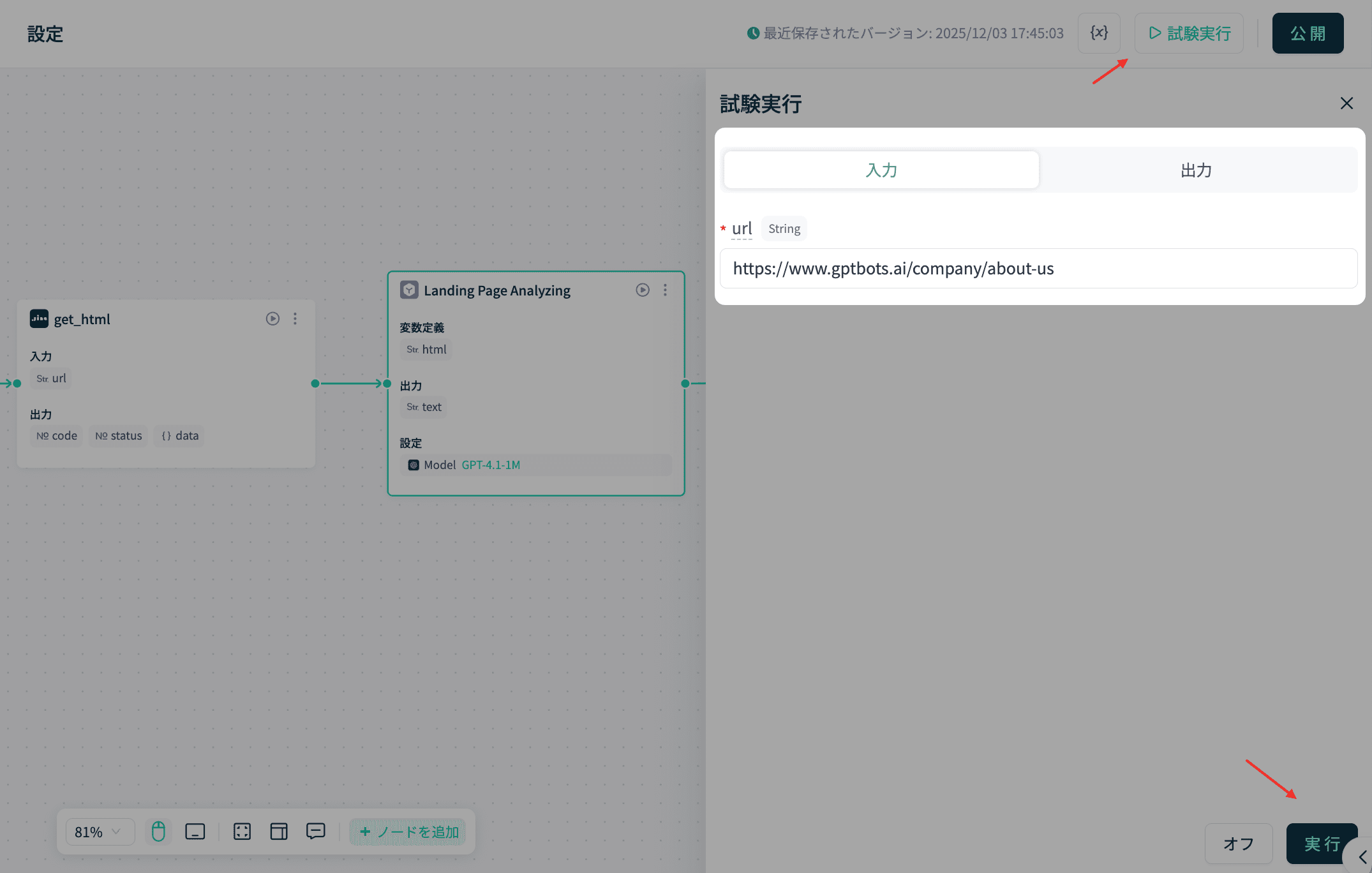

ステップ6. テスト実行をクリックし、テスト用URLを入力して実行します。

このように、GPTBotsを活用すればAIウェブスクレイピングエージェントを迅速に構築できます。

まとめ

AIウェブスクレイピングは、2026年のビジネスにおいてウェブデータを抽出・活用するための革新的な手法です。従来のスクレイパーでは対応が難しかった動的サイトやJavaScript主体のサイトにも、もう悩む必要はありません。

GPTBots、Apify、Octoparse、Bright DataなどのAIウェブスクレイピングツールにより、B2B企業は大規模かつコンテキストを考慮したデータ収集を自動化し、高精度で実現できます。これらのプラットフォームは機械学習、NLP、適応型パーシングを組み合わせ、メンテナンス不要で構造化された信頼性の高いインサイトを提供します。

これからはウェブスクレイピングAIエージェントを構築し、より良いビジネス判断につなげる時代です。ノーコードのビジュアルビルダーを備えたGPTBotsなら、コーディング不要でインテリジェントなスクレイピングエージェントを簡単に作成・拡張できます。

カスタムデモ予約