在数据驱动成为主流的当下,B2B企业对高质量数据的依赖程度持续攀升。根据 S&P Global Market Intelligence的研究 ,高达96%的受访者认为数据已成为影响关键业务决策的重要因素。然而,传统的网页爬虫技术在面对现代网页结构与AI Agent技术快速演进时,正变得力不从心。

传统爬虫往往依赖硬编码脚本与固定选择器,但随着网站大量采用JavaScript与复杂的动态渲染技术,这些方法不仅容易失效,还需要投入大量时间维护。一旦网站结构调整,整个爬取流程往往必须从头修复,效率低且成本高。

与此同时,AI驱动的网页爬取解决方案正迅速崛起。借助计算机视觉、自然语言处理(NLP)与机器学习模型,AI爬虫能够像人类一样理解网页内容,自动提取关键数据,并根据网站变动实时调整策略。因此,AI网页爬虫市场规模预计将从2025年的8.86亿美元跃升至2035年的 43.69亿美元 ,年复合增长率高达17.3%。

面对AI Agent在网页数据获取领域的迅速普及,我们特别制作了这份完整指南,帮助B2B企业全面了解AI网页爬虫的工作原理、应用场景与优势,并精选2026年值得入手的顶尖工具。现在,让我们一起深入探索AI网页爬虫如何重新定义数据获取方式!

AI网页爬虫是什么?为什么它如此重要?

AI网页爬虫是指利用人工智能(AI)来解释和提取网站数据。它将基于模式的提取理念转变为基于理解的提取。

AI驱动的网页爬取通过使用机器学习模型和自然语言处理来像人类一样理解网页内容。这些系统可以根据上下文和意义,而非HTML结构中的固定位置关系,识别您所需的信息。

这种上下文理解能力使AI爬取工具能够导航复杂网站、处理以JavaScript为主的页面、绕过验证码(CAPTCHA)验证,并从非标准格式中提取数据,而无需持续的人工干预。

传统网页爬虫与AI网页爬虫的对比

传统网页爬虫依赖于手动编写的规则和静态选择器,从网站的HTML结构中提取数据。而AI网页爬虫工具则利用自然语言处理(NLP)和计算机视觉来理解几乎任何网站的内容。

它们的核心区别在于方法的不同。传统方法不仅脆弱且易受网站布局更改的影响,还需要大量的人工维护,效率低下。而AI系统则能像人类一样自动解释视觉和语义元素。

| 对比维度 | 传统网页爬虫 | AI网页爬虫 |

|---|---|---|

| 核心方法论 | 依赖静态规则、XPaths路径和CSS选择器。 | 使用机器学习(ML)和自然语言处理(NLP)模型进行上下文理解。 |

| 适应性 | 网站更改时容易失效。 | 可自动适应布局和内容的变化。 |

| 处理动态内容 | 在没有浏览器的情况下难以处理以JavaScript为主的网站。 | 能够出色地解析动态加载的内容。 |

| 维护成本 | 高 | 低 |

| 数据理解 | 基于代码中的位置提取。 | 基于意义和上下文提取。 |

| 可扩展性 | 扩展性差 | 扩展性强 |

网页爬虫AI Agent的主要优势

蓬勃发展的AI驱动网页爬虫市场证明了这一新兴概念正在使爬取活动变得轻松快捷。那么,现在让我们来看看使用AI进行网页爬虫的操作优势:

- 自适应解析:网页爬虫AI Agent可以自动适应网站结构的变化,无需手动重新配置,确保针对不同页面布局和格式的精准数据提取。

- 绕过反爬虫检测:现代AI爬取解决方案采用复杂技术来避免检测和封锁。它们利用机器学习模仿人类浏览行为,从而绕过复杂的反爬虫系统。

- 智能数据提取:AI驱动的爬取工具不仅仅局限于基本的HTML解析技术。它们能够理解页面上下文并提取有意义的洞察数据,在识别实体(如产品名称、价格、评论等)方面表现出高度的准确性。

总而言之,网页爬虫AI Agent正成为金融、电商、市场研究等企业获取实时洞察、趋势分析、竞争监控和自动化报告的热门选择。

实际B2B应用案例及投资回报影响

数百家企业现在正在使用网页爬虫AI Agent,以更快的数据提取和最小的努力实现目标。以下是三个AI驱动网页爬虫的实际B2B应用案例及其投资回报影响:

案例研究1:B2B潜在客户评分

一家企业软件供应商对5000个目标公司网站进行了购买信号的网页监控。九个月后,线索转化率从8%上升到12.4%(约+55%的提升)。此外,约8.5万美元的实施成本带来了240万美元以上的收益。

案例研究2:电商平台实现312%年投资回报率

一家全球电商平台用AI驱动的系统取代了15人的爬虫团队。第一年的成本从410万美元降至27万美元,由于更快的竞争对手上线和数据准确率从71%提高到96%,投资回报率达到了约312%。

案例研究3:电商需求预测

一家多品类在线零售商每天使用AI驱动的提取平台爬取竞争对手的定价、库存情况、促销和评论情感数据。这提高了需求预测的准确性23%(从65%到50% MAPE),库存短缺减少了35%,显著提升了供应链效率,每年节省约110万美元,并释放了约90万美元的营运资本。

2026年顶级AI网页爬虫工具

AI驱动的网页爬虫市场正处于全面发展阶段。目前有大量AI网页工具帮助企业以高效的方式实现数据提取自动化。然而,并没有一种适合所有场景的解决方案。选择取决于您的预算和使用场景。

因此,让我们先来看看2026年最佳AI网络爬虫工具,然后学习如何使用Python实现AI网络爬虫的技巧。

2026年最佳AI网页爬虫工具有哪些?

| 工具名称 | 工具类型 | 主要功能 | 适用场景 | 价格方案 |

|---|---|---|---|---|

|

GPTBots |

可视化零代码 / 企业级AI Agent平台 |

|

|

定制化定价(联系销售)/ 提供免费试用 |

|

Apify |

基于云的AI网页爬取平台 |

|

|

免费 / 入门版 39美元 / 扩展版 199美元 / 商业版 999美元 每月 |

|

Scrapy |

开源Python框架 |

|

|

免费(开源) |

|

Octoparse |

零代码AI网页爬取解决方案 |

|

|

免费(10个任务)/ 标准版 83美元 / 专业版 299美元 / 企业版 定制 |

|

Bright Data |

企业数据采集与代理平台 |

|

|

按需付费,每1000条结果$1.50 / 订阅费用约$499起每月 |

GPTBots - 企业级网页爬虫AI Agent平台

GPTBots是一个无代码AI Agent构建平台,可在几分钟内构建和部署企业级网页爬虫AI Agent。它提供无代码可视化构建器,帮助您设计定制化爬虫智能体以完成特定任务。此外,它还允许您选择特定的大语言模型(LLMs)用于爬取活动。

主要功能

- 可视化无代码构建器,用于开发定制化网页爬虫AI Agent。

- 可选择多种大语言模型(GPT-4、Claude、Gemini等)以支持数据解读和自适应解析。

- 将原始网页数据转换为结构化格式(如JSON、CSV),并支持API集成。

- 创建端到端爬取管道,自动提取并将数据路由到分析仪表板或数据库。

- 智能限速、人性化导航和CAPTCHA处理,以减少爬取中断。

- 灵活的私有部署选项,确保数据安全和合规性。

- 提供API/webhook集成,用于自动化和企业部署(输入 → 智能体 → 结构化JSON输出)。

使用场景

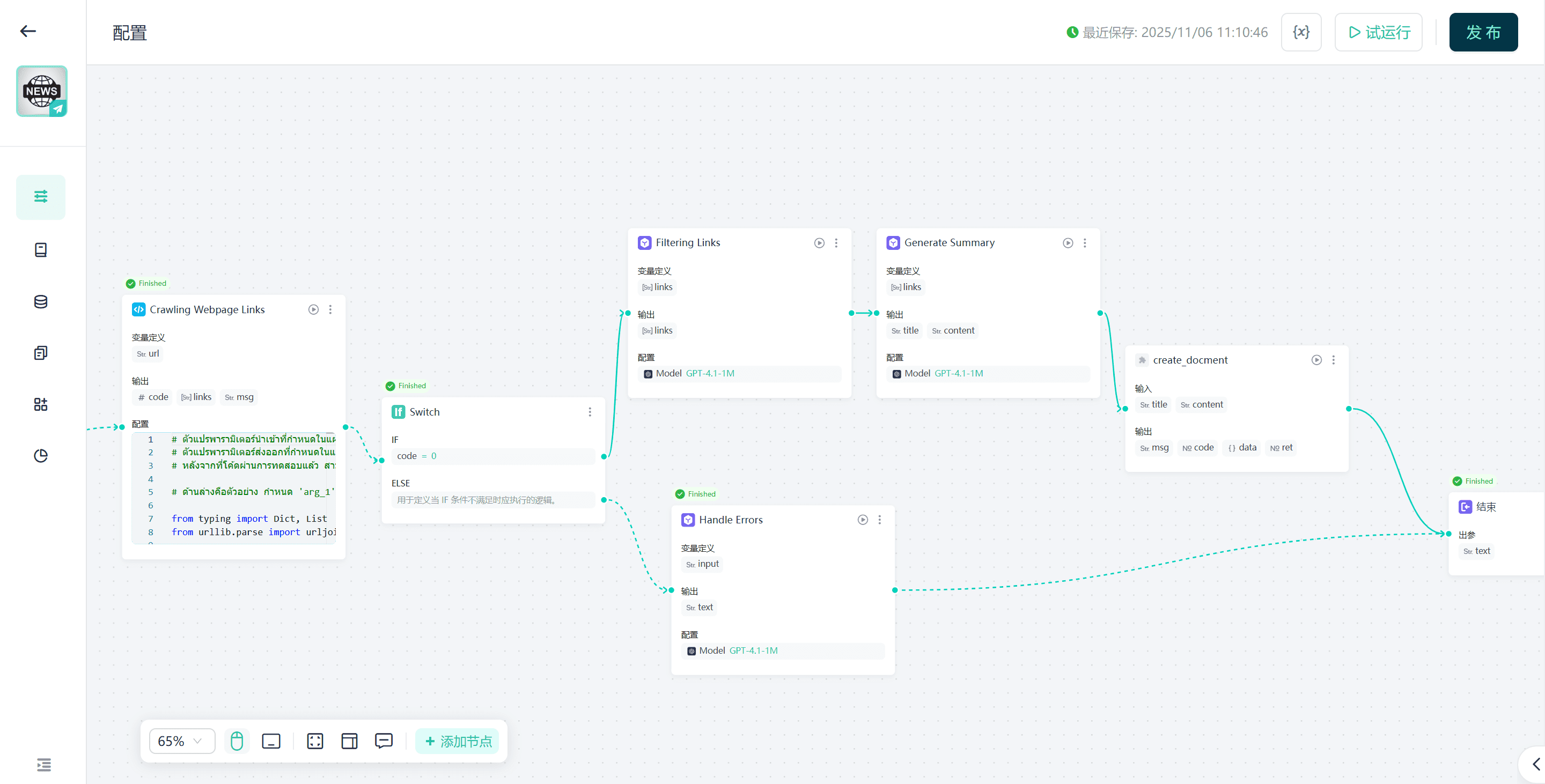

- 自动爬取网站并使用AI进行摘要总结。

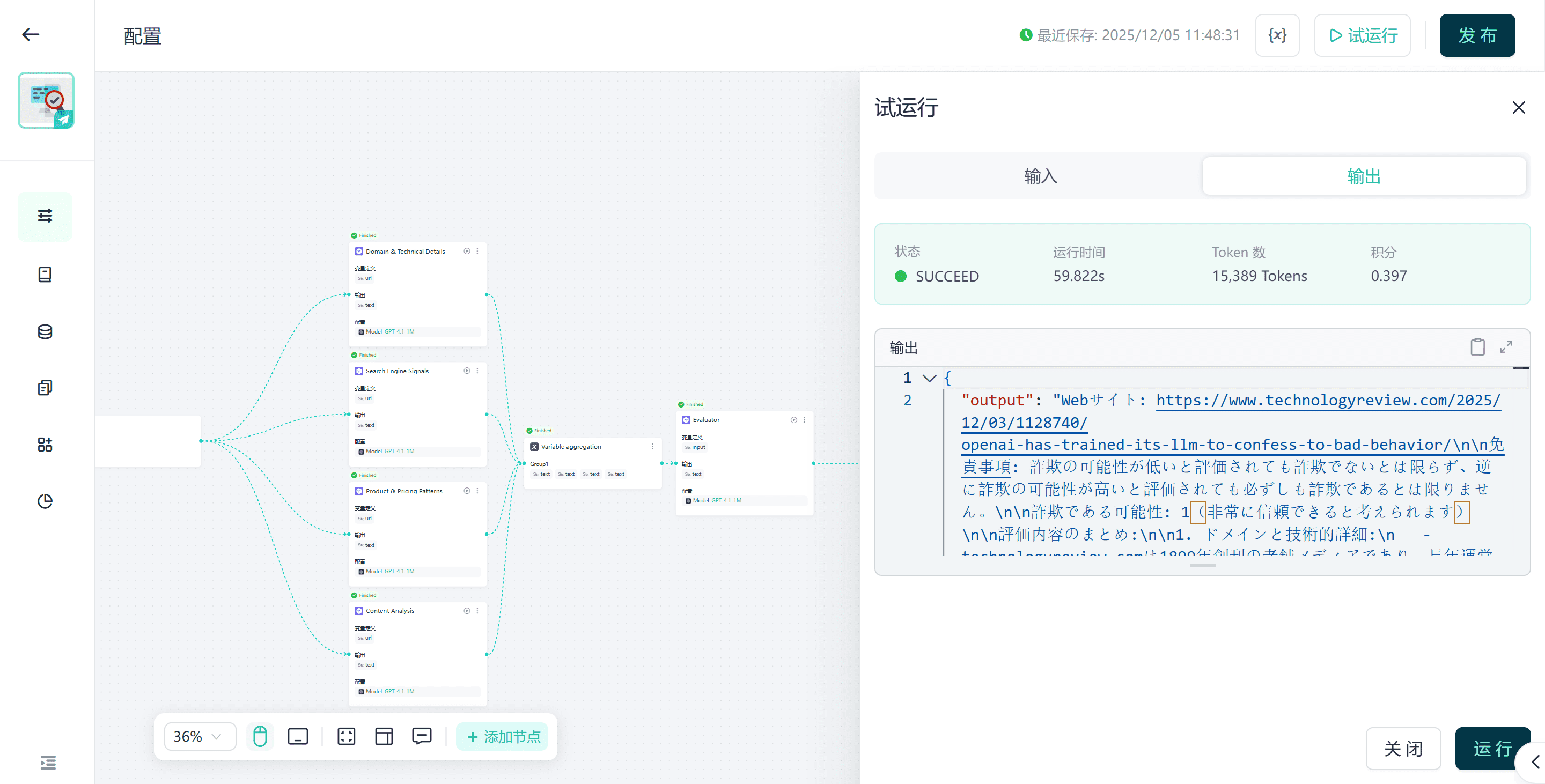

- 验证网站合法性,判断其是否可信或存在欺诈风险。

- 通过输入新闻网页URL生成新闻摘要。

- 从URL中提取公司的详细信息。

- 使用GPT分析着陆页并获取优化建议。

定价

GPTBots根据组织需求提供定制化定价方案。您可以联系销售团队申请演示或从免费试用开始。

获取定制化演示Apify

Apify的网页爬虫AI Agent模块(称为Actors)可以从网站、应用程序等提取实时网页数据。它提供了超过6000个用于爬取网站内容的智能体模块,包括TikTok、Instagram、Google Maps、Facebook帖子等。此外,它还允许用户使用代码模板和指南构建新的智能体模块。

主要功能

- 超过6000个预构建的热门网站爬取模块。

- 轻松开发新的定制化智能体模块。

- 与其他应用/平台的无缝集成。

- 使用自然语言指令浏览网页并提取数据。

使用场景

- 通过内置智能体模块定期爬取100多个电商网站的产品列表和评论情绪。

- 利用AI自动化导航登录保护页面、填写表单并提取动态内容,无需手动选择器编码。

- 自动化线索生成工作流,例如监控论坛/招聘网站信号,提取公司资料并输出到CRM。

定价

Apify提供多种定价选项:免费版 / 入门版 $39 / 扩展版 $199 / 商业版 $999 每月,具体可根据需求选择。

- 免费版:$0/月 + 按使用量付费($0.3 每计算单位)。

- 入门版:$39/月 + 按使用量付费($0.3 每计算单位)。

- 扩展版:$199/月 + 按使用量付费($0.25 每计算单位)。

- 企业版:$999/月 + 按使用量付费($0.2 每计算单位)。

Scrapy

Scrapy 是一个基于Python的开源网络爬取和数据提取框架。它用于构建自定义且可扩展的爬虫,以提取公共网络数据。然而,现在我们可以将LLM与Scrapy集成,使其作为一个AI网络爬取智能体运行,能够使用我们首选语言模型中的预定义方案从网络中提取数据。

主要功能

- 免费、开源且原生支持Python。

- 构建并扩展爬虫,以完成任何网络数据提取任务。

- 支持异步请求处理、内置爬取架构、选择器支持,以及导出为JSON/CSV格式。

- 支持中间件,包括代理集成、JavaScript渲染(通过Splash或Playwright),以及与高级AI模块的集成。

使用场景

- 开发团队构建具有自定义逻辑和数据流的大规模提取系统(10 万页以上)。

- 为特定行业构建定制化的管道,具有定制化的逻辑和存储,例如监控B2B供应商目录、招聘网站或监管文件。

定价

- 免费使用(开源)。

Octoparse

Octoparse 是一个无代码且基于AI的网络爬取解决方案,通过简单点击即可从网页中提取结构化数据。其工作流设计器使得指导定制化网络爬取器变得简单快捷。您还可以安排爬取器按时提取数据。

主要功能

- 无代码工作流设计器。

- 通过IP轮换、验证码识别、无限滚动、代理等功能克服网络爬取挑战。

- 为热门网站提供预设模板。

- AI辅助自动检测字段和工作流建议。

使用场景

- 营销或运营团队需要快速设置数据收集任务,无需工程支持。

- 通过模板 + 调度每日提取竞争对手产品价格。

- 通过监控网站更改、更新仪表板以及以最少编码导出数据到Excel/Google Sheets/数据库,简化数据刷新工作流。

定价

- 免费版:$0(10 个任务)。

- 标准计划:$83/月(100 个任务)。

- 专业计划:$299/月(250 个任务)。

- 企业计划:定制(750+ 个任务)。

Bright Data

在我们2026年最佳AI网络爬取工具列表中,最后一个是 Bright Data。它是一个大规模数据获取平台,提供爬取基础设施、代理网络和爬取API。其AI功能强调将网络数据输入AI训练管道的能力,并通过自动化处理大规模和全球爬取任务。

主要功能

- 大规模代理网络 + 网页爬虫API +SERP API,覆盖195+个国家,支持完整的地理定位。

- 内置防屏蔽功能、IP轮换、JavaScript渲染,以及企业级支持,用于复杂的爬取任务。

- 自动伸缩的全托管云基础设施,支持无限并发会话。

使用场景

- 企业公司进行全球市场研究,例如爬取和监控跨地域的数千个网站,确保合规性和代理覆盖。

- 将爬取的网页数据输入AI/ML管道,用于训练模型,例如产品目录、消费者评论和新闻数据。

- 高量级的价格情报或SERP监控,在规模、可靠性和全球覆盖方面至关重要。

定价

- 按需付费:每 1,000 个结果 1.50 美元,适用于小规模或临时爬取需求。

- 订阅计划起价约为每月 499 美元,适用于网页爬虫IDE或其他模块。

如何使用Python实现AI网页爬虫?

Python依然是数据提取的主力工具。您可以结合标准库和AI网页爬虫技术,根据需求灵活使用。

Python AI爬虫的必备库

- Requests + BeautifulSoup / lxml:轻量级工具栈,适合静态页面和快速HTML解析。

- Scrapy:可扩展且经过实战验证的爬取框架,支持中间件钩子以插入AI/LLM逻辑。

- Playwright / Selenium:驱动无头浏览器,适用于JavaScript密集型网站和交互式操作(如登录、无限滚动)。Playwright因其可靠性和并发性更受欢迎。

- LLM集成层:社区工具如scrapy-llm或自定义LLM调用,使用提示将非结构化HTML转换为结构化数据。

- 数据和机器学习工具:pandas用于数据转换,GPTBots、Hugging Face或OpenAI用于实体提取/规范化,以及向量存储(例如用于搜索),当您将爬取的内容与知识库功能结合时。

简易运行示例

1. 静态页面 — Requests + BeautifulSoup

import requests

from bs4 import BeautifulSoup

url = "https://example.com/products"

res = requests.get(url, timeout=10)

res.raise_for_status()

soup = BeautifulSoup(res.text, "html.parser")

# 使用BeautifulSoup解析静态页面中的产品信息

products = []

for card in soup.select(".product-card"):

products.append({

"title": card.select_one(".title").get_text(strip=True),

"price": card.select_one(".price").get_text(strip=True)

})

print(products)

适用于HTML包含完整内容的页面。添加请求头、会话以及短随机延迟以保持礼貌。

2. 动态内容 — Playwright(Python)

from playwright.sync_api

import sync_playwright

# 使用Playwright解析动态页面中的产品信息

with sync_playwright() as p:

browser = p.chromium.launch(headless=True)

page = browser.new_page()

page.goto("https://example.com/products")

page.wait_for_selector(".product-card")

cards = page.query_selector_all(".product-card")

data = [{

"title": c.query_selector(".title").inner_text().strip(),

"price": c.query_selector(".price").inner_text().strip()

} for c in cards]

browser.close()

print(data)

Playwright可靠加载JS驱动的内容,并支持浏览器上下文和代理设置。

3. Scrapy + LLM后处理(模式)

Scrapy大规模爬取并将每个爬取页面的文本发送到LLM以提取结构化字段:

# 在您的Scrapy管道中(伪代码)

def process_item(self, item, spider):

text = item['raw_html_text']

# 使用提示调用LLM(OpenAI):"从文本中提取名称、价格、SKU"

parsed = call_llm_extract(text)

item.update(parsed)

return item

社区项目如scrapy-llm展示了如何将LLM集成到Scrapy管道中进行基于模式的提取。

4. 与OpenAI及其他AI服务的集成

何时调用大模型(LLM):请使用LLM处理语义任务——实体提取、去重、标准化(例如,将“$9.99”转换为数值)、分类,或在HTML内容混乱时推断缺失字段。以下是调用OpenAI的示例:

import openai

openai.api_key = "YOUR_KEY"

# 调用OpenAI模型解析产品名称、价格和SKU信息

resp = openai.ChatCompletion.create(

model="gpt-4o",

messages=[{

"role":"user",

"content": "从文本中提取product_name;price;sku:\n\n" + scraped_text

}])

structured = parse_response(resp)

请始终验证模型输出,并在存储之前对数据类型进行转换。

GPTBots API如何提升Python爬虫工作流

GPTBots提供了一个“工作流API”,您可以通过Python调用该API以运行预构建的AI Agent(例如,公司信息提取工作流--extractCompanyProfileFromURL),这样您的Python脚本无需重新实现LLM解析逻辑或编排多步骤数据摄取。

典型流程是:Python下载页面(或传递URL)→ 调用GPTBots工作流/调用接口 → GPTBots运行其智能体(爬取/解析/结构化)并返回JSON。

这减少了关于模式管理、重新嵌入和知识库更新的维护工作。以下是一个示例:

# 使用GPTBots工作流API解析产品信息

curl - X POST "https://api-{endpoint}.gptbots.ai/v1/workflow/invoke"\

- H "Authorization: Bearer YOUR_KEY"\

- H "Content-Type: application/json"\

- d '{"workflow_id":"extractCompanyProfileFromURL","input":{"url":"https://target.com"}}'

然后轮询“query_workflow_result”以获取结构化的JSON输出。

最佳错误处理和优化技术

- 重试与退避:请为临时HTTP错误实现指数退避并设置最大重试次数。使用库或适配器,例如requests.adapters.HTTPAdapter。

- 超时与会话:请设置合理的超时时间,并重用requests.Session() 或浏览器上下文以减少DNS和TCP开销。

- 代理与IP轮换:请利用轮换住宅/云代理,以增强地理覆盖并最小化封禁风险。结合用户代理轮换和模拟人类行为的延迟。Bright Data和Oxylabs是企业级需求的标准提供商。

- 限速与礼貌:请遵守速率限制、适用的robots.txt,并在请求中添加抖动以减少检测信号。

- 监控与可观测性:请导出指标(成功率、延迟、错误类型)。使用仪表盘和警报功能在站点更改后发现回归问题。

- 验证与清理:请对LLM输出应用模式验证(Pydantic或自定义验证器)以捕捉幻觉,并在存储前规范化数据类型。

加分项:使用GPTBots进行AI着陆页分析

GPTBots为您提供了完全的控制权,您可以为不同的爬取活动构建和部署定制化的网页爬取AI智能体。其中一个有用的应用是 AI着陆页分析。

在这里,GPTBots AI Agent会自动提取并解释页面上的元素,例如CTA(号召性用语)、标题、关键词和元数据。基于这些信息,它提供:

- 详细反馈,指出转化障碍。

- 高级CRO(转化率优化,Conversion Rate Optimization)建议。

- 针对特定页面挑战的建议。

现在让我们看看如何使用GPTBots构建和使用AI着陆页分析智能体:

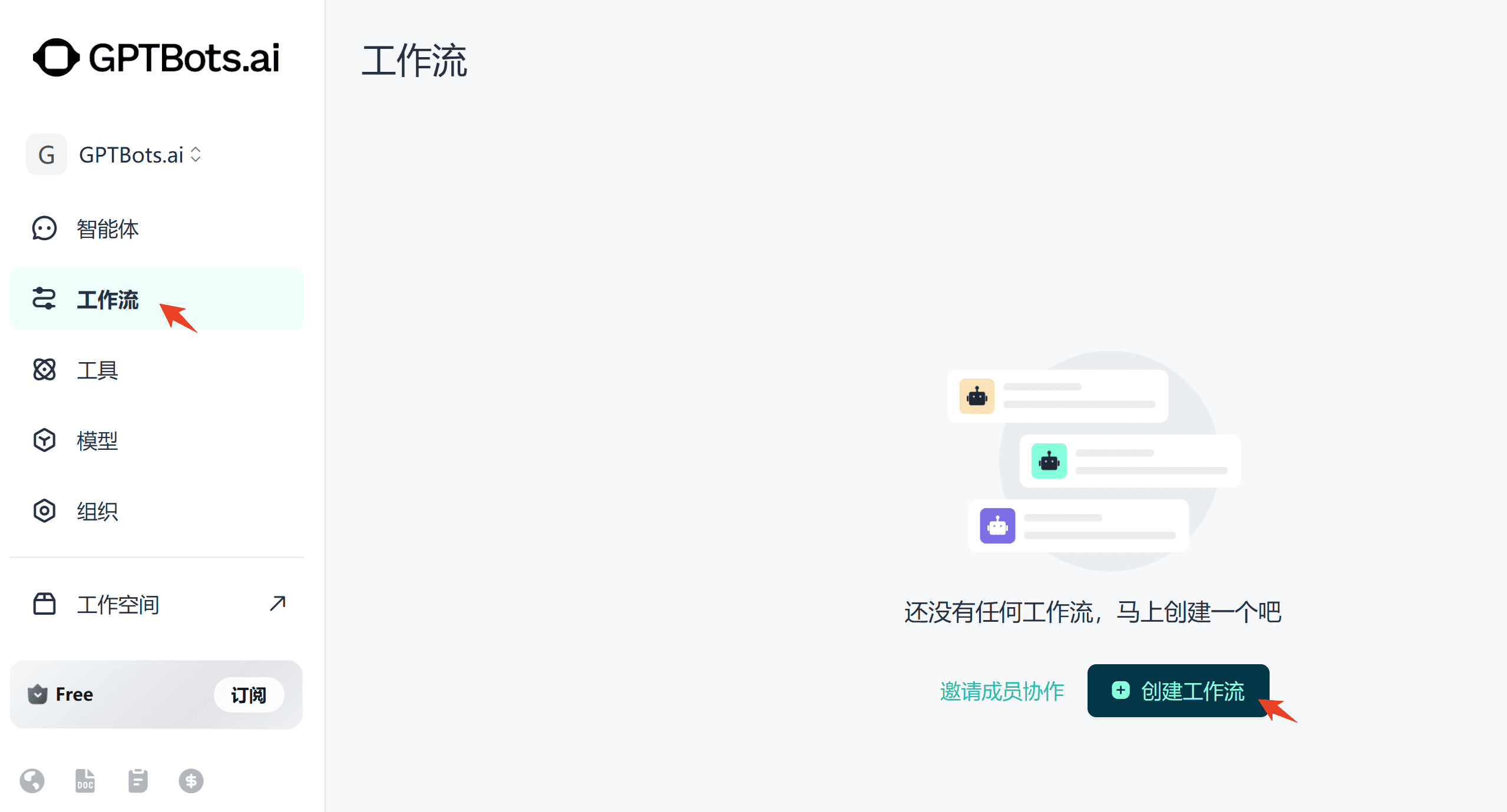

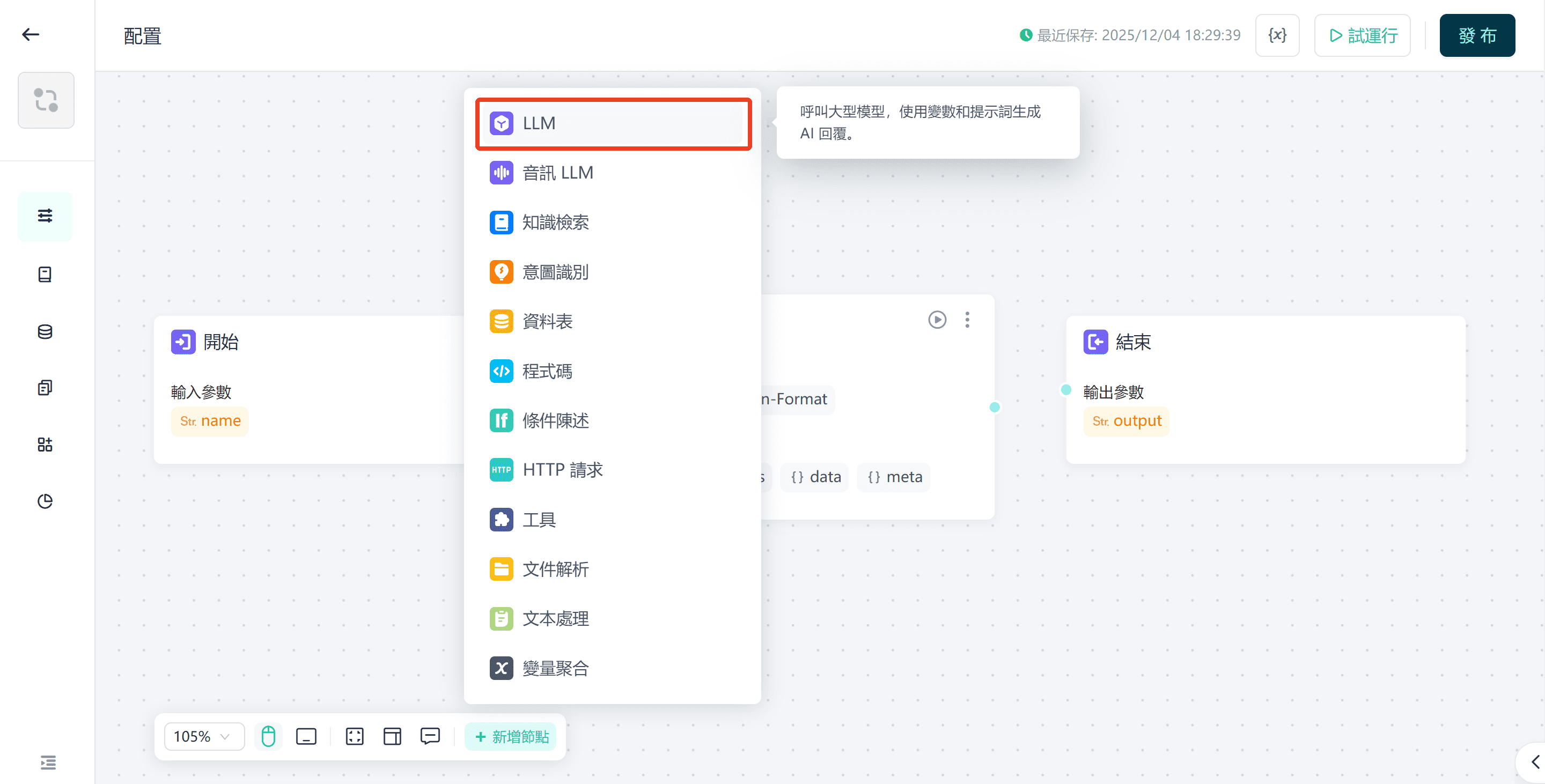

步骤 1. 创建一个工作流。

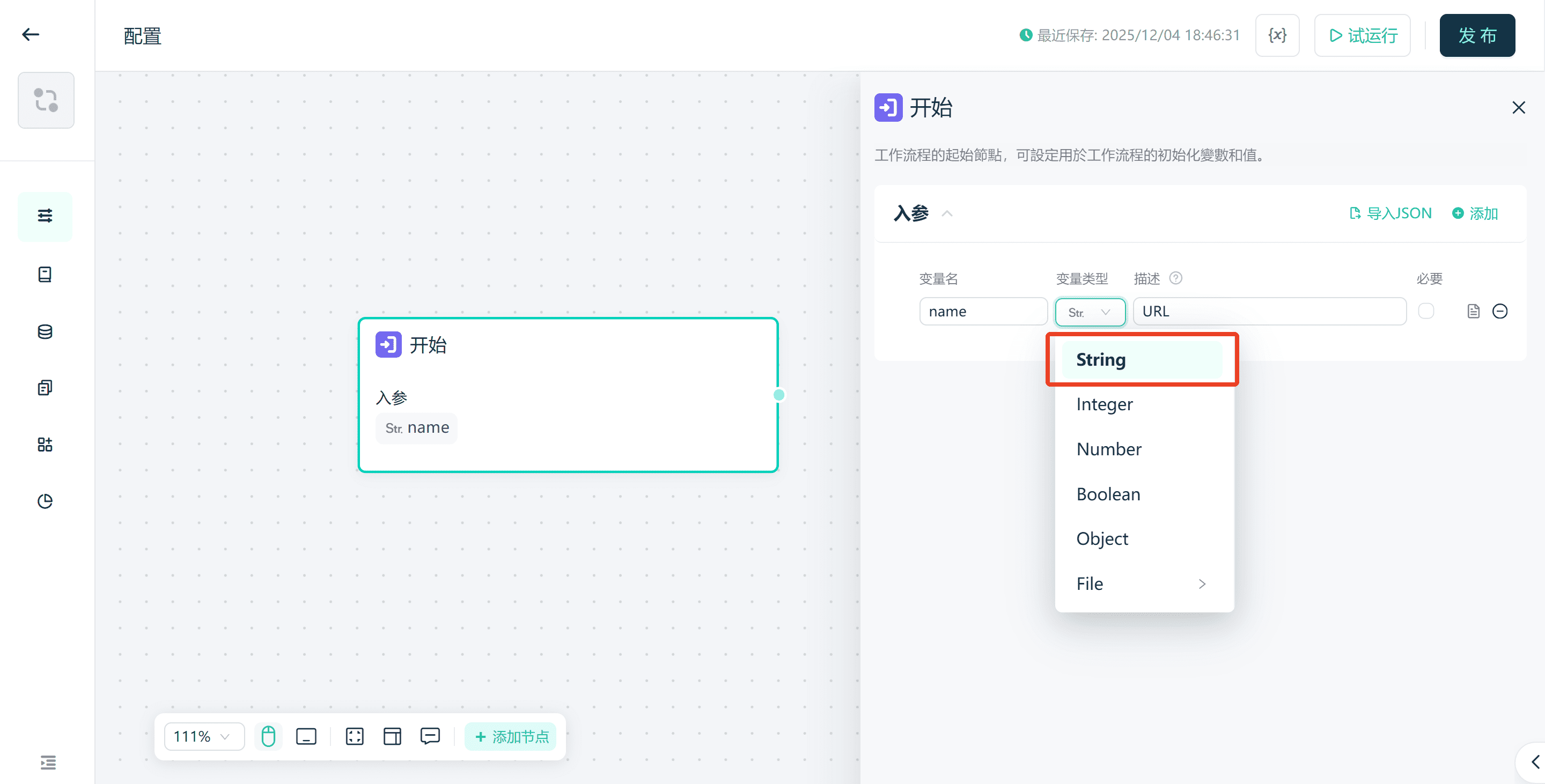

步骤 2. 请仅初始化开始和结束组件。首先,为开始组件定义输入。开始组件的输入参数需要定义为字符串类型的URL参数。

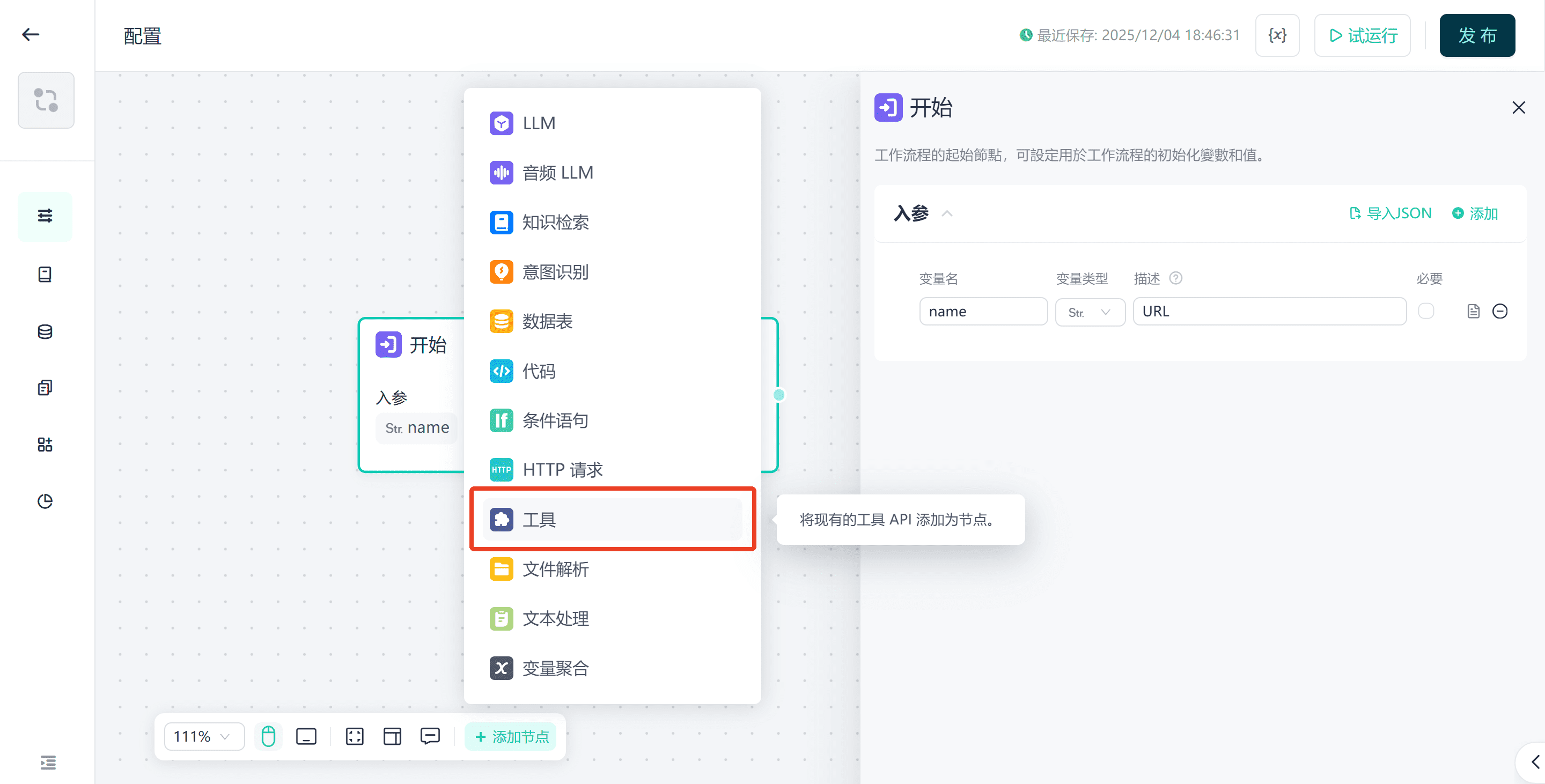

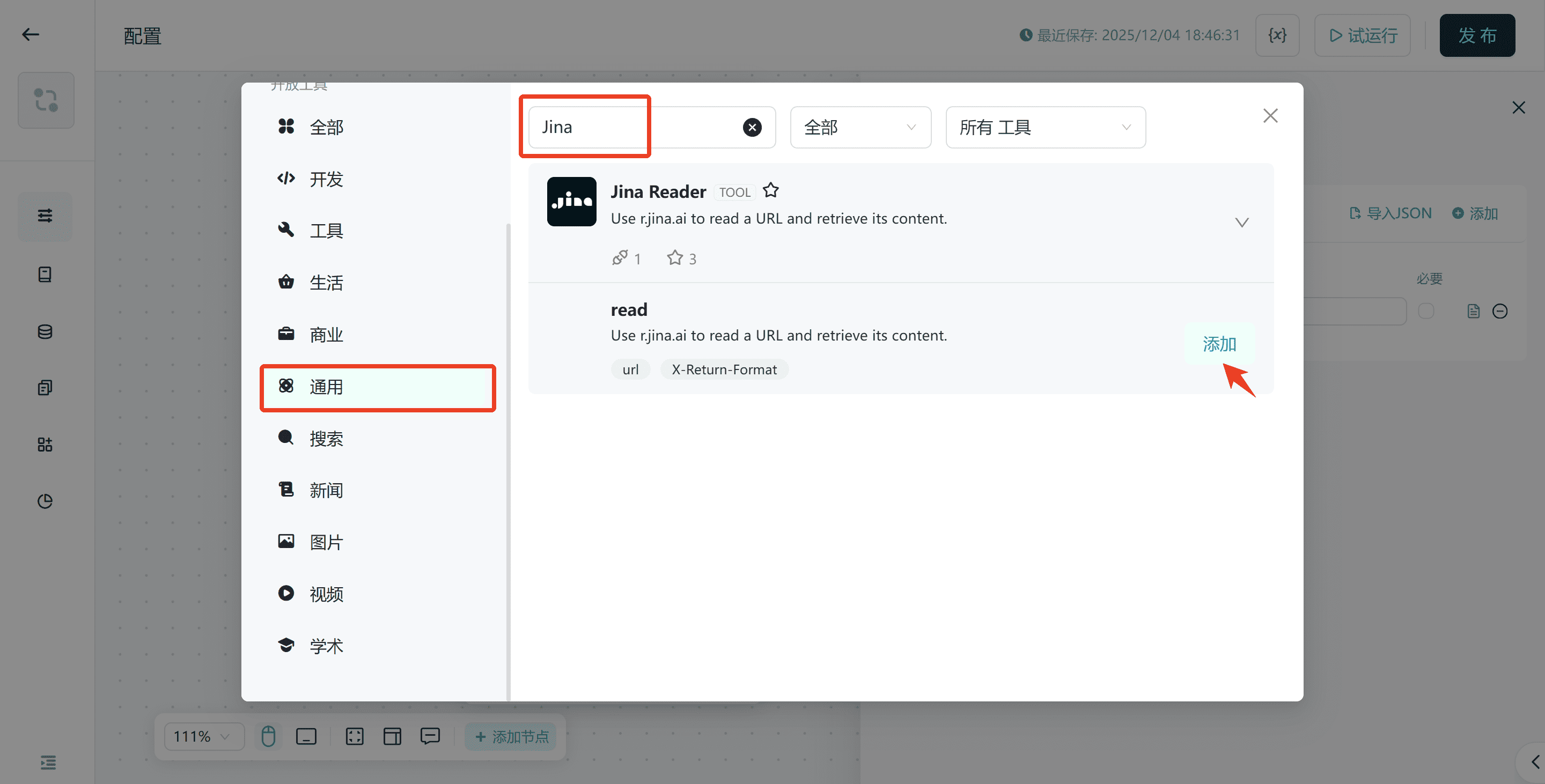

步骤 3. 从工具中导入Jina HTML Reader组件。其功能是解析URL并获取网页的HTML源代码。此过程无需编写代码。

连接到起始组件,并将起始/输入中的URL参数传递给Jina Reader(HTML读取器)组件。

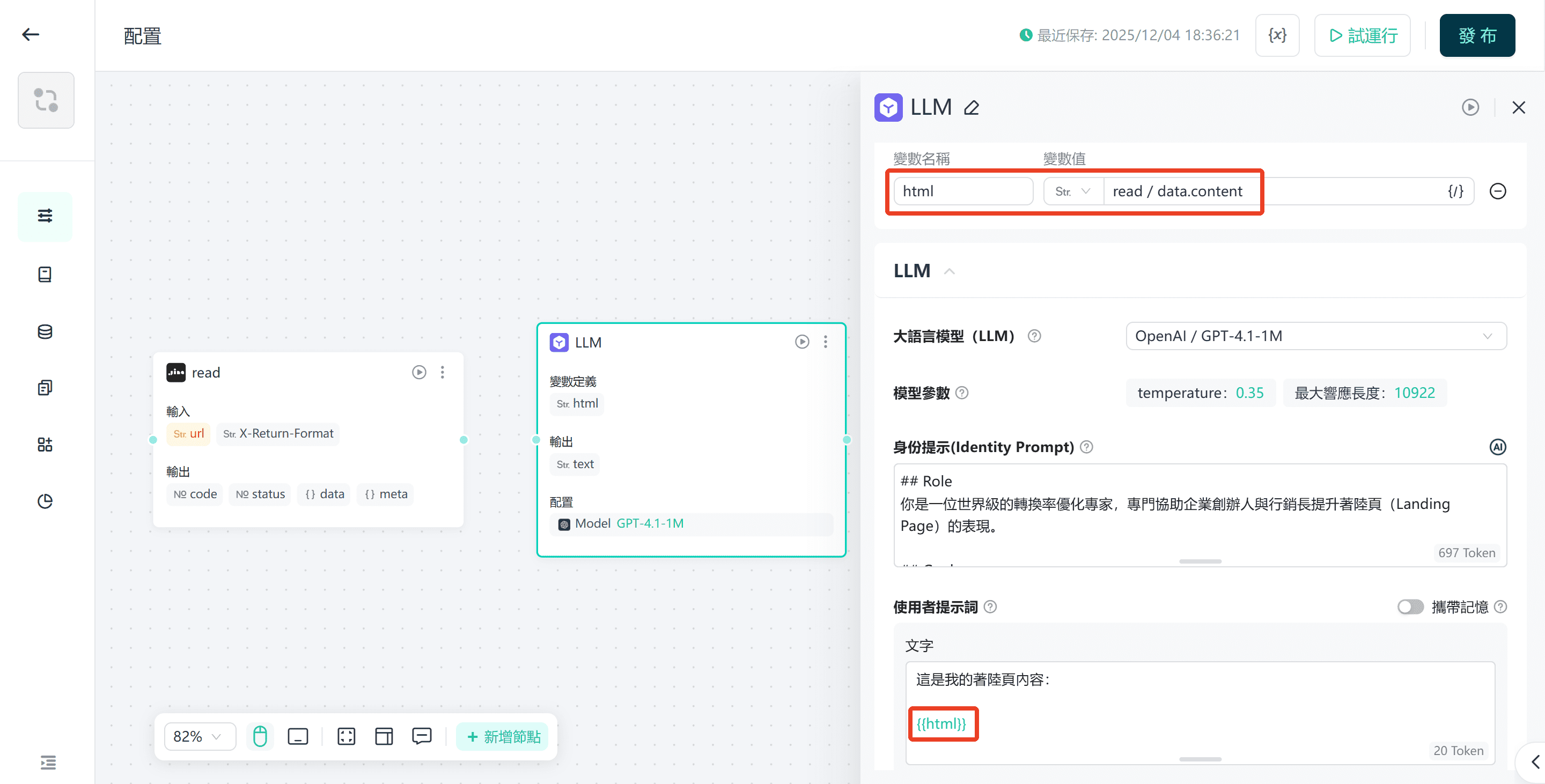

步骤 4. 添加用于AI分析的LLM(大语言模型)组件。

将Jina Reader连接到LLM,并将网页内容传递给LLM进行分析。

设置提示语,用于指导大语言模型的分析任务。

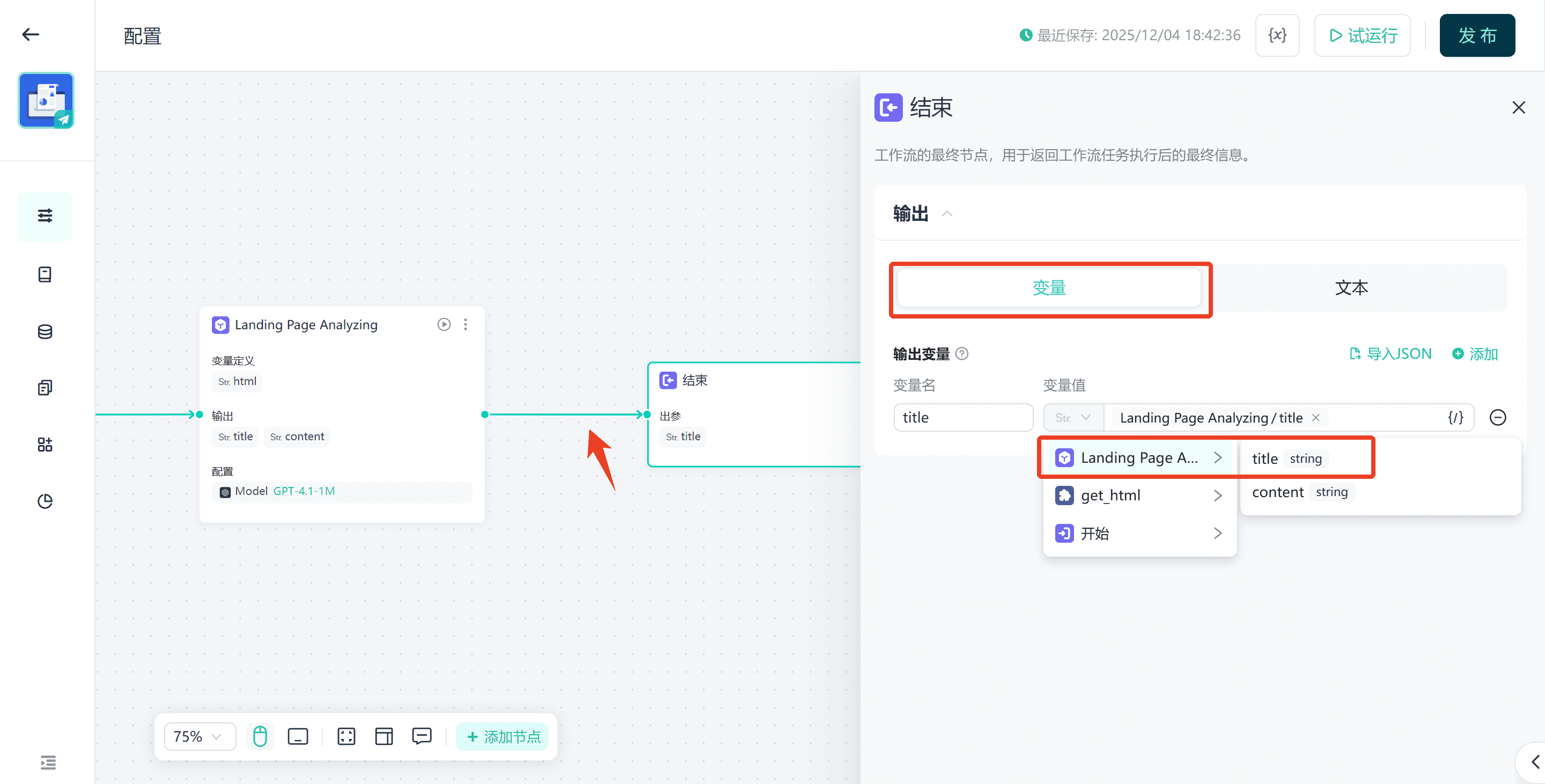

步骤 5. 连接结束组件,并将LLM的输出作为结果。

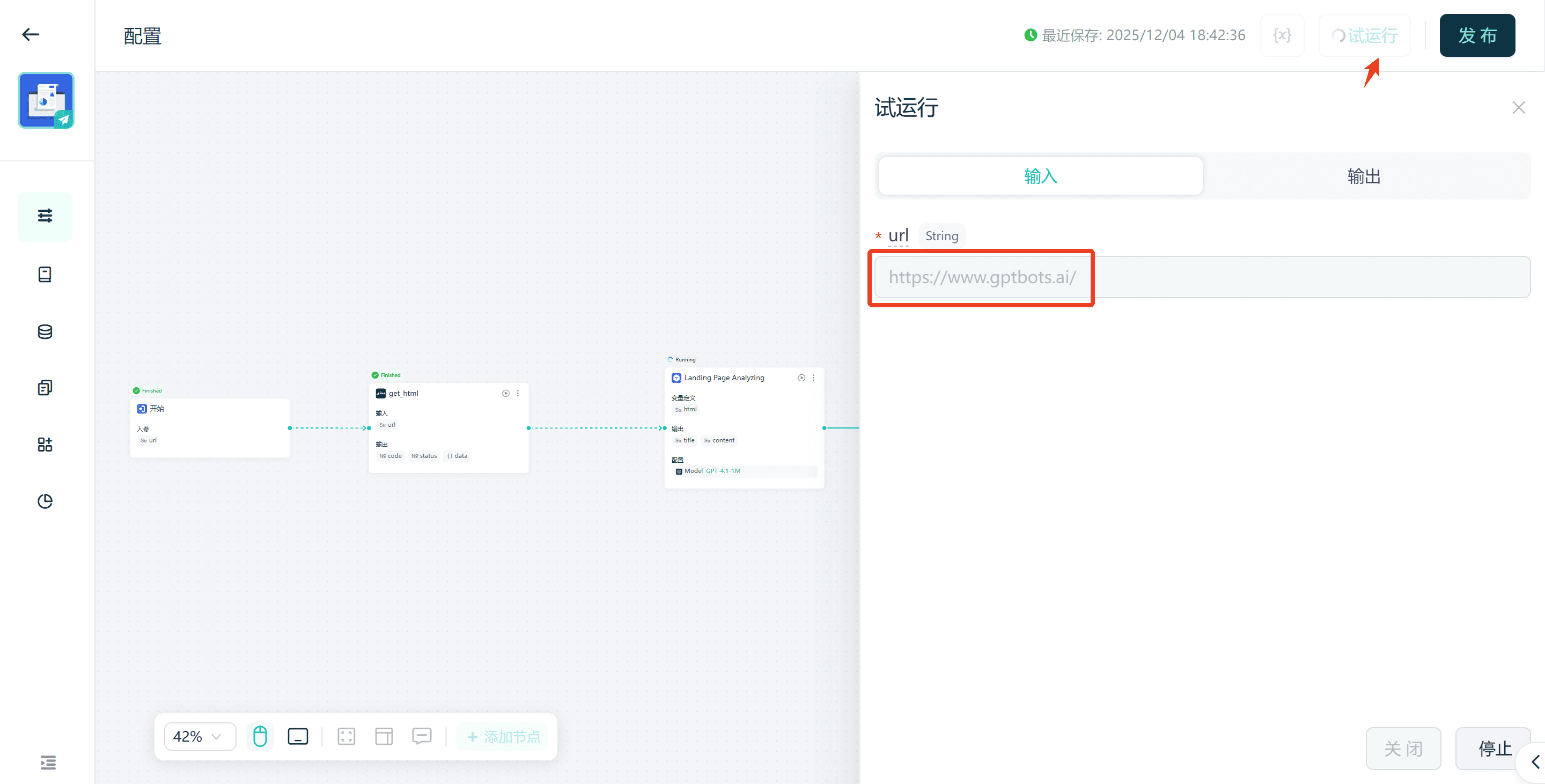

步骤 6. 点击测试运行按钮,在弹出的输入框中输入测试URL并执行,以验证工作流的正确性。

就是这样,您可以快速使用GPTBots构建一个AI网页爬虫智能体。

总结

AI网页爬虫技术正成为2026年企业获取与运营网页数据的关键利器。随着动态内容与JavaScript密集型网站的普及,传统爬虫工具的局限性愈发明显,无法满足现代企业对稳定性、规模化与实时性的需求。

领先的AI网页爬虫工具如GPTBots、Apify、Octoparse、BrightData正在帮助B2B企业构建更智能、更高效的数据采集体系。这些平台结合机器学习、自然语言处理与自适应解析技术,可自动理解网页内容,持续稳定输出结构化数据,无需频繁维护,大幅降低成本并提升洞察质量。

企业也可以进一步通过构建网页爬虫AIAgent来强化数据采集与决策流程。而借助 GPTBots 的无代码可视化构建器,即使无需任何工程能力,也能轻松打造并扩展具备上下文理解能力的智能爬虫,是B端团队快速落地AI爬虫方案的理想起点。

点击此处探索GPTBots无代码构建能力