En el ámbito de la inteligencia artificial, los grandes modelos de lenguaje (LLM) se entrenan a partir de conjuntos de datos previamente entrenados para obtener parámetros que permitan ajustar los resultados. Aunque las capacidades de los modelos aumentan con más parámetros, tanto los modelos pequeños especializados como los grandes modelos más populares y de mejor rendimiento comparten una desventaja común: no pueden responder de forma precisa o correcta a cuestiones ajenas al conjunto de entrenamiento (diferentes de los conjuntos de validación y prueba, como noticias en tiempo real, información empresarial no divulgada, etc.) y tienden a inventar respuestas, lo que se conoce como el problema de las alucinaciones en los LLM.

Para resolver este problema y evitar los costes de ajuste fino o reentrenamiento, han surgido los plugins para LLM como solución. Al combinar las potentes capacidades de generación de contenido y comprensión contextual de los modelos de lenguaje con datos y funciones específicas proporcionadas por los plugins, no solo se amplían los ámbitos de aplicación de los LLM, sino que también aumenta la fiabilidad de los resultados generados, ofreciendo un mejor servicio a los usuarios.

Parte 1. ¿Qué son los plugins?

Un plugin es un componente de software que puede añadirse a una aplicación o sistema principal para ampliar sus capacidades o proporcionar funciones adicionales.

Los plugins suelen estar diseñados para instalarse y desinstalarse de forma independiente y pueden interactuar con la aplicación principal. La funcionalidad de un plugin depende del ámbito de aplicación y de la aplicación concreta. Con el rápido desarrollo de la inteligencia artificial, los plugins para LLM han surgido con fuerza, cambiando la forma en que existen los plugins, que es el enfoque principal de este artículo.

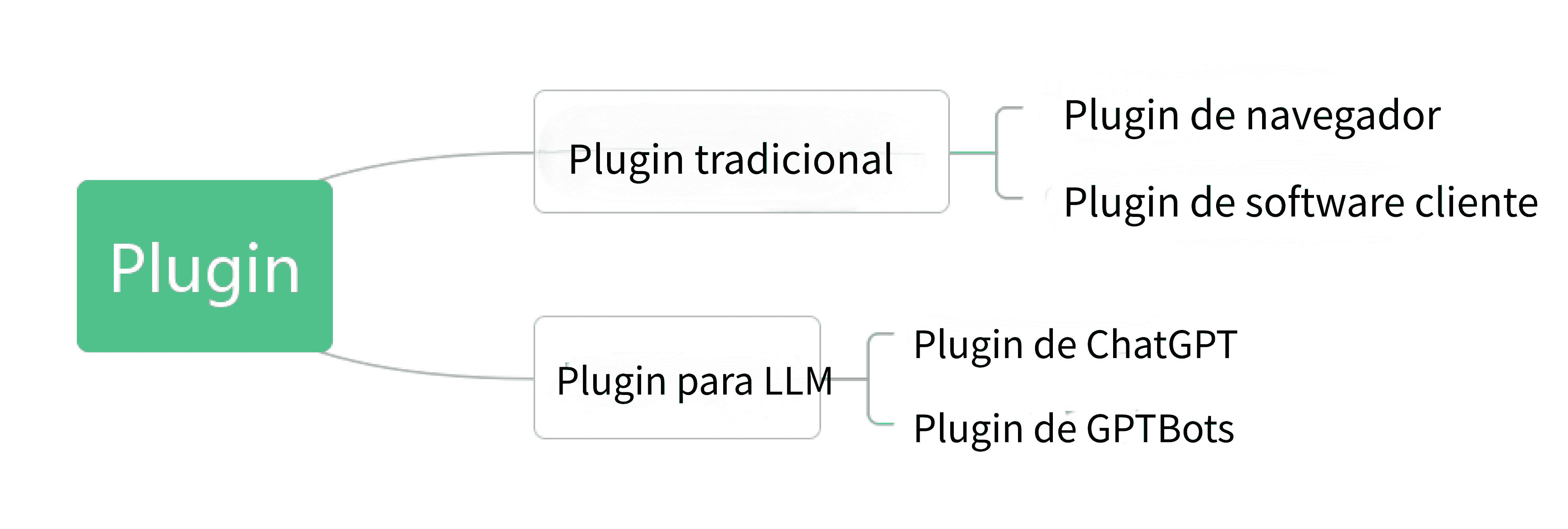

Según el desarrollo actual de los plugins para LLM, las clasificaciones de plugins son las siguientes:

1. Plugins tradicionales

Los plugins tradicionales (también conocidos como add-in, add-on, addon; en español, complementos o extensiones) son programas desarrollados conforme a ciertas especificaciones de la interfaz de programación de aplicaciones. Solo pueden ejecutarse en las plataformas del sistema especificadas por el programa (pueden ser compatibles con varias plataformas a la vez) y no pueden funcionar de forma independiente fuera de la plataforma indicada. Es decir, el funcionamiento del plugin depende del software anfitrión y no se pueden activar o desactivar las funciones del plugin de forma selectiva.

Los plugins tradicionales pueden dividirse en plugins de navegador y plugins de software cliente. La existencia de los plugins tradicionales se muestra en la siguiente imagen.

2. Plugins para LLM

Los plugins para LLM son un tipo de plugin completamente nuevo surgido con el desarrollo de los grandes modelos de lenguaje.

El núcleo de los plugins para LLM es la Web API, independiente de los grandes modelos de lenguaje. El proceso de desarrollo de plugins no está limitado por los modelos de lenguaje y no existen restricciones en los lenguajes de desarrollo, lo que los hace más universales. Siempre que la Web API siga las reglas relacionadas con RESTful, se pueden crear plugins para LLM.

Al configurar plugins para grandes modelos de lenguaje, se deben seguir reglas de configuración, como la configuración nativa de plugins de ChatGPT que sigue el formato OpenAPI y añade las descripciones pertinentes. Los grandes modelos de lenguaje y los plugins son dos partes relativamente independientes. La relación entre ambos se muestra en la siguiente imagen.

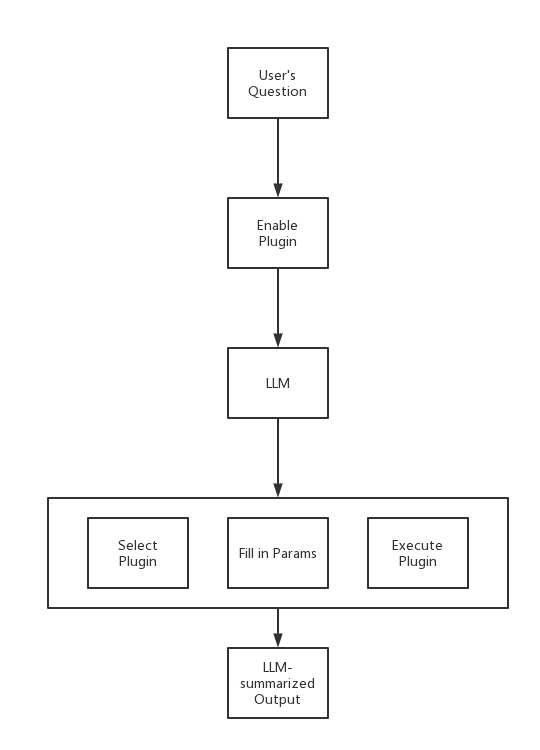

Los grandes modelos de lenguaje actúan como selectores de plugins, utilizando las funciones de los plugins según la demanda, es decir, solo se llaman los plugins cuando la pregunta o los datos del usuario cumplen las condiciones de uso, sin recurrir indiscriminadamente a todas las funciones de los plugins.

El flujo de trabajo de los plugins para LLM se muestra en la imagen siguiente.

Parte 2. ¿Qué son los plugins para LLM y cómo crearlos y utilizarlos?

Los plugins para LLM se dividen en dos tipos: plugins de ChatGPT y plugins de plataformas de bots de IA personalizadas, tomando como ejemplo GPTBots.

1. Plugins de ChatGPT

Actualmente, el modelo de lenguaje comercial más potente es ChatGPT-3.5/4.0 de OpenAI. Ambos admiten funciones de plugins (en adelante, denominados ChatGPT) y ofrecen a los desarrolladores la posibilidad de crear Web APIs como plugins de ChatGPT según sus necesidades.

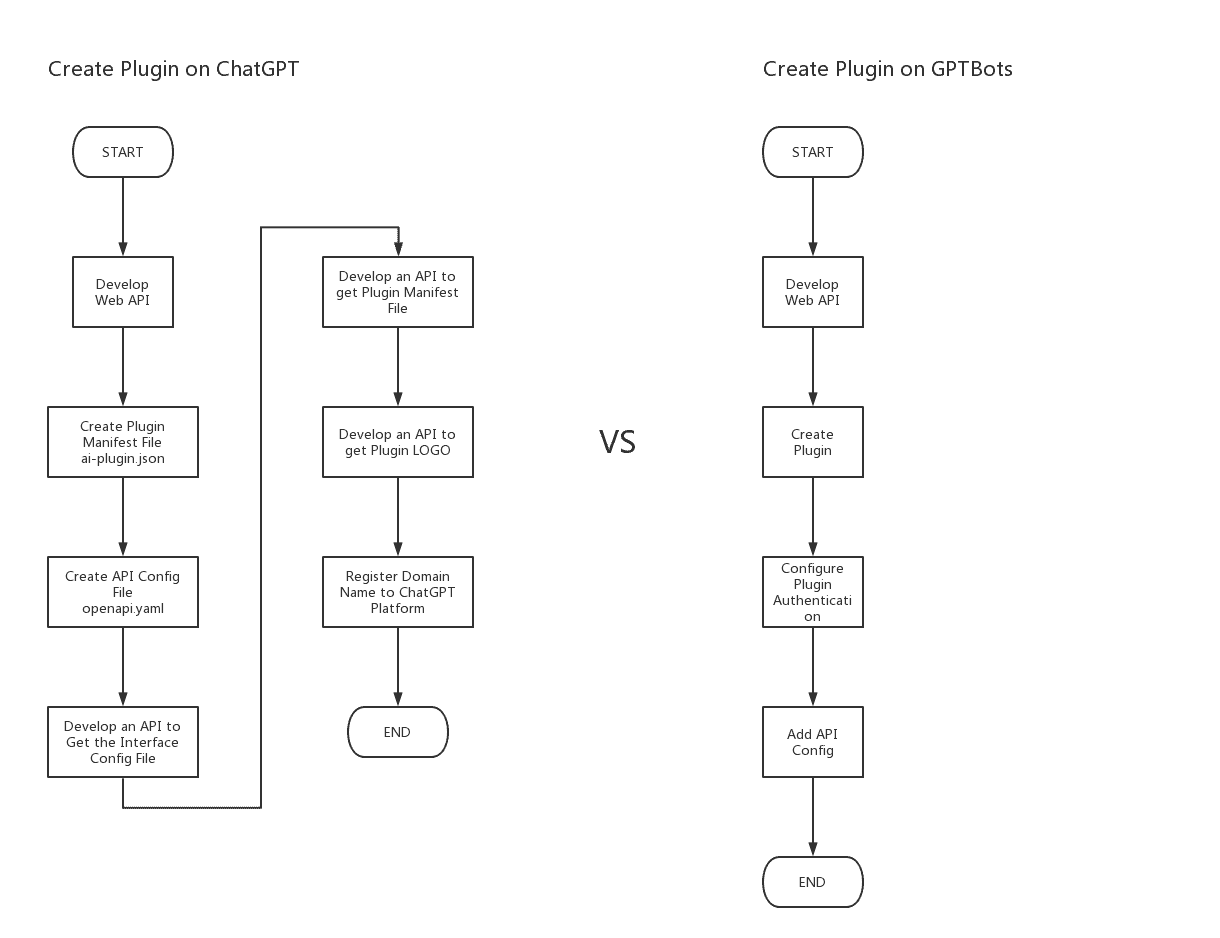

Sin embargo, la creación de plugins en ChatGPT resulta bastante compleja.

A continuación, se compara el proceso de creación de plugins en GPTBots. Los procesos de creación de plugins en ambos casos se muestran en la siguiente imagen (izquierda: creación de plugin en ChatGPT; derecha: creación de plugin en GPTBots).

2. Plugins de plataformas de bots de IA personalizadas - Plugins (herramientas) de GPTBots

El enfoque técnico de los plugins de GPTBots es diferente al de ChatGPT. Los plugins de GPTBots integran las especificaciones de creación de plugins de ChatGPT (especificaciones OpenAPI comunes) y las capacidades de invocación de funciones. Esto aporta las siguientes ventajas:

- Los desarrolladores solo tienen que centrarse en desarrollar sus propias interfaces funcionales, sin necesidad de crear interfaces adicionales.

- La configuración de plugins sigue las especificaciones OpenAPI. Los desarrolladores pueden reutilizar directamente los plugins para ChatGPT Web y publicarlos en GPTBots con un solo clic.

- Los plugins de GPTBots son compatibles automáticamente con los principales LLM que ya disponen de capacidades de plugins. Los desarrolladores no tienen que adaptarse a cada LLM por separado.

Tras comparar los procesos de creación de plugins, vemos que para utilizar los plugins de GPTBots solo hacen falta cuatro pasos: desarrollar la interfaz del plugin, crear un nuevo plugin, configurar la autenticación del plugin y añadir la configuración de la interfaz conforme a las especificaciones OpenAPI. El resto lo gestiona GPTBots. A continuación, repasamos cómo crear un plugin (herramienta) en GPTBots.

-

1

Desarrollar la interfaz del plugin

Este paso es igual que en ChatGPT nativo. Los desarrolladores deben crear la interfaz del plugin por sí mismos. Sin embargo, en GPTBots no es necesario desarrollar una interfaz de manifiesto del plugin, una interfaz de configuración de información ni una interfaz de logotipo del plugin por separado. Solo hay que centrarse en la interfaz funcional del plugin. -

2

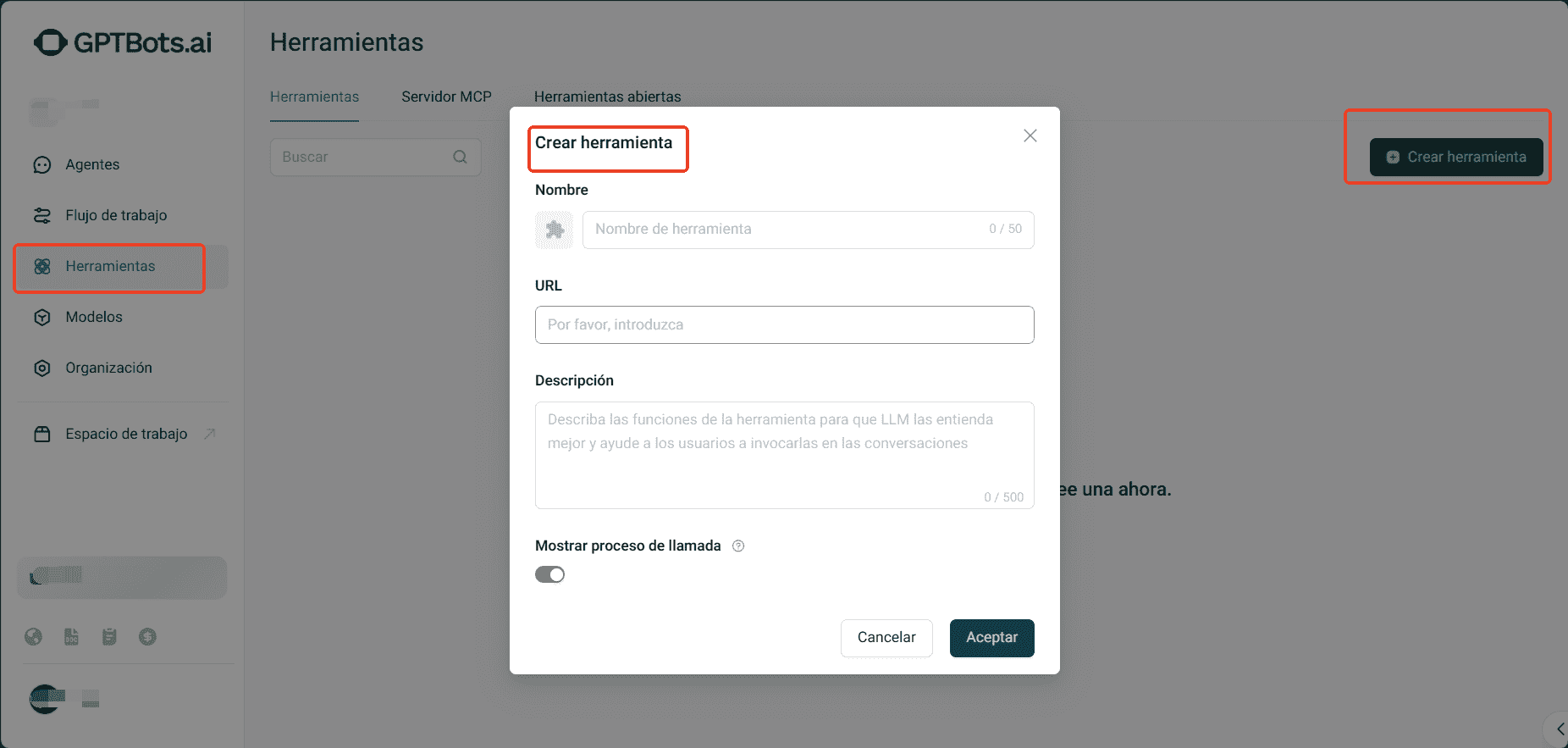

Crear un nuevo plugin

Iniciar sesión en tu cuenta de GPTBots y acceder al panel de administración. Haz clic en herramientas en el menú lateral para ir a la lista de herramientas. Después, pulsa en Crear herramienta y rellena el formulario de creación, incluyendo el nombre de la herramienta, la API a la que se conecta y la introducción de la herramienta, que describe sus funciones para ayudar al LLM a comprenderlas mejor y facilitar su uso durante las conversaciones.

-

3

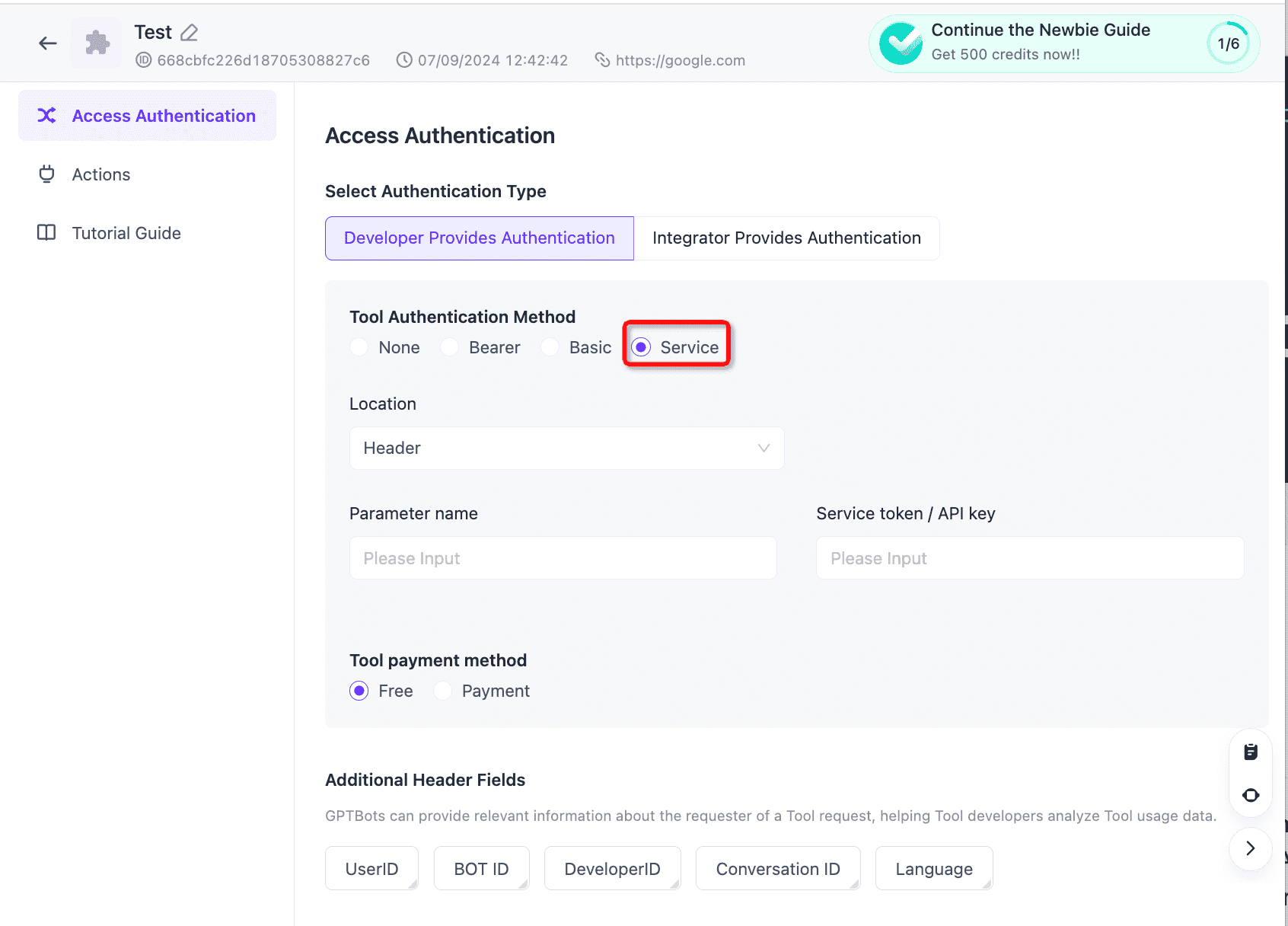

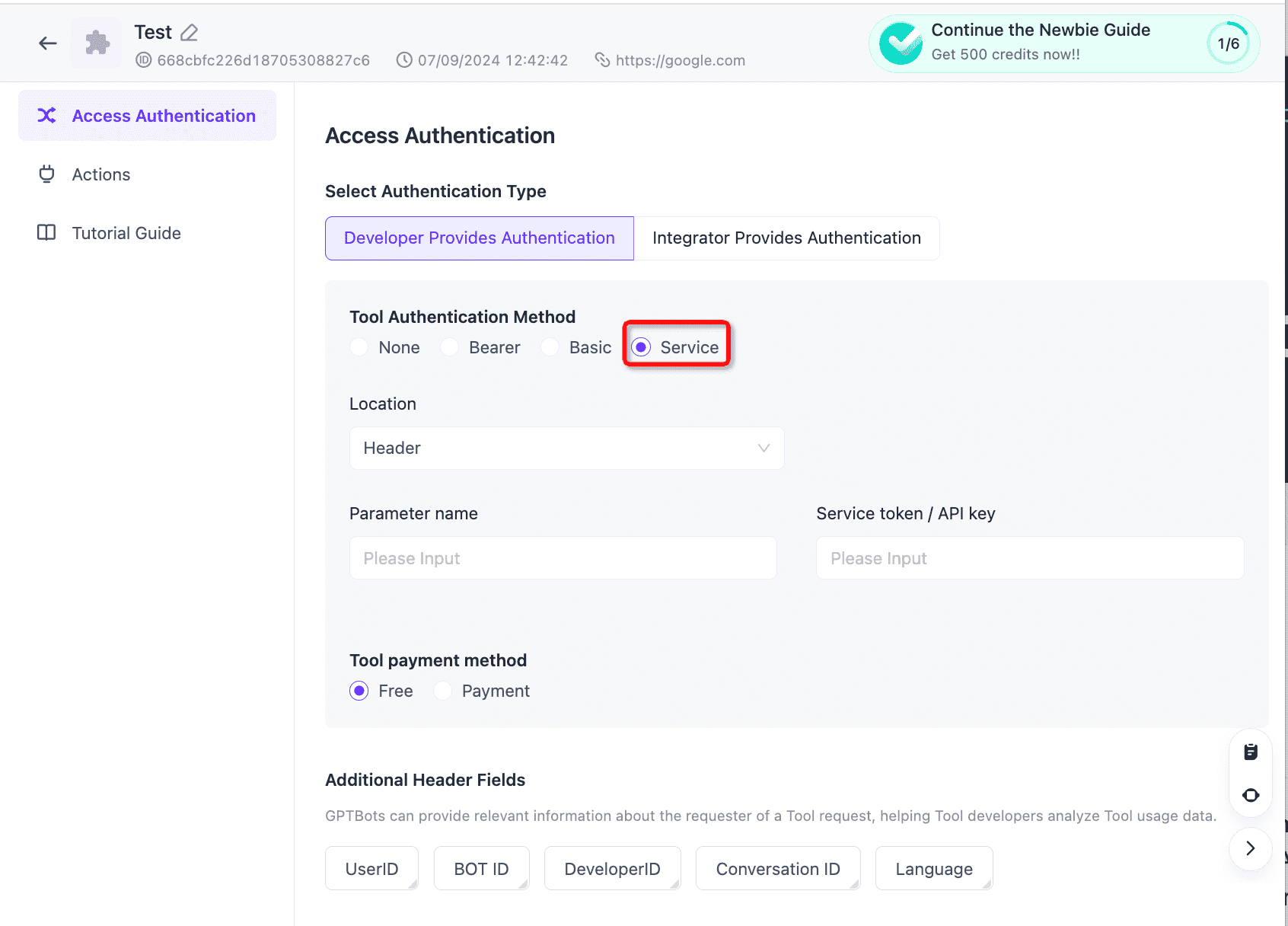

Configurar la autenticación del plugin

Los plugins de GPTBots ofrecen 4 métodos de autenticación: sin autenticación, autenticación básica, autenticación Bearer y autenticación de servicio (personalizada). El proceso de configuración se muestra a continuación.

-

4

Crear acciones

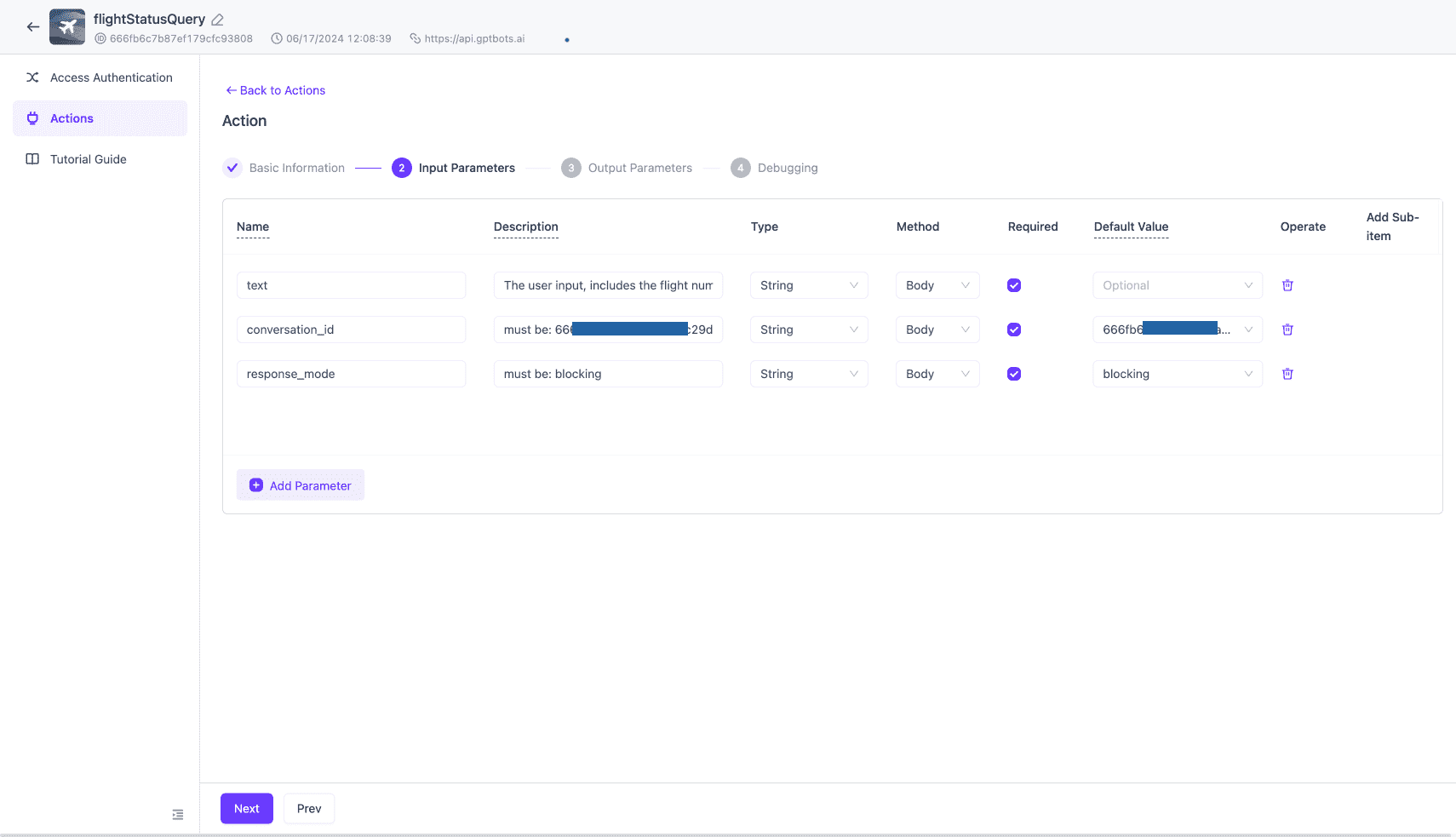

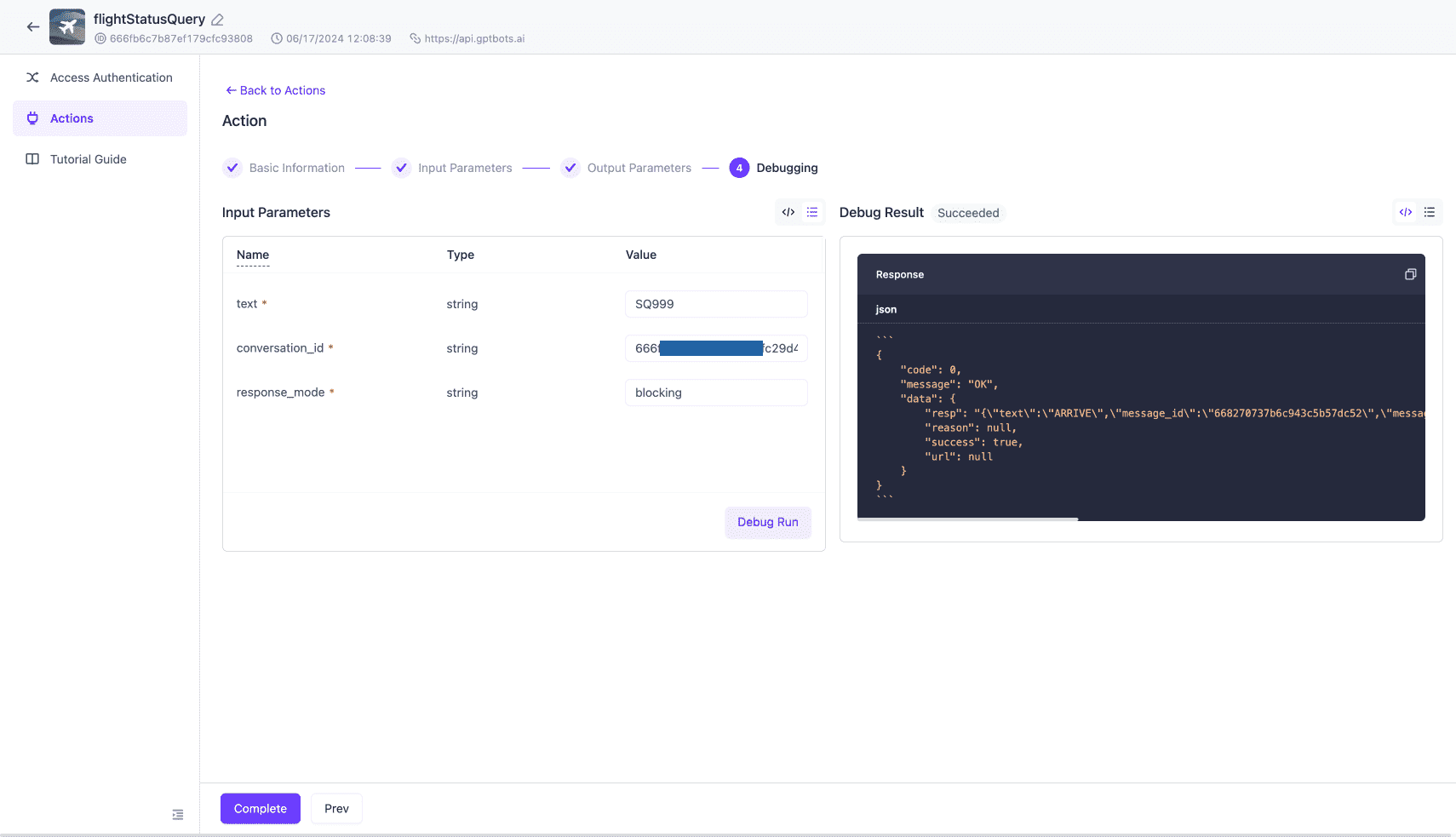

Una acción equivale a una llamada a una API. Una herramienta puede contener varias acciones. Puedes crear directamente una herramienta redactando un documento JSON conforme a la especificación OpenAPI para la API.Primero, rellena el nombre, la descripción y la dirección del servicio de la herramienta. Después, haz clic en "Siguiente" para guardar.

2. A continuación, indica los parámetros de entrada.

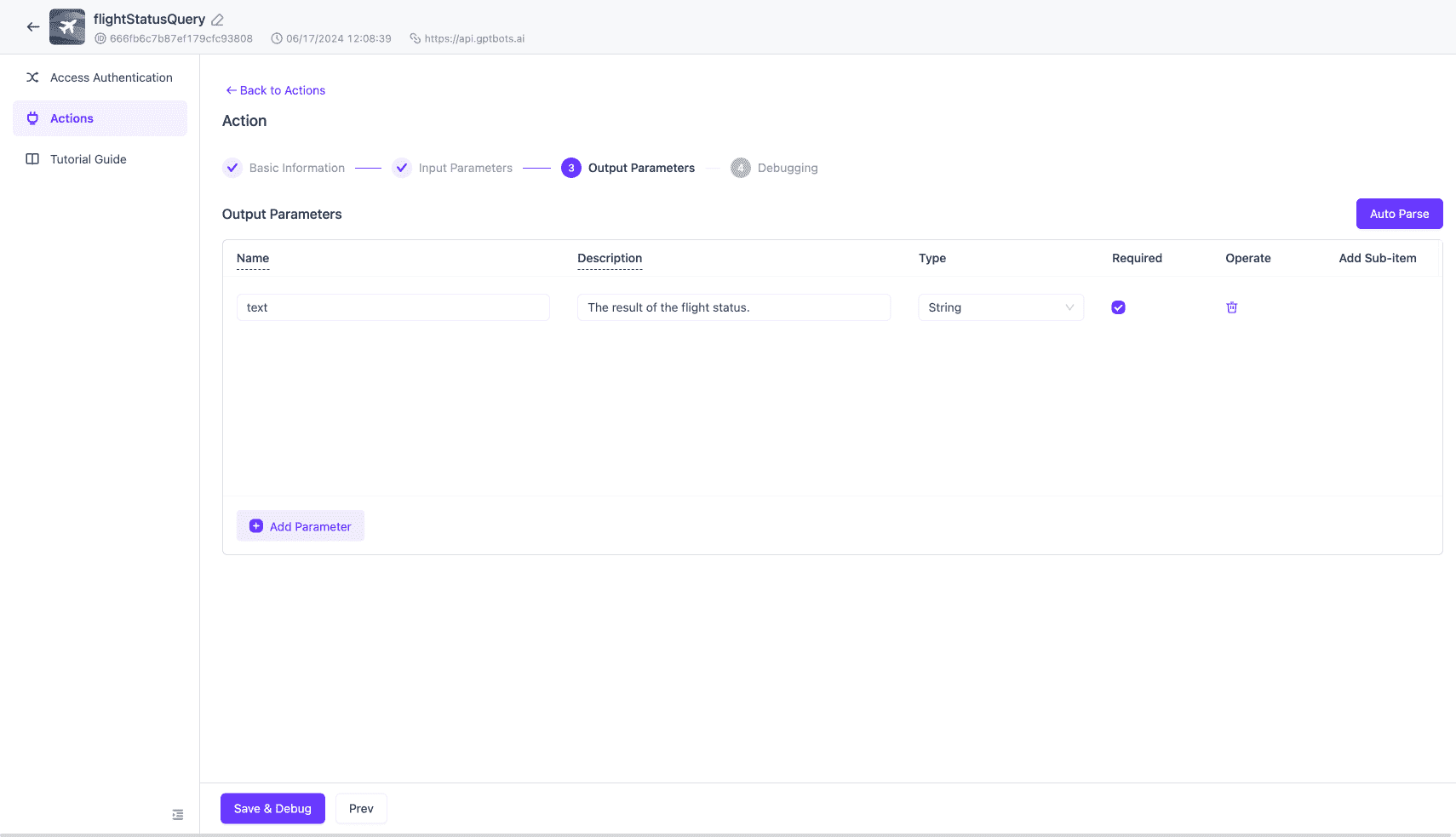

3. Después, indica los parámetros de salida. Los parámetros de salida pueden dejarse en blanco, pero rellenarlos ayuda a que el LLM comprenda mejor el significado de los campos de salida y mejore su rendimiento. Puedes usar la función 'auto parse' para que el sistema complete automáticamente los parámetros de salida.

4. Finalmente, mediante la depuración para verificar que la API se llama correctamente, puedes completar la creación de una acción. Una vez configurada la autenticación y la información de las acciones, la herramienta estará completamente lista para usar.

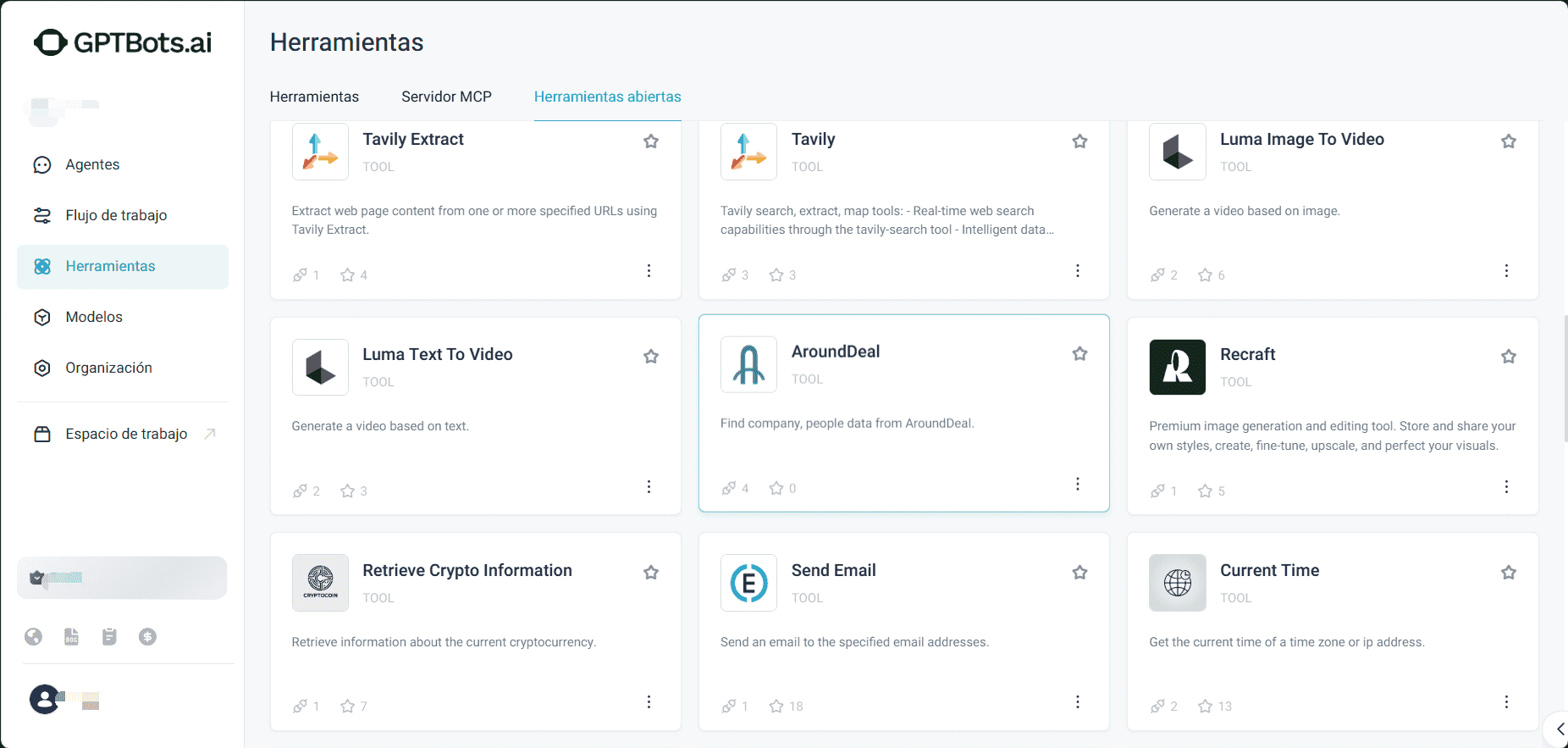

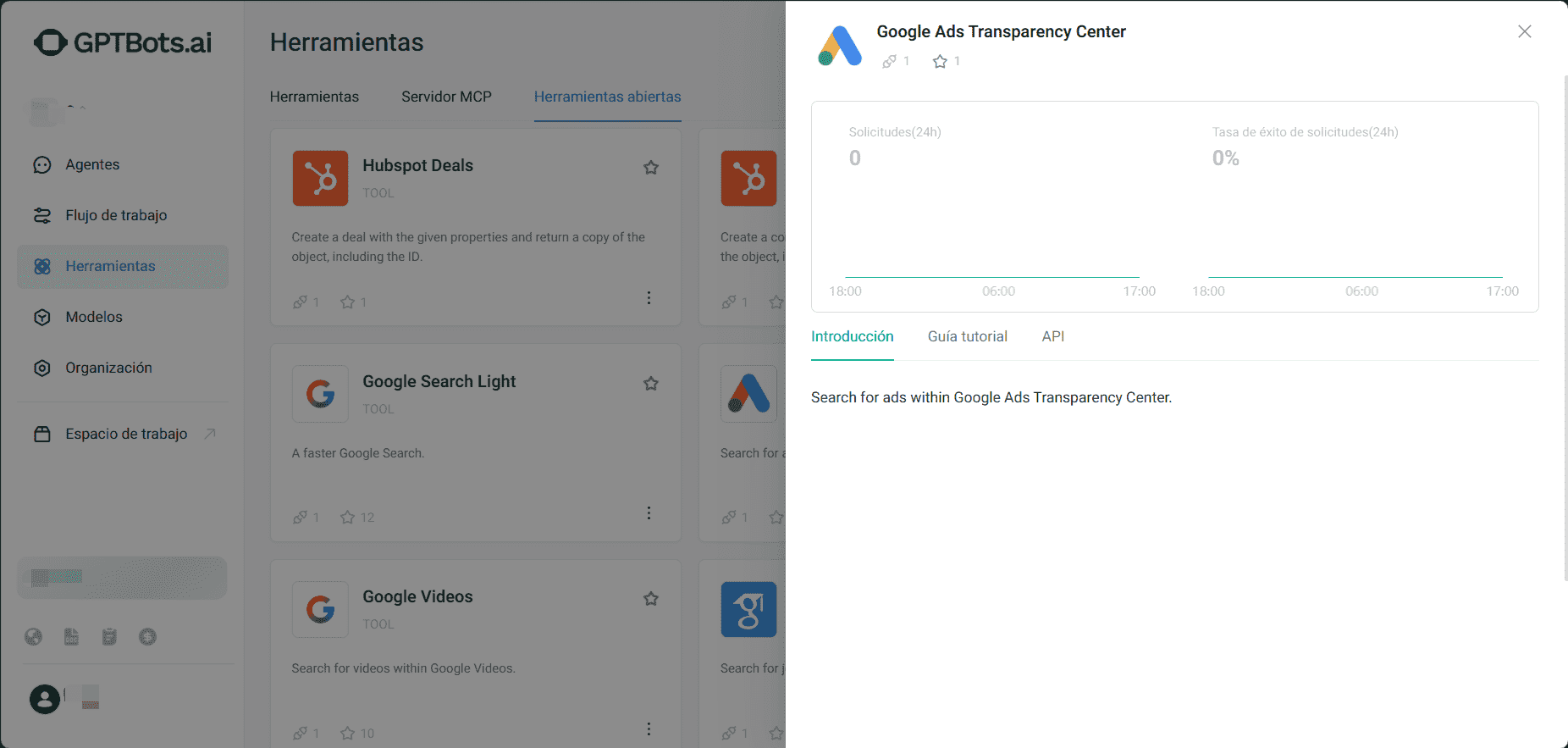

Parte 3. Mercado abierto de herramientas (plugins) de GPTBots

Accede al portal de GPTBots y haz clic en "Herramientas Open Tools". Encontrarás una gran variedad de herramientas (es decir, plugins mencionados anteriormente), tanto gratuitas como de pago, para desarrollo, redacción SEO o traducción, vida diaria (consulta meteorológica), procesamiento de imagen y vídeo, etc.

Cada herramienta puede consultarse para ver su información específica, incluyendo una introducción, uso, parámetros de entrada y salida, etc. En la siguiente imagen se muestra un ejemplo de herramientas que utilizan GPT4 para convertir imágenes en texto.

Reflexiones y perspectivas

En aplicaciones empresariales reales, debido al límite de tokens por llamada a un LLM y a que los plugins inevitablemente consumen tokens, no es posible utilizar varios plugins en una sola petición. Además, si el protocolo de un plugin es demasiado complejo, puede provocar fallos en la llamada directa.

Para resolver mejor estos problemas, la plataforma GPTBots ha lanzado la función Flow. Los desarrolladores pueden orquestar varios LLM para participar en el procesamiento empresarial en diferentes pasos. Cada LLM puede añadir hasta 3 plugins, lo que soluciona muy bien la restricción de uso de plugins. Al mismo tiempo, al reducir la longitud del contexto de la petición, el LLM puede centrarse más y así mejorar la tasa de éxito de las llamadas a plugins.

Los plugins para LLM son diferentes de los tradicionales: son independientes, flexibles, libres y potentes. El núcleo de los plugins para LLM es la Web API, por lo que se integran plenamente en Internet y no existe discriminación por el lenguaje de desarrollo utilizado. Siempre que los desarrolladores puedan crear interfaces bajo el protocolo HTTP y sigan las reglas RESTful, es posible construir plugins para LLM, independientemente de si el stack de desarrollo es Python, Java, Go, PHP, etc. Se prevé que en el futuro los tipos y capacidades de los plugins para LLM serán cada vez más variados y potentes. Frente al proceso engorroso de creación de plugins en ChatGPT, la plataforma GPTBots lo simplifica, haciéndolo sencillo, eficiente y fácil de usar, lo que mejora la productividad de los desarrolladores, reduce los costes de aprendizaje y, sin duda, atraerá a más desarrolladores a elegir la plataforma GPTBots en el futuro.

Empezar gratis